Cerebras Systems ha presentado su chip de motor a escala de oblea de tercera generación, el WSE-3, que ofrece 900.000 núcleos optimizados para IA construidos para entrenar hasta 24 billones de parámetros.

Cerebras WSE-3 es el chip de IA más grande del planeta: billones de transistores para entrenar modelos de IA con billones de parámetros

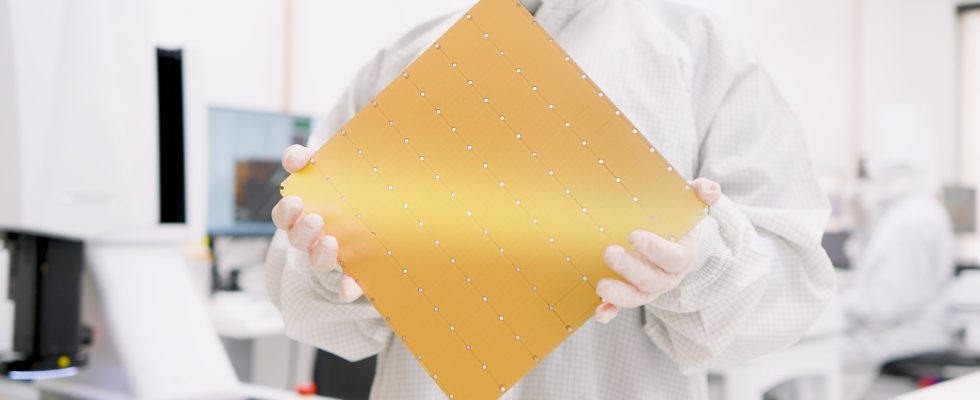

Desde el lanzamiento de su primer chip Wafer Scale Engine (WSE), Cerebras no ha mirado atrás y ahora se ha presentado su solución de tercera generación con especificaciones increíbles que deberían darse por sentado debido a su gran tamaño. Como sugiere el nombre, el chip es esencialmente una oblea entera de silicio y esta vez, Cerebras está apostando por la moda de la IA con algunas especificaciones poderosas que se destacan a continuación:

- 4 billones de transistores

- 900.000 núcleos de IA

- 125 petaflops de rendimiento máximo de IA

- 44 GB en chip SRAM

- Proceso TSMC de 5 nm

- Memoria externa: 1,5 TB, 12 TB, o 1,2 PB

- Entrena modelos de IA con hasta 24 billones de parámetros

- Tamaño de clúster de hasta 2048 sistemas CS-3

Hablando del chip en sí, el Cerebras WSE-3 tiene un tamaño de matriz de 46.225 mm2, que es 57 veces más grande que el NVIDIA H100, que mide 826 mm2. Ambos chips se basan en el nodo de proceso TSMC de 5 nm. El H100 está considerado como uno de los mejores chips de IA del mercado con sus 16.896 núcleos y 528 núcleos tensoriales, pero es eclipsado por el WSE-3, que ofrece la increíble cantidad de 900.000 núcleos optimizados para IA por chip, un aumento de 52 veces.

El WSE-3 también tiene grandes cifras de rendimiento que lo respaldan con 21 petabytes por segundo de ancho de banda de memoria (7000 veces más que el H100) y 214 petabits por segundo de ancho de banda de Fabric (3715 veces más que el H100). El chip incorpora 44 GB de memoria integrada, que es 880 veces mayor que la del H100.

En comparación con el WSE-2, el chip WSE-3 ofrece núcleos 2,25 veces más altos (900K frente a 400K), SRAM 2,4 veces más alta (44 GB frente a 18 GB) y velocidades de interconexión mucho más altas, todo dentro del mismo tamaño de paquete. También hay un 54% más de transistores en el WSE-3 (4 billones frente a 2,6 billones).

Entonces, ¿cuál es el beneficio de todo este hardware? Bueno, el chip está diseñado primero para IA y ofrece 125 PetaFlops de rendimiento máximo de IA. La NVIDIA H100 ofrece alrededor de 3958 TeraFlops o alrededor de 4,0 PetaFlops de rendimiento máximo de IA, por lo que estamos hablando de un aumento de 31,25 veces. El chip también viene en una variedad de configuraciones de memoria externa que van desde 1,5 TB, 12 TB y hasta 1,2 PB. Con tanta potencia en un solo troquel, el chip puede entrenar modelos de IA con hasta 24 billones de parámetros.

| WSE-3 | NVIDIA H100 | Ventaja de Cerebras | |

| Tamaño de la viruta | 46.225 mm² | 826 mm² | 57x |

| Núcleos | 900.000 | 16.896 FP32 + 528 Tensores | 52X |

| Memoria en chip | 44 GB | 0,05 GB | 880X |

| Ancho de banda de memoria | 21 Petabytes/seg | 0,003 petabytes/seg | 7.000X |

| Ancho de banda de la tela | 214 Petabits/seg | 0,0576 Petabits/seg | 3.715x |

Además del chip de motor a escala de oblea WSE-3, Cerebras Systems también anuncia su supercomputadora de IA CS-3 que puede entrenar modelos 10 veces más grandes que GPT-4 y Gemini gracias a su enorme conjunto de memoria. La solución CS-3 AI está diseñada para usuarios empresariales y de hiperescala y ofrece una eficiencia de rendimiento mucho mayor en comparación con las GPU modernas.

64 de estos sistemas de IA CS-3 se utilizarán para alimentar la supercomputadora Condor Galaxy 3, que ofrecerá 8 ExaFlops de rendimiento informático de IA, duplicando el rendimiento del sistema con la misma potencia y costo. La compañía no ha compartido el precio o la disponibilidad de los chips WSE-3, pero se espera que cuesten mucho, y por mucho, me refiero a mucho más que el precio inicial de $ 25 a $ 30 mil para las GPU NVIDIA H100.