Imágenes Getty | aurich lawson

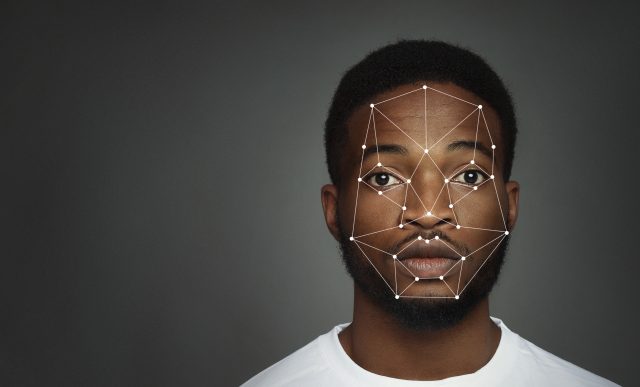

El uso de software de reconocimiento facial llevó a la policía de Detroit a arrestar falsamente a Porcha Woodruff, de 32 años, por robo y robo de auto, informa The New York Times. Con ocho meses de embarazo, fue detenida durante 11 horas, interrogada y le incautaron su iPhone como evidencia antes de ser liberada. Es el último de una serie de arrestos falsos debido al uso de tecnología de reconocimiento facial, que muchos críticos dicen que no es confiable.

El error parece particularmente notable porque las imágenes de vigilancia utilizadas para identificar falsamente a Woodruff no mostraban a una mujer embarazada, y Woodruff estaba visiblemente embarazada en el momento de su arresto.

El incidente comenzó con una búsqueda de reconocimiento facial automatizada por parte del Departamento de Policía de Detroit. Un hombre al que robaron denunció el delito y la policía usó DataWorks Plus para comparar imágenes de video de vigilancia con una base de datos de fotografías policiales. La foto policial de Woodruff de 2015 de un arresto anterior no relacionado se identificó como una coincidencia. Después de eso, la víctima confirmó erróneamente su identificación a partir de una fila de fotografías, lo que llevó a su arresto.

Woodruff fue acusado en la corte de robo y robo de auto antes de ser liberado con una fianza personal de $100,000. Un mes después, los cargos en su contra fueron desestimados por el fiscal del condado de Wayne. Woodruff presentó una demanda por arresto injustificado contra la ciudad de Detroit, y el jefe de policía de Detroit, James E. White, declaró que las acusaciones son preocupantes y que el asunto se está tomando en serio.

Según The New York Times, este incidente es el sexto caso reciente informado en el que una persona fue acusada falsamente como resultado de la tecnología de reconocimiento facial utilizada por la policía, y el tercero que tiene lugar en Detroit. Los seis individuos acusados falsamente han sido negros. El Departamento de Policía de Detroit realiza un promedio de 125 búsquedas de reconocimiento facial por año, casi exclusivamente en hombres negros, según datos revisados por The Times.

La ciudad de Detroit enfrenta actualmente tres demandas relacionadas con arrestos injustificados basados en el uso de tecnología de reconocimiento facial. Los grupos de defensa, incluida la Unión Estadounidense de Libertades Civiles de Michigan, piden más recopilación de pruebas en los casos que involucran búsquedas automáticas de rostros, así como el fin de las prácticas que han llevado a falsos arrestos.

«La confiabilidad del reconocimiento facial… aún no se ha establecido».

El arresto de Woodruff y la tendencia reciente de arrestos falsos han provocado una nueva ronda en un debate en curso sobre la confiabilidad de la tecnología de reconocimiento facial en las investigaciones criminales. Los críticos dicen que la tendencia destaca las debilidades de la tecnología de reconocimiento facial y los riesgos que representa para personas inocentes.

Es particularmente riesgoso para las personas de piel oscura. Una publicación de 2020 en el sitio web de la Universidad de Harvard por Alex Najibi detalla la discriminación racial generalizada dentro de la tecnología de reconocimiento facial, destacando investigaciones que demuestran problemas significativos para identificar con precisión a las personas negras.

Un informe de 2022 de Georgetown Law sobre el uso del reconocimiento facial en la aplicación de la ley encontró que «a pesar de 20 años de confianza en el reconocimiento facial como técnica de investigación forense, aún no se ha establecido la confiabilidad del reconocimiento facial como se usa típicamente en investigaciones criminales».

Además, una declaración de Georgetown en su informe de 2022 dijo que, como herramienta de investigación biométrica, el reconocimiento facial «puede ser particularmente propenso a errores derivados del juicio humano subjetivo, sesgo cognitivo, evidencia manipulada o de baja calidad y tecnología de bajo rendimiento» y que «no funciona lo suficientemente bien como para cumplir de manera confiable los propósitos para los cuales las propias agencias de aplicación de la ley quieren usarlo».

La baja precisión de la tecnología de reconocimiento facial proviene de múltiples fuentes, incluidos algoritmos no probados, sesgos en conjuntos de datos de entrenamiento, diferentes ángulos de fotos e imágenes de baja calidad utilizadas para identificar sospechosos. Además, la estructura facial no es tan única como un identificador que la gente piensa que es, especialmente cuando se combina con otros factores, como datos de baja calidad.

Esta baja tasa de precisión parece aún más problemática cuando se combina con un fenómeno llamado sesgo de automatización, que es la tendencia a confiar en las decisiones de las máquinas, a pesar de la posible evidencia de lo contrario.

Estos problemas han llevado a algunas ciudades a prohibir su uso, incluidas San Francisco, Oakland y Boston. Sin embargo, Reuters informó en 2022 que algunas ciudades están comenzando a repensar las prohibiciones del reconocimiento facial como una herramienta para combatir el crimen en medio de «un aumento en el crimen y una mayor presión de los desarrolladores».

En cuanto a Woodruff, su experiencia la dejó hospitalizada por deshidratación y profundamente traumatizada. Su abogado, Ivan L. Land, enfatizó a The Times la necesidad de que la policía lleve a cabo más investigaciones después de un reconocimiento facial, en lugar de confiar únicamente en la tecnología. «Da miedo. Estoy preocupado», dijo. «Alguien siempre se parece a otra persona».