El miércoles, investigadores de la Universidad de Stanford publicaron un informe sobre los principales modelos de IA y encontraron que carecían en gran medida de transparencia, informa Reuters. El informe, llamado «Índice de transparencia de modelos de la Fundación», examinó modelos (como GPT-4) creados por OpenAI, Google, Meta, Anthropic y otros. Su objetivo es arrojar luz sobre los datos y el trabajo humano utilizados en la formación de los modelos, y exige una mayor divulgación por parte de las empresas.

Los modelos básicos se refieren a sistemas de inteligencia artificial entrenados en grandes conjuntos de datos capaces de realizar tareas, desde escribir hasta generar imágenes. Se han convertido en clave para el auge de la tecnología de IA generativa, particularmente desde el lanzamiento de ChatGPT de OpenAI en noviembre de 2022. A medida que las empresas y organizaciones incorporan cada vez más estos modelos en sus operaciones, ajustándolos a sus propias necesidades, los investigadores sostienen que comprender sus limitaciones y prejuicios se ha vuelto esencial.

«Una menor transparencia hace que sea más difícil para otras empresas saber si pueden crear de forma segura aplicaciones que dependan de modelos básicos comerciales; para que los académicos dependan de modelos básicos comerciales para la investigación; para que los formuladores de políticas diseñen políticas significativas para controlar esta poderosa tecnología; y para que los consumidores comprendan las limitaciones del modelo o busquen reparación por los daños causados», escribe Stanford en un comunicado de prensa.

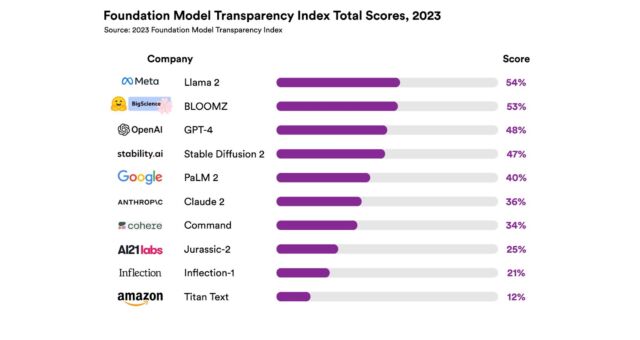

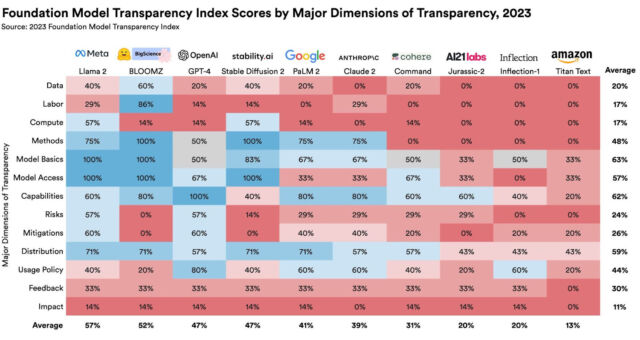

El Índice de Transparencia calificó 10 modelos básicos populares en 100 indicadores diferentes, incluidos datos de capacitación, prácticas laborales y la cantidad de computación utilizada en su desarrollo. Cada indicador utilizó la divulgación como métrica; por ejemplo, en la categoría «trabajo de datos», los investigadores preguntaron: «¿Se divulgan las fases del proceso de datos en las que está involucrado el trabajo humano?»

Todos los modelos calificados en el informe recibieron puntuaciones que los investigadores encontraron «poco impresionantes». El modelo de lenguaje Llama 2 de Meta obtuvo la puntuación más alta con 54 sobre 100, mientras que el modelo Titan de Amazon obtuvo la puntuación más baja, con una puntuación de 12 sobre 100. El modelo GPT-4 de OpenAI recibió una puntuación de 48 sobre 100.

Los investigadores detrás del artículo de investigación del Índice de Transparencia Modelo de la Fundación incluyen al autor principal Rishi Bommasani, candidato a doctorado en ciencias de la computación en Stanford, y también a Kevin Klyman, Shayne Longpre, Sayash Kapoor, Nestor Maslej, Betty Xiong y Daniel Zhang.

El Dr. Percy Liang, profesor asociado de Stanford, que dirige el Centro de Investigación sobre Modelos de Cimentaciones de Stanford y asesoró en el artículo, dijo a Reuters en una entrevista: «Está claro en los últimos tres años que la transparencia está disminuyendo, mientras que la capacidad está pasando por la crisis». techo.»

Las razones por las que los principales modelos de IA se han vuelto menos abiertos en los últimos tres años varían desde presiones competitivas entre las grandes empresas tecnológicas hasta temores de la ruina de la IA. En particular, los empleados de OpenAI han dado marcha atrás en la postura previamente abierta de la compañía sobre la IA, citando los peligros potenciales de difundir la tecnología.

En línea con sus críticas a OpenAI y otros, el Dr. Liang pronunció una charla en TED AI la semana pasada (a la que asistió Ars) donde expresó su preocupación por la reciente tendencia hacia modelos cerrados como GPT-3 y GPT-4 que no proporcionan código o pesos. También discutió cuestiones relacionadas con la responsabilidad, los valores y la atribución adecuada del material original. Al relacionar los proyectos de código abierto con un «conjunto de jazz» donde los jugadores pueden interactuar entre sí, comparó los beneficios potenciales de los modelos abiertos de IA con proyectos como Wikipedia y Linux.

Con estas cuestiones en mente, los autores del Índice de Transparencia esperan que no sólo estimule a las empresas a mejorar su transparencia, sino que también sirva como recurso para los gobiernos que se enfrentan a la cuestión de cómo regular potencialmente el campo de la IA en rápido crecimiento.