Aurich Lawson | imágenes falsas

La Dra. Sasha Luccioni es investigadora y líder climática en Hugging Face, donde estudia los impactos éticos y sociales de los modelos y conjuntos de datos de IA. También es directora de Women in Machine Learning (WiML), miembro fundador de Climate Change AI (CCAI) y presidenta del comité del Código de Ética de NeurIPS. Las opiniones en este artículo no reflejan necesariamente los puntos de vista de Ars Technica.

En los últimos meses, el campo de la inteligencia artificial ha experimentado un rápido crecimiento, con oleada tras oleada de nuevos modelos como Dall-E y GPT-4 emergiendo uno tras otro. Cada semana trae la promesa de nuevos y emocionantes modelos, productos y herramientas. Es fácil dejarse llevar por las olas de publicidad, pero estas brillantes capacidades tienen un costo real para la sociedad y el planeta.

Las desventajas incluyen el costo ambiental de la extracción de minerales raros, los costos humanos del proceso de anotación de datos que requiere mucha mano de obra y la creciente inversión financiera requerida para entrenar modelos de IA a medida que incorporan más parámetros.

Veamos las innovaciones que impulsaron las generaciones recientes de estos modelos y aumentaron los costos asociados.

Modelos más grandes

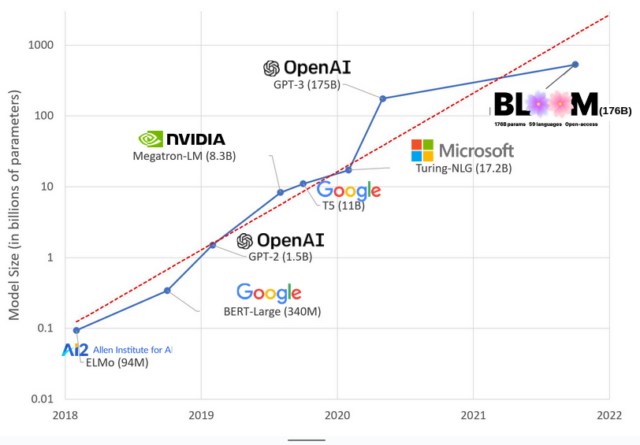

En los últimos años, los modelos de IA se han vuelto más grandes, y los investigadores ahora miden su tamaño en cientos de miles de millones de parámetros. Los «parámetros» son las conexiones internas utilizadas dentro de los modelos para aprender patrones basados en los datos de entrenamiento.

Para modelos de lenguaje extenso (LLM) como ChatGPT, pasamos de alrededor de 100 millones de parámetros en 2018 a 500 mil millones en 2023 con el modelo PaLM de Google. La teoría detrás de este crecimiento es que los modelos con más parámetros deberían tener un mejor rendimiento, incluso en tareas en las que no fueron entrenados inicialmente, aunque esta hipótesis sigue sin probarse.

Los modelos más grandes suelen tardar más en entrenarse, lo que significa que también necesitan más GPU, lo que cuesta más dinero, por lo que solo unas pocas organizaciones pueden entrenarlos. Las estimaciones ponen el costo de capacitación de GPT-3, que tiene 175 mil millones de parámetros, en $ 4.6 millones, fuera del alcance de la mayoría de las empresas y organizaciones. (Vale la pena señalar que el costo de los modelos de capacitación está disminuyendo en algunos casos, como en el caso de LLaMA, el modelo reciente capacitado por Meta).

Esto crea una brecha digital en la comunidad de IA entre aquellos que pueden capacitar a los LLM más avanzados (principalmente empresas de Big Tech e instituciones ricas en el Norte Global) y aquellos que no pueden (organizaciones sin fines de lucro, nuevas empresas y cualquier persona sin acceso a una supercomputadora o millones en créditos de nube). Construir y desplegar estos gigantes requiere una gran cantidad de recursos planetarios: metales raros para fabricar GPU, agua para enfriar enormes centros de datos, energía para mantener esos centros de datos funcionando las 24 horas del día, los 7 días de la semana a escala planetaria… sobre el potencial futuro de los modelos resultantes.

Impactos planetarios

Un estudio de la profesora de la Universidad Carnegie Melon, Emma Strubell, sobre la huella de carbono de la capacitación de LLM estimó que entrenar un modelo 2019 llamado BERT, que tiene solo 213 millones de parámetros, emitió 280 toneladas métricas de emisiones de carbono, aproximadamente equivalente a las emisiones de cinco automóviles durante su vidas Desde entonces, los modelos han crecido y el hardware se ha vuelto más eficiente, entonces, ¿dónde estamos ahora?

En un artículo académico reciente que escribí para estudiar las emisiones de carbono incurridas al entrenar BLOOM, un modelo de lenguaje de 176 mil millones de parámetros, comparamos el consumo de energía y las emisiones de carbono resultantes de varios LLM, todos los cuales surgieron en los últimos años. El objetivo de la comparación era tener una idea de la escala de emisiones de diferentes tamaños de LLM y qué los afecta.