Nvidia anunció hoy que había presentado sus primeros resultados comparativos para su superchip CPU+GPU Grace Hopper y sus aceleradores GPU L4 a la versión más reciente de MLPerf, un punto de referencia de IA estándar de la industria que está diseñado para ofrecer igualdad de condiciones para medir el rendimiento de la IA en diferentes cargas de trabajo. La ronda de resultados de referencia de hoy marca dos novedades notables para el punto de referencia MLPerf: la adición de un nuevo punto de referencia de inferencia GPT-J del modelo de lenguaje grande (LLM) y un modelo de recomendación renovado. Nvidia afirma que Grace Hopper Superchip ofrece hasta un 17 % más de rendimiento de inferencia que una de sus GPU H100 líderes del mercado en el punto de referencia GPT-J y que sus GPU L4 ofrecen hasta 6 veces el rendimiento de las CPU Xeon de Intel.

La industria se mueve a una velocidad vertiginosa a medida que evoluciona rápidamente hacia modelos de IA más nuevos e implementaciones más potentes. En la misma línea, el punto de referencia MLPerf, administrado por el organismo MLCommons, está en constante evolución para reflejar mejor la naturaleza cambiante del panorama de la IA con su nueva revisión v3.1.

GPT-J 6B, un modelo de resumen de texto utilizado en cargas de trabajo del mundo real desde 2021, ahora se utiliza dentro de la suite MLPerf como punto de referencia para medir el rendimiento de la inferencia. El LLM de 6 mil millones de parámetros del GPT-J es bastante liviano en comparación con algunos de los modelos de IA más avanzados, como el GPT-3 de 175 mil millones de parámetros, pero encaja muy bien en la función de un punto de referencia de inferencia. Este modelo resume bloques de texto y funciona tanto en modo en línea, que es sensible a la latencia, como en modo fuera de línea, que requiere un rendimiento intensivo. La suite MLPerf ahora también emplea un modelo de recomendación DLRM-DCNv2 más grande con el doble de parámetros, un conjunto de datos multi-caliente más grande y un algoritmo multicapa que representa mejor los entornos del mundo real.

Con estos antecedentes, podemos ver algunas de las afirmaciones de rendimiento de Nvidia aquí. Tenga en cuenta que la propia Nvidia envía estos puntos de referencia a MLCommons, por lo que probablemente representen los mejores escenarios altamente ajustados. A Nvidia también le gusta señalar que es la única empresa que presenta puntos de referencia para cada modelo de IA utilizado en la suite MLPerf, lo cual es una afirmación objetivamente cierta. Algunas empresas están totalmente ausentes, como AMD, o sólo presentan algunos puntos de referencia seleccionados, como Intel con Habana y Google con su TPU. Las razones de la falta de presentaciones varían según la empresa, pero sería bueno ver a más competidores ingresar al círculo de MLPerf.

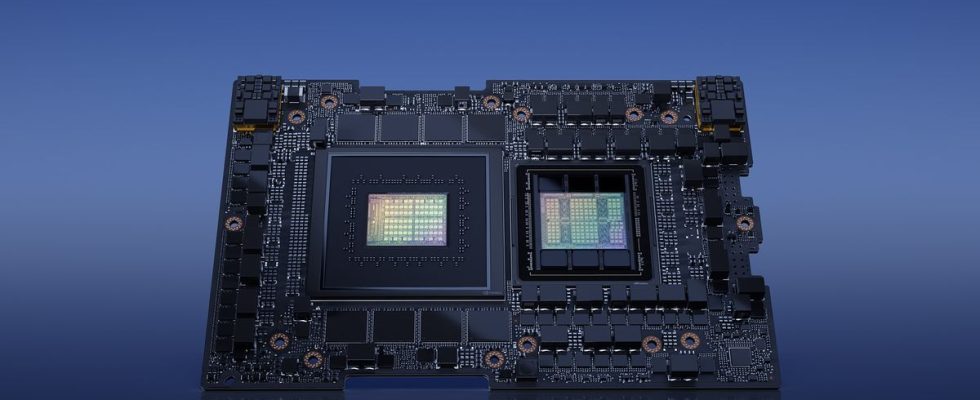

Nvidia presentó su primer resultado GH200 Grace Hopper Superchip MLPerf, destacando que la combinación CPU+GPU ofrece un 17% más de rendimiento que una sola GPU H100. A primera vista, esto es sorprendente, dado que el GH200 usa el mismo silicio que la CPU H100, pero explicaremos por qué a continuación. Naturalmente, los sistemas de Nvidia armados con ocho H100 superaron al Grace Hopper Superchip, tomando la delantera en todas las pruebas de inferencia.

Como recordatorio, el Grace Hopper Superchip combina una GPU Hopper y la CPU Grace en la misma placa, proporcionando un enlace C2C (inmersión profunda aquí) con 900 GB/s de rendimiento entre las dos unidades, proporcionando así 7 veces el ancho de banda de un PCIe típico. conexión para transferencias de datos de CPU a GPU, lo que aumenta el ancho de banda de memoria accesible del GH200, aumentado por un grupo de memoria coherente que incluye 96 GB de memoria HBM3 y 4 TB/s de ancho de banda de memoria GPU. Por el contrario, el H100 de comparación probado en el HGX tiene solo 80 GB de HBM3 (los modelos Grace Hopper de próxima generación tendrán 144 GB de HBM3e 1,7 veces más rápido en el segundo trimestre de 2024).

Nvidia también promociona una tecnología dinámica de cambio de potencia llamada Dirección Asistida Automática que equilibra dinámicamente el presupuesto de energía entre la CPU y la GPU, dirigiendo el presupuesto excedente a la unidad que esté bajo la mayor carga. Esta tecnología se utiliza en muchas combinaciones modernas de CPU y GPU de la competencia, por lo que no es nueva, pero permite que la GPU integrada en el Grace Hopper Superchip disfrute de un mayor presupuesto de entrega de energía que en el HGX debido a que la energía se transfiere de la CPU Grace, eso no es posible en un servidor estándar. El sistema completo CPU+GPU funcionó con un TDP de 1000W.

La mayor parte de la inferencia continúa ejecutándose en las CPU, lo que podría cambiar en el futuro a medida que los modelos más grandes se vuelvan más comunes; Desplazar las CPU para estas cargas de trabajo con GPU pequeñas de bajo consumo como la L4 es primordial para Nvidia porque impulsaría las ventas de gran volumen. Esta ronda de presentaciones de MLPerf también incluye los primeros resultados para las GPU L4 de Nvidia, con la tarjeta optimizada para inferencia que ofrece 6 veces el rendimiento de un solo Xeon 9480 en el punto de referencia de inferencia GPT-J, a pesar de consumir solo 72 W en una tarjeta de factor de forma delgada que No requiere conexión de alimentación auxiliar.

Nvidia también reclama hasta 120 veces el rendimiento en una carga de trabajo de decodificación, inferencia y codificación de video + IA frente a CPU al medir el rendimiento de ocho GPU L4 en comparación con dos CPU Xeon 8380 de la generación anterior, lo cual es un poco desequilibrado. Probablemente esto pretenda ser una comparación directa de la gran cantidad de potencia informática que se puede acumular en un solo chasis. Aún así, es digno de mención que los servidores de cuatro sockets están disponibles a pesar de no ser los más adecuados para el trabajo, y los chips Xeon más nuevos probablemente funcionarían un poco mejor en esta prueba. La configuración de la prueba se encuentra en la letra pequeña en la parte inferior de la diapositiva, así que asegúrese de prestar atención a esos detalles.

Finalmente, Nvidia también presentó pruebas comparativas de sus chips robóticos Jetson Orin, que muestran una ganancia del 84% en el rendimiento de inferencia, impulsada en gran medida por mejoras en el software.

Es importante recordar que, en el mundo real, cada modelo de IA se ejecuta como parte de una serie más larga de modelos que se ejecutan en un proceso de IA para realizar un trabajo o tarea específica. La ilustración anterior de Nvidia abarca esto muy bien, con ocho modelos diferentes de IA que se realizan en una consulta antes de completarla, y no es raro que este tipo de canalizaciones de IA se extiendan hasta 15 redes para satisfacer una sola consulta. Este es un contexto importante, ya que los puntos de referencia orientados al rendimiento anteriores tienden a centrarse en ejecutar un único modelo de IA con una alta utilización, a diferencia del proceso del mundo real que requiere bastante más versatilidad con múltiples modelos de IA ejecutándose en serie para completar un proceso determinado. tarea.

Nvidia también anunció la semana pasada que su software TensorRT-LLM para cargas de trabajo de IA generativa ofrece un rendimiento optimizado en cargas de trabajo de inferencia y, en general, ofrece más del doble de rendimiento cuando se utiliza en sus GPU H100, sin costo adicional. Nvidia proporcionó detalles sobre este software recientemente, sobre los cuales puede leer aquí, y señala que no tenía este software de mejora de inferencias listo para esta ronda de resultados; MLCommons requiere un plazo de entrega de 30 días para los envíos de MLPerf y TensorRT-LLM no estaba disponible en ese momento. Eso significa que la ronda inaugural de pruebas MLPerf de Nvidia debería experimentar una enorme mejora con la próxima ronda de presentaciones.