En su conferencia re:Invent de hoy, el brazo de nube AWS de Amazon anunció el lanzamiento de SageMaker HyperPod, un nuevo servicio diseñado específicamente para capacitar y ajustar modelos de lenguajes grandes (LLM). SageMaker HyperPod ya está disponible de forma generalizada.

Amazon lleva mucho tiempo apostando por SageMaker, su servicio para construir, entrenar e implementar modelos de aprendizaje automático, como columna vertebral de su estrategia de aprendizaje automático. Ahora, con la llegada de la IA generativa, tal vez no sorprenda que también se apoye en SageMaker como producto principal para facilitar a sus usuarios la capacitación y el ajuste de los LLM.

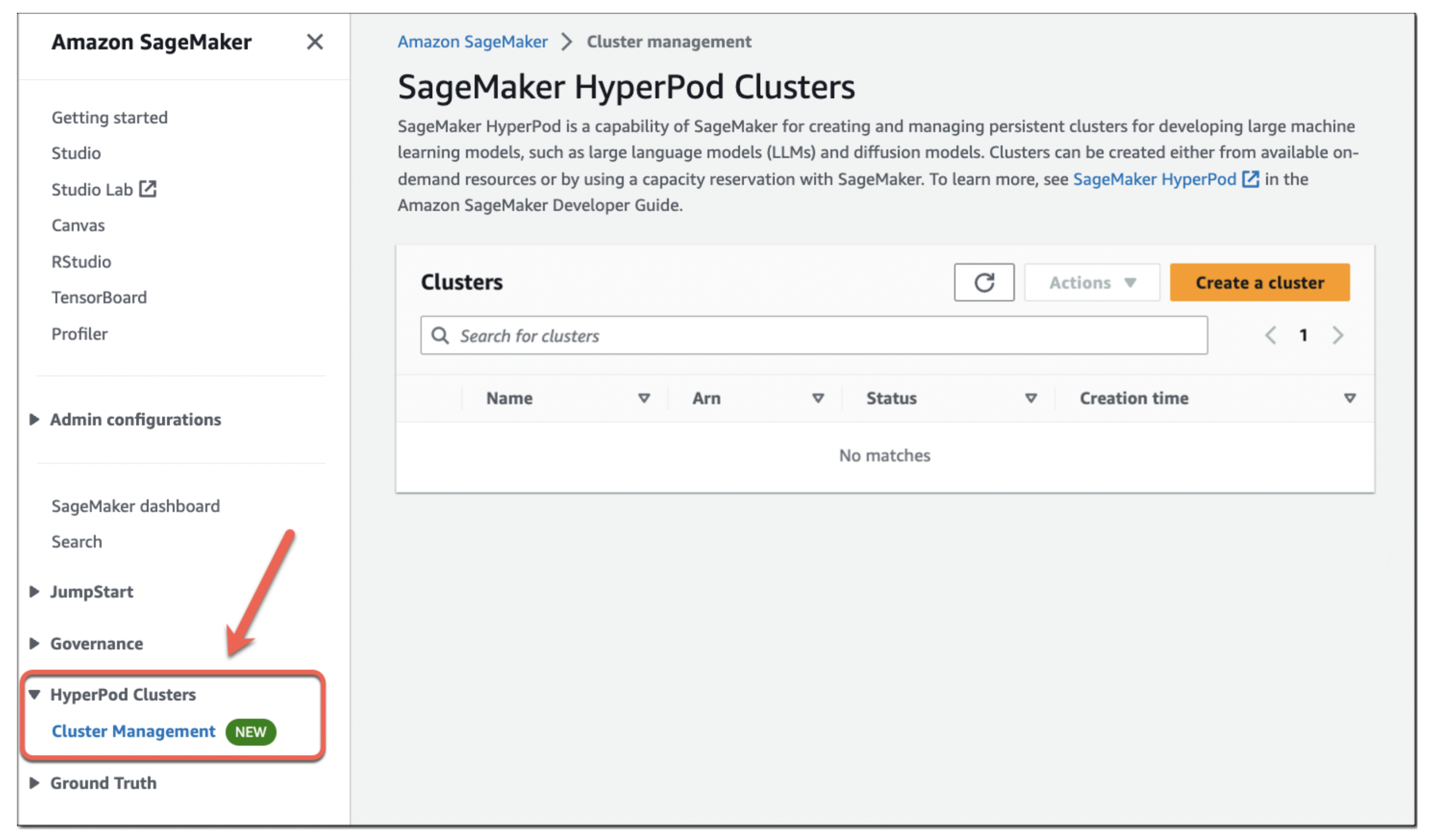

Créditos de imagen: AWS

«SageMaker HyperPod le brinda la capacidad de crear un clúster distribuido con instancias aceleradas optimizadas para la capacitación distribuida», me dijo Ankur Mehrotra, gerente general de AWS para SageMaker, en una entrevista antes del anuncio de hoy. «Le brinda las herramientas para distribuir modelos y datos de manera eficiente en su clúster, y eso acelera su proceso de capacitación».

También señaló que SageMaker HyperPod permite a los usuarios guardar puntos de control con frecuencia, lo que les permite pausar, analizar y optimizar el proceso de capacitación sin tener que empezar de nuevo. El servicio también incluye una serie de medidas de seguridad para que, cuando una GPU deje de funcionar por algún motivo, todo el proceso de capacitación no falle también.

«Para un equipo de ML, por ejemplo, eso solo está interesado en entrenar el modelo; para ellos, se convierte en una experiencia sin contacto y el clúster se convierte en una especie de clúster de autocuración en cierto sentido», explicó Mehrotra. «En general, estas capacidades pueden ayudarle a entrenar modelos básicos hasta un 40% más rápido, lo cual, si piensa en el costo y el tiempo de comercialización, es un gran diferenciador».

Créditos de imagen: AWS

Los usuarios pueden optar por entrenar con los chips Trainium (y ahora Trainium 2) personalizados de Amazon o con instancias de GPU basadas en Nvidia, incluidas aquellas que utilizan el procesador H100. La empresa promete que HyperPod puede acelerar el proceso de formación hasta en un 40%.

La empresa ya tiene cierta experiencia en este uso de SageMaker para crear LLM. El modelo Falcon 180B, por ejemplo, se entrenó en SageMaker, utilizando un grupo de miles de GPU A100. Mehrotra señaló que AWS pudo aprovechar lo que aprendió de eso y su experiencia previa con el escalamiento de SageMaker para construir HyperPod.

Créditos de imagen: AWS

El cofundador y director ejecutivo de Perplexity AI, Aravind Srinivas, me dijo que su empresa obtuvo acceso temprano al servicio durante su versión beta privada. Señaló que inicialmente su equipo se mostró escéptico acerca del uso de AWS para entrenar y ajustar sus modelos.

«No trabajamos con AWS antes», dijo. «Había un mito (es un mito, no un hecho) de que AWS no tiene una gran infraestructura para la capacitación de modelos grandes y obviamente no teníamos tiempo para hacer la debida diligencia, así que lo creímos». Sin embargo, el equipo se conectó con AWS y los ingenieros les pidieron que probaran el servicio (gratis). También señaló que le resultó fácil obtener soporte de AWS y acceso a suficientes GPU para el caso de uso de Perplexity. Obviamente ayudó que el equipo ya estuviera familiarizado con la realización de inferencias en AWS.

Srinivas también destacó que el equipo de AWS HyperPod se centró fuertemente en acelerar las interconexiones que vinculan las tarjetas gráficas de Nvidia. «Fueron y optimizaron las primitivas (las diversas primitivas de Nvidia) que le permiten comunicar estos gradientes y parámetros a través de diferentes nodos», explicó.