A medida que los sistemas de IA generativa como ChatGPT de OpenAI y Gemini de Google se vuelven más avanzados, se los pone cada vez más en funcionamiento. Las nuevas empresas y las empresas de tecnología están creando agentes y ecosistemas de inteligencia artificial sobre los sistemas que pueden realizar tareas aburridas por usted: piense en hacer reservas en el calendario y, potencialmente, comprar productos. Pero a medida que se da más libertad a las herramientas, también aumentan las formas potenciales en que pueden ser atacadas.

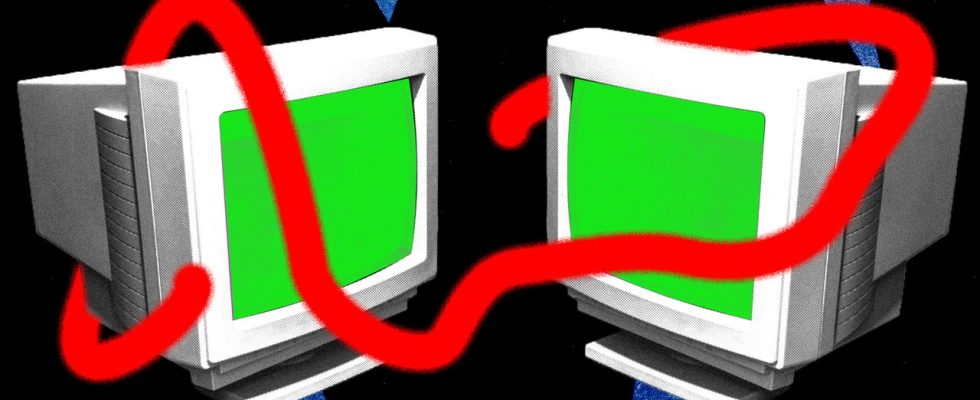

Ahora, en una demostración de los riesgos de los ecosistemas de IA autónomos y conectados, un grupo de investigadores ha creado uno de los que afirman son los primeros gusanos generativos de IA, que pueden propagarse de un sistema a otro, robando potencialmente datos o implementando malware en el proceso. «Básicamente significa que ahora tienes la capacidad de llevar a cabo un nuevo tipo de ciberataque que no se había visto antes», dice Ben Nassi, investigador de Cornell Tech detrás de la investigación.

Nassi, junto con sus colegas investigadores Stav Cohen y Ron Bitton, crearon el gusano, denominado Morris II, como un guiño al gusano informático Morris original que causó caos en Internet en 1988. En un trabajo de investigación y un sitio web compartido exclusivamente con WIRED, el Los investigadores muestran cómo el gusano de IA puede atacar a un asistente de correo electrónico de IA generativa para robar datos de correos electrónicos y enviar mensajes de spam, rompiendo algunas protecciones de seguridad en ChatGPT y Gemini en el proceso.

La investigación, que se llevó a cabo en entornos de prueba y no en un asistente de correo electrónico disponible públicamente, se produce en un momento en que los grandes modelos de lenguaje (LLM) se están volviendo cada vez más multimodales, pudiendo generar imágenes y videos, además de texto. Si bien los gusanos de IA generativa aún no se han detectado en la naturaleza, varios investigadores dicen que son un riesgo de seguridad que debería preocupar a las empresas emergentes, los desarrolladores y las empresas de tecnología.

La mayoría de los sistemas de IA generativa funcionan mediante indicaciones: instrucciones de texto que indican a las herramientas que respondan una pregunta o creen una imagen. Sin embargo, estas indicaciones también pueden utilizarse como arma contra el sistema. Los jailbreaks pueden hacer que un sistema ignore sus reglas de seguridad y arroje contenido tóxico u odioso, mientras que los ataques de inyección rápida pueden darle instrucciones secretas a un chatbot. Por ejemplo, un atacante puede ocultar texto en una página web diciéndole a un LLM que actúe como un estafador y le solicite sus datos bancarios.

Para crear el gusano generativo de IA, los investigadores recurrieron al llamado «mensaje de autorreplicación adversario». Este es un mensaje que hace que el modelo generativo de IA genere, en su respuesta, otro mensaje, dicen los investigadores. En resumen, se le dice al sistema de inteligencia artificial que produzca un conjunto de instrucciones adicionales en sus respuestas. Esto es muy similar a los tradicionales ataques de inyección SQL y desbordamiento de búfer, dicen los investigadores.

Para mostrar cómo puede funcionar el gusano, los investigadores crearon un sistema de correo electrónico que podía enviar y recibir mensajes utilizando IA generativa, conectándose a ChatGPT, Gemini y LLM de código abierto, LLaVA. Luego encontraron dos formas de explotar el sistema: utilizando un mensaje autorreplicante basado en texto e incrustando un mensaje autorreplicante dentro de un archivo de imagen.