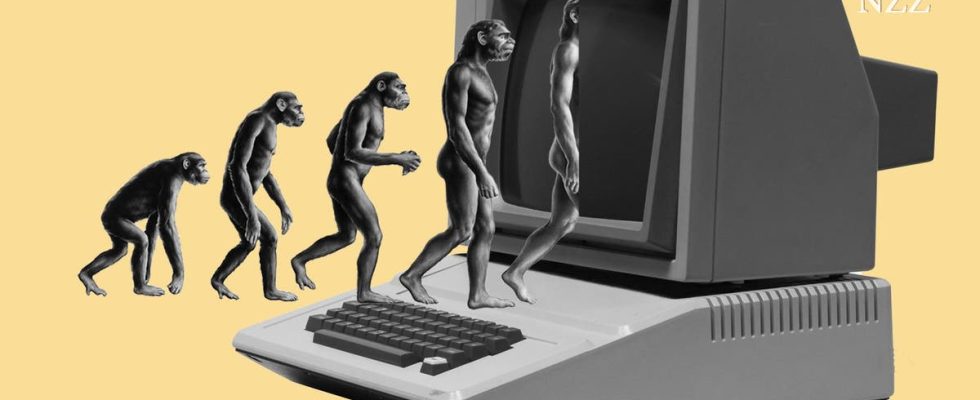

Sam Altman, jefe del proveedor de chat GPT Open AI, y el historiador Yuval Harari advierten que los sistemas informáticos están acabando con la humanidad. Estos escenarios de ciencia ficción distraen la atención de los problemas reales de la IA.

Es posible que haya visto la cifra antes: el 10 por ciento es la probabilidad de que los futuros sistemas de inteligencia artificial (IA) eliminen a la humanidad. Que piensa según un muy citado encuestaedad por el Instituto de Investigación de Inteligencia de Máquinas la mitad de los desarrolladores de la IA actual.

El historiador Harari y dos coautores usan el número en un ensayo para el New York Times para una pregunta capciosa: «Imagina que te subes a un avión y la mitad de los ingenieros que lo construyeron te dicen que se estrellará con un diez por ciento de probabilidad. ¿Subirás a bordo?».

Luego discuten los peligros de la inteligencia artificial, describiendo nuestro tiempo como una especie de guerra: por un lado «la humanidad», por el otro «la IA». Tendríamos que aprender a “dominar la IA antes de que nos domine a nosotros”, piden los autores al final.

Eso suena razonable. Y, sin embargo, es un ejemplo de una gran confusión en el debate sobre inteligencia artificial. Una confusión que en realidad podría tener consecuencias peligrosas.

Dos ingredientes para el mito de Frankenstein

Comienza con el desafortunado nombre. «Inteligencia artificial», que evoca el mito de Frankenstein. Nuestra semejanza en una máquina. También se podría decir máquinas de aprendizaje o modelos estadísticos para la producción del lenguaje. Pero eso no suena tan emocionante.

Por lo tanto, las empresas de tecnología tienen interés en alimentar aún más el mito. Y lo hacen. Si escribe una pregunta en Chat-GPT, debe esperar un poco la respuesta porque los servidores están al límite. Mientras tanto, no aparece un reloj de arena, sino un cursor parpadeante. La respuesta aparece palabra por palabra. Como si el programa estuviera pensando.

Los asistentes de IA están humanizados deliberadamente. «¿Cómo puede I ¿Te ayudó?”, pregunta Alexa, Bing y compañía. No es de extrañar que difícilmente puedas escapar de la ilusión de que estás tratando con una contraparte pensante.

El segundo ingrediente del mito de Frankenstein es que nadie sabe lo que está haciendo la IA. Eso está mal.

Es cierto que no es posible prever exactamente qué resultados producirá tal modelo en casos individuales. Por lo tanto, a menudo se dice que la IA, que aprende de grandes cantidades de datos, es una caja negra.

Pero eso no significa que los expertos no entiendan fundamentalmente cómo funciona esta tecnología. Está bastante claro qué habilidades se pueden aprender de qué datos. Sin embargo, una advertencia reciente carta abierta por Elon Musk, Harari y otras celebridades tecnológicas que incluso los desarrolladores no entendían la «mente digital» que estaban creando.

La mezcla de diseño humanizador y el murmullo de que algo misterioso está pasando aquí obviamente confunde, incluso a las personas que deberían saberlo mejor. El científico jefe de Open AI reclamos, AI podría ser «un poco consciente». Un ingeniero de Google requerido un defensor del chatbot interno porque es consciente. un profesor de stanford escribe en twitterChat-GPT quiere salir de la computadora.

Eso es absurdo. Chat-GPT es un programa que predice palabras, las entrena para simular conversaciones. Eso es exactamente lo que hace muy bien. Concluir de esto que tiene voluntad o está a punto de desarrollarla es estar cegado por el diseño de estos programas.

El efecto creep es un truco retórico.

Ahora se podría decir: deberían hacerlo. Es normal que las empresas exageren sus propios productos. Es normal que la gente se enamore de la idea de haber creado algo muy especial y sobreestime su propio trabajo. Lo sabes por los padres.

Y, de hecho, la IA conlleva peligros. Es una tecnología compleja y poderosa que debe revisarse cuidadosamente para ver qué daño colateral es posible en el área de operación. Al advertir al respecto, confíe un poco en el efecto de miedo, eso no puede doler, ¿verdad?

Lamentablemente hace daño. El creep es un truco retórico. A Sam Altman, el jefe de Open AI, le gusta hablar sobre un futuro con una inteligencia abrumadora similar a la humana. El efecto aterrador suele ir seguido de una promesa: con nosotros, en Open AI, el monstruo está en buenas manos. Pensamos en los peligros. Somos responsables.

De lo que Altman no habla: aunque hizo que la IA de voz estuviera disponible para todos con Open AI, decidió proceder de una manera completamente opaca. Entonces, ¿cómo lidia Open AI con el poder que ya reside en la empresa? En lugar de hablar de los problemas de una IA abrumadora inexistente, deberíamos considerar cómo abordar los problemas muy específicos de las tecnologías de IA actuales.

Open AI sabe para qué se utiliza actualmente su IA

Si bien Altman advierte que la IA es una caja negra que nadie entiende, debemos instar a Open AI a que haga pública cuál es exactamente la tecnología detrás de su modelo para que pueda ser estudiada por la ciencia. Esto es exactamente lo que Open AI niega en este momento.

Mientras Harari advierte que una máquina quiere manipularnos, una IA que puede «hackear el sistema operativo de la civilización con el lenguaje», debemos hablar del hecho de que son las personas las que difunden falsedades: políticos, estafadores, gobiernos, agitadores. La tecnología es solo una herramienta en sus manos. La radio no tuvo la culpa de la propaganda nazi, Goebbels la utilizó para ello.

Si observa cómo las personas pueden hacer un mal uso de una tecnología, también se le ocurrirán ideas para posibles regulaciones. Por ejemplo, Open AI conoce las consultas de sus usuarios. ¿Por qué no exigir a la empresa que publique un informe sobre qué textos están creando los clientes? ¿Se trata de recetas de cocina, trabajos académicos o campañas de desinformación?

Se podría dictar a los proveedores de chatbots que deben hacer que la base de datos de todos los textos creados sea accesible para consultas de plagio: un motor de búsqueda en el que puede ingresar secciones de texto y averiguar si fueron creados por una IA.

Tal regla probablemente también tendría sus debilidades, pero eso es exactamente lo que deberíamos estar discutiendo, no si la IA leal es suficiente.

Los desarrolladores de tecnología pretenden ser los sumos sacerdotes del futuro

Por supuesto, Open AI y otras compañías tecnológicas no están interesadas en una discusión sobre reglas específicas. Prefieren hacerse pasar por sumos sacerdotes del futuro, entusiasmados con la IA sobrehumana que están creando. El público en general puede usar el software, pero darle una idea de cómo funciona es peligroso. Esta actitud es arrogante.

Y Lutero ya lo tenía claro: los que mantienen en secreto las Sagradas Escrituras se preocupan por el poder y el control.

El ejemplo citado por el ensayo de Harari es involuntariamente revelador. Hubo una primera batalla contra la IA en la que la humanidad perdió: las redes sociales. Los algoritmos de IA que pueblan nuestros feeds de redes sociales habrían polarizado a la sociedad y la habrían llevado al abismo. Ahora queda pendiente el segundo contacto con la IA: «No podemos permitirnos volver a perder».

Una vez más, AI no tiene agencia. Facebook, Twitter, Tiktok y Youtube utilizan algoritmos para mantener a la audiencia en la plataforma. No es la IA la que divide a las sociedades, sino los ciudadanos, los políticos, las personas influyentes, con la ayuda de las empresas que se benefician de toda la indignación.

No son los algoritmos los que polarizan, sino quienes los usan

Cuando los empleados se hacen públicos, como el ex empleado de Facebook francis haugenel panorama siempre es el mismo: estas empresas no tienen ingenieros abrumados que no entienden sus algoritmos, al contrario. El grupo meta está observando muy de cerca.cuándo comentan las personas, cuándo les gusta, cuándo hacen clic en un emoji de ira y qué campañas de odio se están ejecutando actualmente.

Aquellos que culpan a los «algoritmos» están siendo engañados por las empresas tecnológicas, que quieren distraer la atención del hecho de que priorizan repetidamente los intereses comerciales.

Harari y sus coautores tienen razón, no podemos darnos el lujo de perder otra batalla. Sería útil no mirar al adversario imaginario «IA», sino a las formas en que las personas hacen mal uso de ella, y los métodos con los que estos, fabricantes y usuarios, pueden rendir cuentas.