En junio de 2021, GitHub anunció Copilot, una especie de autocompletado para código de computadora impulsado por la tecnología de generación de texto de OpenAI. Proporcionó una visión temprana del impresionante potencial de la inteligencia artificial generativa para automatizar trabajos valiosos. Dos años después, Copilot es uno de los ejemplos más maduros de cómo la tecnología puede asumir tareas que antes tenían que hacerse a mano.

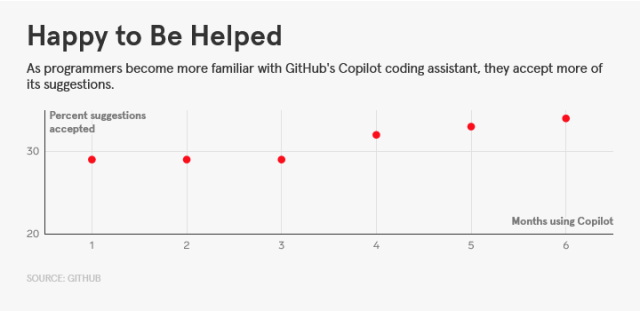

Esta semana, GitHub publicó un informe, basado en datos de casi un millón de programadores que pagan para usar Copilot, que muestra cuán transformacional se ha vuelto la codificación generativa de IA. En promedio, aceptaron las sugerencias del asistente de IA alrededor del 30 por ciento de las veces, lo que sugiere que el sistema es notablemente bueno para predecir código útil.

GitHub

El sorprendente gráfico anterior muestra cómo los usuarios tienden a aceptar más sugerencias de Copilot a medida que pasan más meses usando la herramienta. El informe también concluye que los codificadores mejorados con IA ven aumentar su productividad con el tiempo, según el hecho de que un estudio anterior de Copilot informó un vínculo entre la cantidad de sugerencias aceptadas y la productividad de un programador. El nuevo informe de GitHub dice que las mayores ganancias de productividad se observaron entre los desarrolladores menos experimentados.

A primera vista, es una imagen impresionante de una tecnología novedosa que demuestra rápidamente su valor. Cualquier tecnología que mejore la productividad y aumente las habilidades de los trabajadores menos calificados podría ser una bendición tanto para las personas como para la economía en general. GitHub continúa ofreciendo algunas especulaciones al dorso del sobre, estimando que la codificación de IA podría aumentar el PIB mundial en $ 1,5 billones para 2030.

Pero el gráfico de GitHub que muestra a los programadores vinculándose con Copilot me recordó otro estudio del que escuché recientemente mientras conversaba con Talia Ringer, profesora de la Universidad de Illinois en Urbana-Champaign, sobre la relación de los programadores con herramientas como Copilot.

A finales del año pasado, un equipo de la Universidad de Stanford publicó un trabajo de investigación que analizaba cómo el uso de un asistente de IA generador de código que construyeron afecta la calidad del código que produce la gente. Los investigadores descubrieron que los programadores que recibían sugerencias de IA tendían a incluir más errores en su código final; sin embargo, aquellos con acceso a la herramienta tendían a creer que su código era más seguro. «Probablemente hay beneficios y riesgos involucrados» con la codificación en conjunto con la IA, dice Ringer. «Más código no es mejor código».

Cuando consideras la naturaleza de la programación, ese hallazgo no es sorprendente. Como escribió Clive Thompson en una función de WIRED de 2022, Copilot puede parecer milagroso, pero sus sugerencias se basan en patrones en el trabajo de otros programadores, que pueden ser defectuosos. Estas conjeturas pueden crear errores que son endiabladamente difíciles de detectar, especialmente cuando te fascina lo buena que es la herramienta.

Sabemos por otras áreas de la ingeniería que los humanos pueden caer en una dependencia excesiva de la automatización. La Autoridad Federal de Aviación de EE. UU. ha advertido repetidamente que algunos pilotos se están volviendo tan dependientes del piloto automático que sus habilidades de vuelo se están atrofiando. Un fenómeno similar es familiar en los automóviles autónomos, donde se requiere una vigilancia extraordinaria para protegerse contra fallas raras pero potencialmente mortales.

Esta paradoja puede ser fundamental para la historia en desarrollo de la IA generativa y hacia dónde nos llevará. La tecnología ya parece estar impulsando una espiral descendente en la calidad del contenido web, ya que los sitios de buena reputación se inundan con escoria generada por IA, proliferan los sitios web de spam y los chatbots intentan estimular artificialmente la participación.

Nada de esto quiere decir que la IA generativa sea un fiasco. Hay un creciente cuerpo de investigación que muestra cómo las herramientas de IA generativa pueden aumentar el rendimiento y la felicidad de algunos trabajadores, como los que manejan las llamadas de atención al cliente. Algunos otros estudios tampoco han encontrado un aumento en los errores de seguridad cuando los desarrolladores usan un asistente de IA. Y para su crédito, GitHub está investigando la cuestión de cómo codificar de manera segura con la asistencia de IA. En febrero, anunció una nueva característica de Copilot que intenta detectar las vulnerabilidades generadas por el modelo subyacente.

Pero los efectos complejos de la generación de código brindan una advertencia para las empresas que trabajan para implementar algoritmos generativos para otros casos de uso.

Los reguladores y legisladores que muestren más preocupación por la IA también deberían tomar nota. Con tanto entusiasmo por el potencial de la tecnología, y la especulación salvaje sobre cómo podría conquistar el mundo, podría pasarse por alto evidencia más sutil y aún más sustantiva de cómo están funcionando las implementaciones de IA. Casi todo en nuestro futuro estará respaldado por software, y si no tenemos cuidado, también podría estar plagado de errores generados por IA.

Esta historia apareció originalmente en Wired.com.