A medida que Estados Unidos avanza hacia la criminalización de los deepfakes (audio, imágenes y videos engañosos generados por IA que son cada vez más difíciles de distinguir del contenido auténtico en línea), las empresas de tecnología se han apresurado a implementar herramientas para ayudar a todos a detectar mejor el contenido de IA.

Pero los esfuerzos hasta ahora han sido imperfectos, y los expertos temen que las plataformas de redes sociales no estén preparadas para manejar el consiguiente caos de la IA durante las principales elecciones mundiales de 2024, a pesar de que los gigantes tecnológicos se comprometieron a crear herramientas específicas para combatir la desinformación electoral alimentada por la IA. La mejor detección de IA sigue siendo la de los humanos observadores, quienes, al prestar mucha atención a los deepfakes, pueden detectar fallas como personas generadas por IA con dedos adicionales o voces de IA que hablan sin detenerse a respirar.

Entre las herramientas más llamativas anunciadas esta semana, OpenAI compartió hoy detalles sobre un nuevo clasificador de detección de imágenes de IA que, según afirma, puede detectar alrededor del 98 por ciento de las salidas de IA de su propio sofisticado generador de imágenes, DALL-E 3. También «actualmente marca aproximadamente de 5 a 10 por ciento de las imágenes generadas por otros modelos de IA», dice el blog de OpenAI.

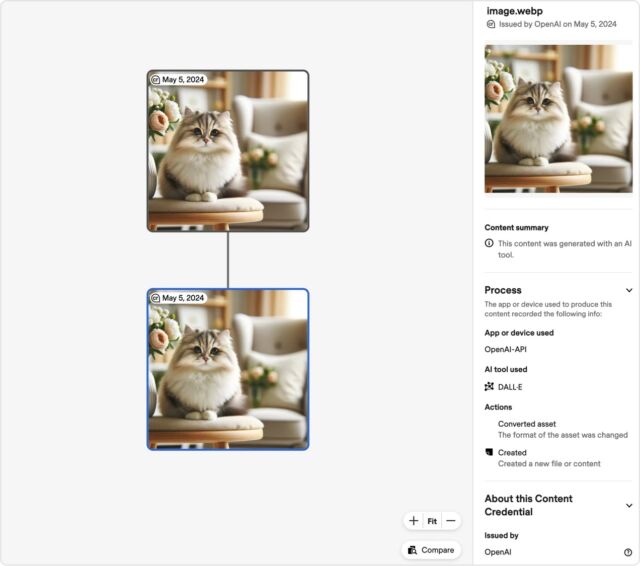

Según OpenAI, el clasificador proporciona una respuesta binaria «verdadero/falso» «que indica la probabilidad de que la imagen sea generada por IA por DALL·E 3». Una captura de pantalla de la herramienta muestra cómo también se puede utilizar para mostrar un resumen de contenido sencillo que confirme que «este contenido se generó con una herramienta de IA» e incluye campos que idealmente marcan la «aplicación o dispositivo» y la herramienta de IA utilizada.

Para desarrollar la herramienta, OpenAI pasó meses agregando metadatos a prueba de manipulaciones a «todas las imágenes creadas y editadas por DALL·E 3» que «pueden usarse para demostrar que el contenido proviene» de «una fuente particular». El detector lee estos metadatos para marcar con precisión las imágenes de DALL-E 3 como falsas.

Esos metadatos siguen «un estándar ampliamente utilizado para la certificación de contenido digital» establecido por la Coalición para la Procedencia y Autenticidad del Contenido (C2PA), a menudo comparado con una etiqueta nutricional. Y reforzar ese estándar se ha convertido en «un aspecto importante» del enfoque de OpenAI para la detección de IA más allá de DALL-E 3, dijo OpenAI. Cuando OpenAI lance ampliamente su generador de video, Sora, los metadatos C2PA también se integrarán en esa herramienta, dijo OpenAI.

Por supuesto, esta solución no es integral porque los metadatos siempre se pueden eliminar, y «las personas aún pueden crear contenido engañoso sin esta información (o pueden eliminarla)», dijo OpenAI, «pero no pueden falsificar ni alterar fácilmente esta información, lo que hace que Es un recurso importante para generar confianza».

Debido a que OpenAI apuesta por C2PA, el líder de IA anunció hoy que se uniría al comité directivo de C2PA para ayudar a impulsar una adopción más amplia del estándar. OpenAI también lanzará un fondo de 2 millones de dólares con Microsoft para apoyar una «educación y comprensión de la IA» más amplia, aparentemente en parte con la esperanza de que cuanta más gente comprenda la importancia de la detección de la IA, menos probabilidades habrá de que eliminen estos metadatos.

«A medida que aumenta la adopción del estándar, esta información puede acompañar al contenido a lo largo de su ciclo de vida de intercambio, modificación y reutilización», dijo OpenAI. «Con el tiempo, creemos que este tipo de metadatos será algo que la gente esperará, llenando un vacío crucial en las prácticas de autenticidad del contenido digital».

La incorporación de OpenAI al comité «marca un hito importante para el C2PA y ayudará a avanzar en la misión de la coalición de aumentar la transparencia en torno a los medios digitales a medida que el contenido generado por IA se vuelve más frecuente», dijo C2PA en un blog.