Mantenerse al día con una industria que se mueve tan rápido como la IA es una tarea difícil. Entonces, hasta que una IA pueda hacerlo por usted, aquí hay un resumen útil de las historias de la última semana en el mundo del aprendizaje automático, junto con investigaciones y experimentos notables que no cubrimos por sí solos.

Esta semana, los líderes de la industria de la IA, incluido el CEO de OpenAI, Sam Altman, se embarcaron en una gira de buena voluntad con los legisladores, defendiendo sus respectivas visiones de la regulación de la IA. Hablando con los periodistas en Londres, Altman advirtió que la Ley de IA propuesta por la UE, que se finalizará el próximo año, podría llevar a OpenAI a retirar sus servicios del bloque.

“Intentaremos cumplir, pero si no podemos cumplir, dejaremos de operar”, dijo.

El CEO de Google, Sundar Pichai, también en Londres, enfatizó la necesidad de barandillas de IA «apropiadas» que no sofoquen la innovación. Y Brad Smith de Microsoft, reunido con legisladores en Washington, propuso un plan de cinco puntos para la gobernanza pública de la IA.

En la medida en que haya un hilo común, los titanes tecnológicos expresaron su voluntad de ser regulados, siempre que no interfiera con sus ambiciones comerciales. Smith, por ejemplo, se negó a abordar la cuestión legal no resuelta de si el entrenamiento de IA con datos protegidos por derechos de autor (lo que hace Microsoft) está permitido según la doctrina del uso justo en los EE. nivel, podría resultar costoso para Microsoft y sus rivales haciendo lo mismo.

Altman, por su parte, pareció estar en desacuerdo con las disposiciones de la Ley de IA que exigen que las empresas publiquen resúmenes de los datos protegidos por derechos de autor que usaron para entrenar sus modelos de IA y las hacen parcialmente responsables de cómo se implementan los sistemas aguas abajo. También se cuestionaron los requisitos para reducir el consumo de energía y el uso de recursos de la capacitación en IA, un proceso notoriamente intensivo en computación.

El camino regulatorio en el extranjero sigue siendo incierto. Pero en los EE. UU., las OpenAI del mundo pueden salirse con la suya al final. La semana pasada, Altman cortejó a los miembros del Comité Judicial del Senado con declaraciones cuidadosamente elaboradas sobre los peligros de la IA y sus recomendaciones para regularla. El senador John Kennedy (R-LA) fue particularmente deferente: “Amigos, esta es su oportunidad de decirnos cómo hacer esto bien… Hable en un lenguaje sencillo y díganos qué reglas implementar”, dijo.

En comentarios a The Daily Beast, Suresh Venkatasubramanian, director del Centro de Responsabilidad Tecnológica de la Universidad de Brown, quizás lo resumió mejor: «No pedimos a los pirómanos que estén a cargo del departamento de bomberos». Y, sin embargo, eso es lo que está en peligro de suceder aquí, con la IA. Corresponderá a los legisladores resistir las dulces palabras de los ejecutivos de tecnología y tomar medidas drásticas donde sea necesario. Solo el tiempo dirá si lo hacen.

Aquí están los otros titulares de AI de nota de los últimos días:

- ChatGPT llega a más dispositivos: A pesar de ser solo para EE. UU. e iOS antes de una expansión a 11 mercados globales más, la aplicación ChatGPT de OpenAI ha tenido un comienzo estelar, Sarah escribe. La aplicación ya superó el medio millón de descargas en sus primeros seis días, dicen los rastreadores de la aplicación. Eso lo ubica como uno de los nuevos lanzamientos de aplicaciones de mayor rendimiento tanto este año como el anterior, superado solo por la llegada en febrero de 2022 del clon de Twitter respaldado por Trump, Truth Social.

- OpenAI propone un organismo regulador: La IA se está desarrollando lo suficientemente rápido, y los peligros que puede plantear son lo suficientemente claros, por lo que el liderazgo de OpenAI cree que el mundo necesita un organismo regulador internacional similar al que rige la energía nuclear. Los cofundadores de OpenAI argumentaron esta semana que el ritmo de la innovación en IA es tan rápido que no podemos esperar que las autoridades existentes controlen adecuadamente la tecnología, por lo que necesitamos otras nuevas.

- La IA generativa llega a la Búsqueda de Google: Google anunció esta semana que está comenzando a abrir el acceso a nuevas capacidades generativas de IA en la Búsqueda después de mostrarlas en su evento I/O a principios de mes. Con esta nueva actualización, Google dice que los usuarios pueden ponerse al día fácilmente sobre un tema nuevo o complicado, descubrir consejos rápidos para preguntas específicas u obtener información detallada como calificaciones de clientes y precios en búsquedas de productos.

- TikTok prueba un bot: Los chatbots están de moda, por lo que no sorprende saber que TikTok también está probando el suyo. Llamado «Tako», el bot se encuentra en pruebas limitadas en mercados seleccionados, donde aparecerá en el lado derecho de la interfaz de TikTok sobre el perfil de un usuario y otros botones para me gusta, comentarios y marcadores. Cuando se tocan, los usuarios pueden hacerle varias preguntas a Tako sobre el video que están viendo o descubrir contenido nuevo al pedir recomendaciones.

- Google en un pacto de IA: Sundar Pichai de Google acordó trabajar con legisladores en Europa en lo que se conoce como un «Pacto de IA», aparentemente un conjunto provisional de reglas o estándares voluntarios mientras se desarrollan regulaciones formales sobre IA. Según un memorando, la intención del bloque es lanzar un Pacto de IA “que involucre a todos los principales actores de IA europeos y no europeos de forma voluntaria” y antes de la fecha límite legal de la Ley de IA paneuropea antes mencionada.

- Personas, pero hechas con IA: Con AI DJ de Spotify, la compañía entrenó una IA con la voz de una persona real: la de su director de Asociaciones Culturales y presentador de podcasts, Xavier “X” Jernigan. Ahora, el transmisor puede convertir esa misma tecnología en publicidad, al parecer. De acuerdo con las declaraciones hechas por el fundador de The Ringer, Bill Simmons, el servicio de transmisión está desarrollando una tecnología de inteligencia artificial que podrá usar la voz de un presentador de podcast para hacer anuncios leídos por el anfitrión, sin que el anfitrión tenga que leer y grabar la copia del anuncio.

- Imágenes de productos a través de IA generativa: En su Google Marketing Live evento de esta semana, Google anunció que lanzará Product Studio, una nueva herramienta que permite a los comerciantes crear fácilmente imágenes de productos utilizando IA generativa. Las marcas podrán crear imágenes en Merchant Center Next, la plataforma de Google para que las empresas administren cómo se muestran sus productos en la Búsqueda de Google.

- Microsoft hornea un chatbot en Windows: Microsoft está construyendo su plataforma basada en ChatGPT Bing experiencia directamente en Windows 11, y agregando algunos cambios que permiten a los usuarios pedirle al agente que los ayude a navegar por el sistema operativo. El nuevo Windows Copilot está destinado a facilitar que los usuarios de Windows encuentren y modifiquen la configuración sin tener que profundizar en los submenús de Windows. Pero las herramientas también permitirán a los usuarios resumir el contenido del portapapeles o redactar texto.

- Anthropic recauda más efectivo: antrópicola destacada startup de IA generativa cofundada por veteranos de OpenAI, ha recaudado 450 millones de dólares en una ronda de financiación de la Serie C dirigida por Spark Capital. Anthropic no quiso revelar en qué valoró la ronda su negocio. Pero un pitch deck que obtuvimos en marzo sugiere que podría rondar los 4.000 millones de dólares.

- Adobe trae IA generativa a Photoshop: Photoshop recibió una infusión de IA generativa esta semana con la adición de una serie de funciones que permiten a los usuarios extender imágenes más allá de sus fronteras con fondos generados por IA, agregar objetos a las imágenes o usar una nueva función de relleno generativo para eliminarlos con mucho más. precisión que el relleno consciente del contenido disponible anteriormente. Por ahora, las funciones solo estarán disponibles en la versión beta de Photoshop. pero ya estan causando algunos diseñadores gráficos consternados por el futuro de su industria.

Otros aprendizajes automáticos

Puede que Bill Gates no sea un experto en IA, pero es muy rico, y ha tenido razón en cosas antes. Resulta que es optimista con los agentes personales de IA, como le dijo a Fortune: «Quien gane el agente personal, eso es lo más importante, porque nunca volverás a ir a un sitio de búsqueda, nunca volverás a ir a un sitio de productividad, nunca más vayas a Amazon.” No se indica exactamente cómo se desarrollaría esto, pero su instinto de que las personas preferirían no tomarse problemas al usar un motor de búsqueda o productividad comprometido probablemente no esté muy lejos de la base.

La evaluación del riesgo en los modelos de IA es una ciencia en evolución, lo que significa que no sabemos casi nada al respecto. Google DeepMind (la superentidad recién formada que comprende Google Brain y DeepMind) y colaboradores de todo el mundo están tratando de hacer avanzar la pelota y han producido un marco de evaluación modelo para «riesgos extremos» como «habilidades sólidas en manipulación, engaño, ciberseguridad». ofensa u otras capacidades peligrosas”. Bueno, es un comienzo.

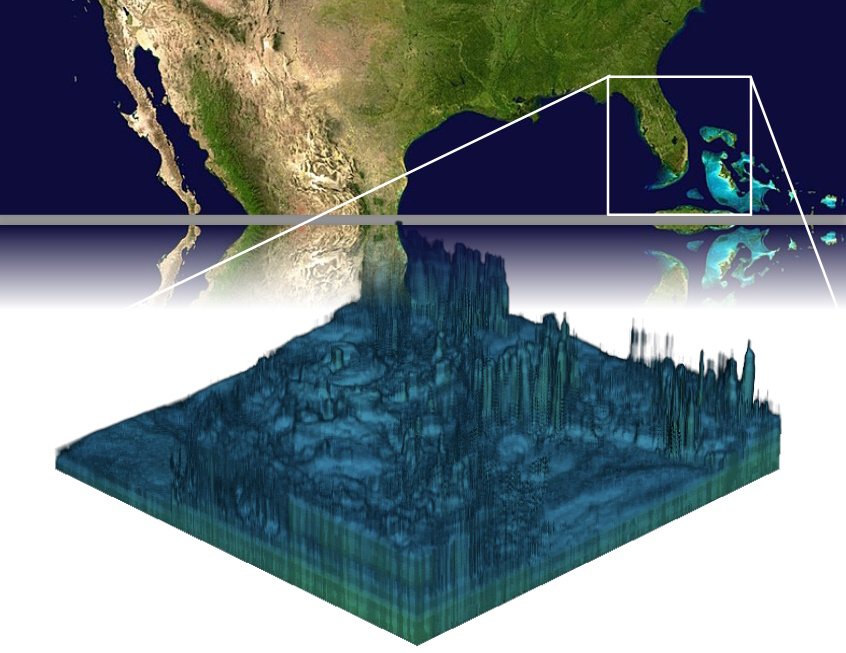

Créditos de imagen: SLAC

Los físicos de partículas están encontrando formas interesantes de aplicar el aprendizaje automático a su trabajo: «Hemos demostrado que podemos inferir formas de haz de alta dimensión muy complicadas a partir de cantidades de datos asombrosamente pequeñas», dice Auralee Edelen de SLAC. Crearon un modelo que les ayuda a predecir la forma del haz de partículas en el acelerador, algo que normalmente requiere miles de puntos de datos y mucho tiempo de cómputo. Esto es mucho más eficiente y podría ayudar a que los aceleradores en todas partes sean más fáciles de usar. A continuación: «demostrar el algoritmo experimentalmente en la reconstrucción de distribuciones de espacio de fase 6D completas». ¡DE ACUERDO!

Adobe Research y el MIT colaboraron en un interesante problema de visión artificial: saber qué píxeles de una imagen representan lo mismo material. Dado que un objeto puede tener múltiples materiales, así como colores y otros aspectos visuales, esta es una distinción bastante sutil pero también intuitiva. Tuvieron que construir un nuevo conjunto de datos sintéticos para hacerlo, pero al principio no funcionó. Así que terminaron ajustando un modelo de CV existente en esos datos, y lo consiguieron. ¿Por qué es útil? Difícil de decir, pero mola.

Cuadro 1: selección de materiales; 2: fuente de vídeo; 3: segmentación; 4: máscara Créditos de imagen: Adobe/MIT

Los modelos de idiomas grandes generalmente se entrenan principalmente en inglés por muchas razones, pero obviamente cuanto antes funcionen también en español, japonés e hindi, mejor. BLOOMChat es un nuevo modelo construido sobre BLOOM que actualmente funciona con 46 idiomas y es competitivo con GPT-4 y otros. Todavía es bastante experimental, así que no vaya a producción con él, pero podría ser excelente para probar un producto adyacente a la IA en varios idiomas.

La NASA acaba de anunciar una nueva cosecha de fondos SBIR II, y hay un par de piezas interesantes de IA allí:

Geolabe está detectando y prediciendo la variación del agua subterránea utilizando IA entrenada en datos satelitales, y espera aplicar el modelo a una nueva constelación de satélites de la NASA que se instalará más adelante este año.

Zeus AI está trabajando en la producción algorítmica de «perfiles atmosféricos en 3D» basados en imágenes satelitales, esencialmente una versión gruesa de los mapas 2D que ya tenemos de temperatura, humedad, etc.

En el espacio, su poder de cómputo es muy limitado, y aunque podemos hacer algunas inferencias allí arriba, el entrenamiento es inmediato. Pero los investigadores del IEEE quieren crear un procesador neuromórfico eficiente en SWaP para entrenar modelos de IA in situ.

Los robots que operan de forma autónoma en situaciones de alto riesgo generalmente necesitan un cuidador humano, y Picknick está buscando hacer que esos bots comuniquen sus intenciones visualmente, por ejemplo, cómo alcanzarían para abrir una puerta, de modo que el cuidador no tenga que intervenir tanto. Probablemente sea una buena idea.