Google anunció hoy el lanzamiento de su nuevo modelo de lenguaje grande (LLM) Gemini y con eso, la compañía también lanzó su nuevo Cloud TPU v5p, una versión actualizada de su Cloud TPU v5e, que se lanzó a disponibilidad general a principios de este año. Un pod v5p consta de un total de 8960 chips y está respaldado por la interconexión más rápida de Google hasta el momento, con hasta 4800 Gpbs por chip.

No sorprende que Google prometa que estos chips son significativamente más rápidos que los TPU v4. El equipo afirma que el v5p presenta una mejora de 2 veces en FLOPS y una mejora de 3 veces en memoria de gran ancho de banda. Sin embargo, eso es un poco como comparar el nuevo modelo Gemini con el modelo anterior OpenAI GPT 3.5. Después de todo, el propio Google ya ha llevado el estado del arte más allá del TPU v4. Sin embargo, en muchos sentidos, los pods v5e estaban un poco por debajo del pod v4, con solo 256 chips v5e por pod versus 4096 en los pods v4 y un total de 197 TFLOP de rendimiento de punto flotante de 16 bits por chip v5e versus 275 para los chips v4. Para el nuevo v5p, Google promete hasta 459 TFLOP de rendimiento de punto flotante de 16 bits, respaldado por una interconexión más rápida.

Créditos de imagen: Google

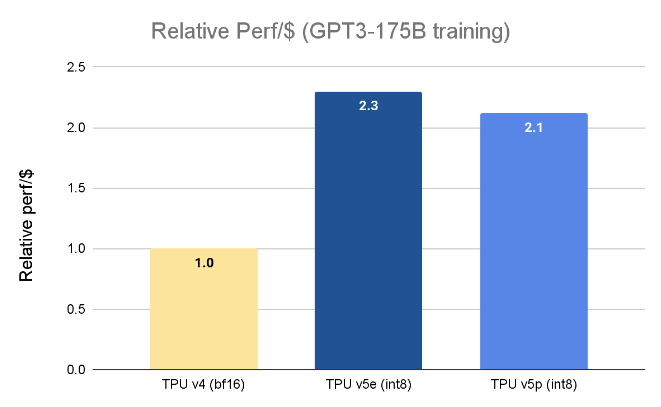

Google dice que todo esto significa que la TPU v5p puede entrenar un modelo de lenguaje grande como GPT3-175B 2,8 veces más rápido que la TPU v4, y también hacerlo de manera más rentable (aunque la TPU v5e, aunque es más lenta, en realidad ofrece un mayor rendimiento relativo). por dólar que el v5p).

Créditos de imagen: Google

“En nuestra etapa inicial de uso, Google DeepMind y Google Research han observado aceleraciones 2 veces mayores para las cargas de trabajo de capacitación LLM utilizando chips TPU v5p en comparación con el rendimiento de nuestra generación TPU v4”, escribe Jeff Dean, científico jefe de Google DeepMind y Google Research. “El sólido soporte para ML Frameworks (JAX, PyTorch, TensorFlow) y herramientas de orquestación nos permite escalar aún más eficientemente en v5p. Con la segunda generación de SparseCores también vemos una mejora significativa en el rendimiento de cargas de trabajo con muchas incorporaciones. Los TPU son vitales para permitir nuestros esfuerzos de investigación e ingeniería a mayor escala en modelos de vanguardia como Gemini”.

El nuevo TPU v5p aún no está disponible de forma generalizada, por lo que los desarrolladores tendrán que comunicarse con su administrador de cuentas de Google para estar en la lista.