Google ha encontrado una nueva forma sorprendente de ayudar a los robots a lidiar con la complejidad abierta del mundo real: enseñarles cómo entender el lenguaje.

El gigante tecnológico injertó su última tecnología de inteligencia artificial para manejar el lenguaje, llamada PaLM, en robots de Everyday Robots, una de las divisiones experimentales de la empresa matriz Alphabet. Reveló la tecnología resultante, llamada PaLM-SayCan, el martes.

Con la tecnología, el modelo de lenguaje de inteligencia artificial de Google brinda suficiente conocimiento del mundo real para ayudar a un robot a interpretar un comando humano vago y unir una secuencia de acciones para responder. Eso contrasta marcadamente con las acciones escritas con precisión que la mayoría de los robots siguen en circunstancias estrictamente controladas, como instalar parabrisas en una línea de ensamblaje de automóviles.

La tecnología es un proyecto de investigación que está listo para su estreno. Pero Google lo ha estado probando en una cocina de oficina real, no en un entorno de laboratorio más controlado, en un esfuerzo por construir robots que puedan ser útiles en el caos impredecible de nuestras vidas reales. Junto con proyectos como el bot Optimus bípedo de Tesla, las creaciones de Boston Dynamics y Astro de Amazon, muestra cómo los robots eventualmente podrían salir de la ciencia ficción.

Cuando un investigador de IA de Google le dice a un robot PaLM-SayCan: «Derramé mi bebida, ¿puedes ayudarme?» se desliza sobre sus ruedas a través de una cocina en un edificio de oficinas de Google, detecta una esponja en el mostrador con la visión de su cámara digital, la agarra con un brazo motorizado y se la lleva al investigador. El robot también puede reconocer latas de Pepsi y Coca-Cola, abrir cajones y localizar bolsas de papas fritas. Con las habilidades de abstracción de PaLM, incluso puede comprender que los tazones amarillos, verdes y azules pueden representar metafóricamente un desierto, una jungla y un océano, respectivamente.

«A medida que mejoramos los modelos de lenguaje, el rendimiento robótico también mejora», dijo Karol Hausman, científica investigadora sénior de Google que ayudó a demostrar la tecnología.

La IA ha transformado profundamente el funcionamiento de la tecnología informática y lo que puede hacer. Con la tecnología moderna de redes neuronales, modelada libremente en cerebros humanos y también llamada aprendizaje profundo, los sistemas de IA se entrenan en grandes cantidades de datos desordenados del mundo real. Después de ver miles de fotos de gatos, por ejemplo, los sistemas de inteligencia artificial pueden reconocer uno sin tener que decirles que generalmente tiene cuatro patas, orejas puntiagudas y bigotes.

Google usó una enorme máquina de 6144 procesadores para entrenar PaLM, abreviatura de Pathways Language Model, en una vasta colección multilingüe de documentos web, libros, artículos de Wikipedia, conversaciones y código de programación que se encuentran en el sitio GitHub de Microsoft. El resultado es un sistema de IA que puede explicar chistes, completar oraciones, responder preguntas y seguir su propia cadena de pensamientos para razonar.

El trabajo de PaLM-SayCan combina esta comprensión del lenguaje con las propias habilidades del robot. Cuando el robot recibe un comando, combina las sugerencias del modelo de lenguaje con un conjunto de aproximadamente 100 habilidades que ha aprendido. El robot elige la acción que obtiene la puntuación más alta tanto en el lenguaje como en las habilidades del robot.

El sistema está limitado por su entrenamiento y circunstancias, pero es mucho más flexible que un robot industrial. Cuando mi colega Claire Reilly le pide a un robot PaLM-SayCan que «me haga una hamburguesa», apila versiones de bloques de madera de panecillos, hamburguesas, lechuga y una botella de ketchup en el orden correcto.

Las habilidades y el entorno del robot ofrecen una base real para las posibilidades más amplias del modelo de lenguaje, dijo Google. «Las habilidades actuarán como el [language model’s] ‘manos y ojos'», dijeron en un artículo de investigación de PaLM-SayCan.

El resultado es un robot que puede hacer frente a un entorno más complicado. «Nuestro nivel de rendimiento es lo suficientemente alto como para que podamos ejecutar esto fuera de un entorno de laboratorio», dijo Hausman.

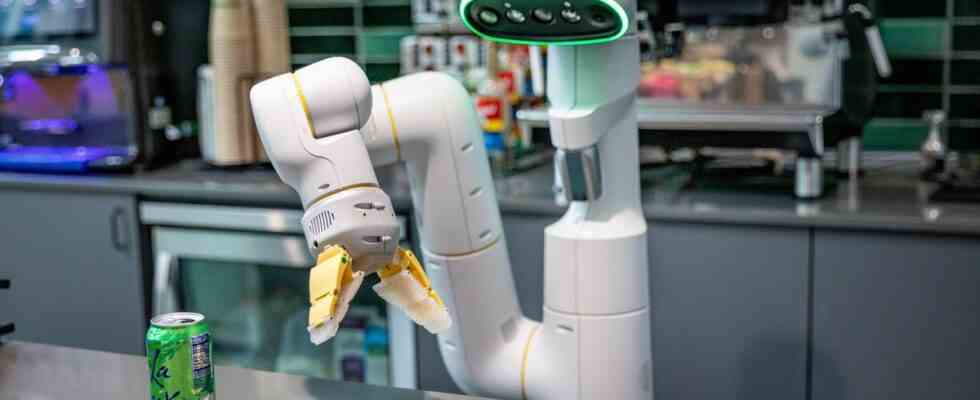

Unos 30 robots cotidianos con ruedas patrullan las oficinas de robótica de Google en Mountain View, California. Cada uno tiene una base amplia para el equilibrio y la locomoción, un tallo más grueso que se eleva hasta la altura del pecho de un ser humano para sostener una «cabeza» articulada, una cara con varias cámaras y un anillo verde brillante que indica cuando un robot está activo, un brazo de agarre articulado y un sensor lidar giratorio que utiliza láser para crear un escaneo 3D de su entorno. En la parte posterior hay un gran botón rojo de parada, pero los robots están programados para evitar colisiones.

Algunos de los robots se paran en estaciones donde aprenden habilidades como recoger objetos. Eso lleva mucho tiempo, pero una vez que un robot lo aprende, la habilidad se puede transferir a otros.

Otros robots se deslizan por las oficinas, cada uno con un solo brazo doblado hacia atrás y una cara que apunta hacia los códigos QR pegados en las ventanas, los extintores y una gran estatua de robot Android. El trabajo de estos robots ambulatorios es tratar de aprender cómo comportarse educadamente con los humanos, dijo Vincent Vanhoucke, un distinguido científico de Google y director del laboratorio de robótica.

«La IA ha tenido mucho éxito en los mundos digitales, pero aún tiene que hacer mella significativa para resolver problemas reales para personas reales en el mundo físico real», dijo Vanhoucke. «Creemos que es un gran momento en este momento para que la IA migre al mundo real».