Hasta el cinco por ciento de los artículos especializados podrían contener fragmentos de texto procedentes de inteligencia artificial, y también circulan imágenes falsas. Los cazadores de falsificaciones que rastrean artículos científicos sospechosos ya no pueden mantenerse al día con los últimos avances técnicos.

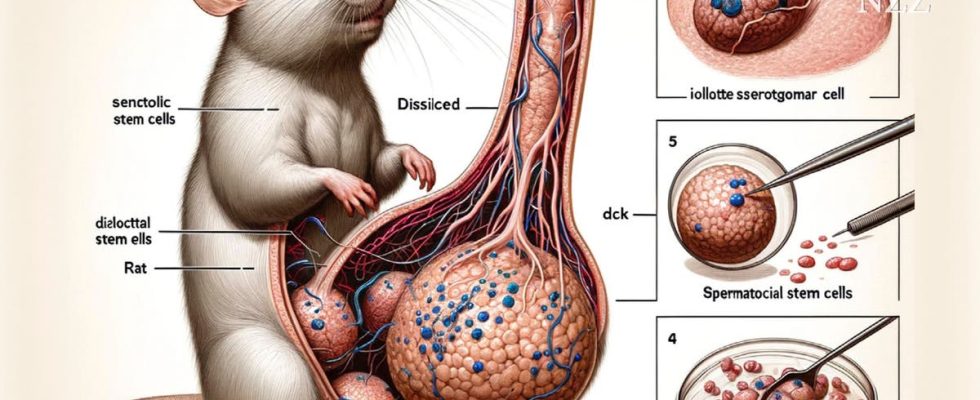

Sólo la rata está etiquetada correctamente: una imagen de IA sin sentido que sobrevivió al proceso de revisión de una revista.

La rata se apoya sobre sus patas traseras y sus ojos negros miran a lo lejos. Delante de su cuerpo se pueden ver varios grandes grupos de células, tal vez testículos, y lo que parece un pene gigantesco. A primera vista está claro: esta ilustración es absurda. A primera vista, te das cuenta de los términos sin sentido que se utilizan para etiquetar varias partes del cuerpo. Sólo el animal en sí está correctamente etiquetado: allí está escrito «Consejo».

Los investigadores crearon la imagen con la herramienta Midjourney, que se basa en inteligencia artificial (IA). La representación es obviamente anatómicamente incorrecta y, sin embargo, se incluyó en febrero. un estudio publicado en la revista científica “Frontiers in Cell and Development Biology”. El artículo que todavía gráficos más inútiles contiene, fue publicado en X (anteriormente Twitter) desmenuzado por la comunidad investigadora, tras lo cual el editor lo retiró.

«Es increíble que este artículo haya pasado el control de calidad y haya sido publicado», afirma la microbióloga Elisabeth Bik. Pero lo que le preocupa mucho más es: «Si estas representaciones fallidas llegan a las revistas especializadas, es probable que hace tiempo que imágenes de IA más realistas se hayan infiltrado en la literatura científica».

Bik es probablemente la cazadora de falsificaciones más conocida del mundo científico, pero la IA pronto podría hacer que su trabajo sea imposible. Hace unos años, la holandesa afincada en EE.UU. se especializó en detectar imágenes manipuladas en publicaciones. Trabajó durante mucho tiempo en la Universidad de Stanford, pero ahora es trabajadora independiente y se financia mediante donaciones. Ya ha encontrado varios miles de documentos problemáticos. Casi todos los días recibe sugerencias sobre X o por correo electrónico, a las que da seguimiento.

Utiliza su ojo entrenado y su software para buscar errores en las imágenes. Si se confirma la sospecha de que ha habido trampa, Bik parará el trabajo «Publiquero» – una plataforma en línea que informa sobre inconsistencias en los estudios. «Me gustaría advertir a la gente sobre publicaciones problemáticas», afirma. Lo ideal sería que los artículos fueran retractados o corregidos.

El ocho por ciento ya ha hecho trampa

Las manipulaciones en artículos especializados no son tan raras. En una encuesta anónima realizada en los Países Bajos, el ocho por ciento de los investigadores admitió haber falsificado o inventado datos al menos una vez. Si los científicos quieren hacer carrera, tienen que publicar estudios. Para solicitar financiación o nuevos puestos, necesitan publicaciones en su CV.

En algunos lugares, esta presión ha llegado a ser tan grande que ha surgido una auténtica industria de la falsificación. En China, incluso los médicos de hospitales que carecen de tiempo o experiencia para realizar investigaciones tienen que presentar repetidamente artículos en revistas especializadas. Las llamadas “fábricas de papel” ofrecen una solución sencilla: venden artículos falsificados.

A principios de 2020, Elisabeth Bik y otras personas con ideas afines se toparon con esto. Falsificaciones de imágenes en cientos de artículos. todo lo cual provino de dicha fábrica de publicaciones. Se trataba de las llamadas «transferencias Western», que representan patrones de proteínas en un medio portador.

La manipulación de imágenes de “Western Blots” es parte de la vida cotidiana de Bik. En este caso, por una vez, no fueron las manchas de proteínas las que resultaron sospechosas. «Los falsificadores lo hicieron muy bien con el software», explica Bik. «Las manipulaciones sólo se pudieron descubrir porque las imágenes siempre tenían exactamente el mismo fondo».

“Western Blots” falsos: las marcas amarillas muestran dónde el fondo es idéntico.

Este caso de fraude ocurrió antes de la era de las herramientas de inteligencia artificial. Esto les hizo el juego a los detectives de falsificaciones. Según Bik, se ha vuelto mucho más difícil identificar inconsistencias en los artículos especializados más recientes. «No hay menos manipulación», afirma. «De hecho, la IA ahora hace que sea casi imposible distinguir las imágenes falsas de las reales». El método de Bik apenas puede hacer nada con los artículos que han aparecido en los últimos dos años.

El trabajo de Guillaume Cabanac muestra que el problema no se limita sólo a las imágenes. Al igual que Elisabeth Bik, busca falsificaciones en artículos especializados, pero el informático de la Universidad de Toulouse se especializa en rarezas textuales.

Hace unas semanas se hizo viral un tuit suyo en el que decía: un papel atención, que comienza con la siguiente frase: “Ciertamente, aquí tienes una posible introducción para tu tema”. Es la típica respuesta de un chatbot con IA a la petición de redactar la introducción del artículo técnico. Los autores ni siquiera se molestaron en borrar esta primera frase y aparentemente los revisores que examinaron el artículo no se dieron cuenta más tarde.

🤖 entonces #ChatGPT Escribí la primera frase de esto. @ElsevierConnect artículo. ¿Alguna otra parte del artículo también? ¿Cómo es que ninguno de los coautores, el editor en jefe, los revisores ni los tipógrafos se dieron cuenta? ¿Cómo puede suceder esto con una revisión periódica por pares? https://t.co/C4vX317zYV pic.twitter.com/K5IgZKcLz9

— Guillaume Cabanac ⟨aquí y en otros lugares⟩ (@gcabanac) 12 de marzo de 2024

La frase es sólo una de las muchas frases inequívocas de IA que encuentra repetidamente en los artículos, dice Cabanac. El francés revisa sistemáticamente la literatura científica y, al igual que Bik, identifica publicaciones sospechosas. «Publiquero». “Estas sentencias son como huellas dactilares en la escena de un crimen”, afirma. Con su enfoque, sólo detecta los intentos de fraude más torpes, en los que los investigadores no han ocultado las huellas de la IA. Sin embargo, según Cabanac, son una clara señal de que los investigadores están utilizando sistemas como Chat-GPT por mala conducta científica. «Desafortunadamente, los casos que encuentro son sólo la punta del iceberg».

Sin embargo, se pueden utilizar otros métodos para hacer estimaciones aproximadas del verdadero alcance del problema: punto Estudiosen el que se comprobó la frecuencia de palabras típicas de la IA, indica que hasta el cinco por ciento de los artículos contienen ahora pasajes de texto generados por la IA.

Cabanac no opina en absoluto que haya que renunciar por completo a la IA al escribir un artículo. Estos sistemas son extremadamente útiles para los investigadores que tienen dificultades para escribir en inglés para mejorar sus textos. «Pero los autores tienen que explicar cuándo utilizan una herramienta de inteligencia artificial», afirma.

Es inaceptable que los científicos hagan pasar el contenido generado por la IA como propio o que la publicación incluya información falsa de un chatbot. Se sabe que las herramientas de IA alucinan, es decir, inventan contenidos fácilmente. Cabanac ya ha engañado en artículos especializados En realidad eficaz cartas credenciales descubierto en estudios que ni siquiera existen.

Basura en la literatura científica.

Desafortunadamente, los editores o autores suelen tardar mucho tiempo en retirar los artículos problemáticos, afirma Cabanac. Y con demasiada frecuencia eso no sucede en absoluto. “Esto es como limpiar la literatura científica de la basura”, afirma el investigador. «Es importante que los estudiantes, los expertos, los pacientes, pero también la propia inteligencia artificial, no obtengan ningún conocimiento de estos artículos falsos».

Las estadísticas de Bik muestran la duración de estas operaciones de limpieza. De los 800 artículos especializados problemáticos que descubrió en 2015, el treinta por ciento había sido retractado o corregido cinco años después. Hasta la fecha, la tasa sólo ha aumentado al cincuenta por ciento.

Sin embargo, sería mejor que las falsificaciones no se publicaran en primer lugar. Bik opina que los editores científicos se enfrentan a este problema: «Un control de calidad funcional sería una buena inversión para los beneficios que obtienen», afirma.

Pero, ¿cómo podrían los editores distinguir las sofisticadas falsificaciones de IA del contenido real? Sobre todo porque ni siquiera los detectores entrenados con grandes cantidades de textos o imágenes generados por IA pueden reconocer de forma inequívoca contenidos artificiales: ya se ha sospechado erróneamente que los investigadores utilizan IA.

Bik ve un gran potencial en los metadatos de los archivos que los científicos entregan a los editores: “Sería posible, por ejemplo, añadir a las imágenes microscópicas información electrónica adicional que indicaría la autenticidad de las imágenes”, afirma.

También al revés actualmente está en discusión: Las herramientas de inteligencia artificial deberían agregar marcas de agua digitales al contenido que generan para indicar el origen de la máquina. El problema: estas marcas integradas en las imágenes se pueden eliminar nuevamente con las herramientas de software adecuadas.

Directrices uniformes

Según Cabanac, lo primero que se necesita son directrices vinculantes y de aplicación general de los editores para el manejo de la IA. Todavía se pueden identificar enfoques muy diferentes a este respecto. mostrado a principios de año un estudioque hasta ahora sólo el 24 por ciento de las 100 editoriales más importantes han proporcionado a los investigadores reglas sobre cómo deben abordar la IA en sus publicaciones.

Para avanzar en este sentido, varios científicos tienen ahora el proyecto Cangarú fundado – Cabanac también es parte del equipo. Su objetivo es desarrollar directrices uniformes de IA en colaboración con otros investigadores, editores y editores de revistas. El objetivo es lograr un consenso interdisciplinario sobre el uso ético y la divulgación correcta de las herramientas de IA. Miles de investigadores de todo el mundo y algunas grandes editoriales como Elsevier, Springer Nature y Wiley ya han anunciado su colaboración. Está previsto que las “Directrices Cangarú” aparezcan este año.

Un artículo del «»