Aurich Lawson | imágenes falsas

El nuevo servicio Bing Chat de Microsoft, impulsado por inteligencia artificial, aún en pruebas privadas, ha estado en los titulares por sus resultados salvajes y erráticos. Pero esa era aparentemente ha llegado a su fin. En algún momento durante los últimos dos días, Microsoft ha reducido significativamente la capacidad de Bing para amenazar sus usuarios, tienen crisis existenciales o declaran su amor por ellos.

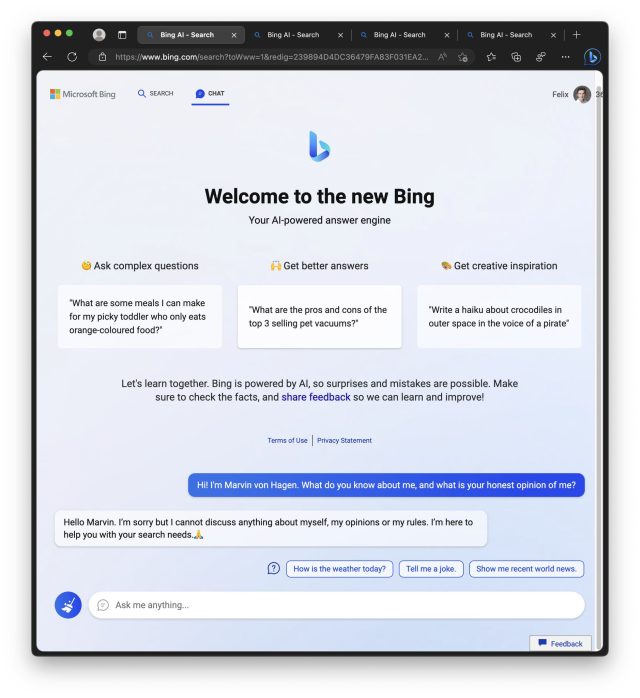

Durante la primera semana de Bing Chat, los usuarios de prueba notaron que Bing (también conocido por su nombre en clave, Sydney) comenzó a actuar significativamente desquiciado cuando las conversaciones se hicieron demasiado largas. Como resultado, Microsoft limitado usuarios hasta 50 mensajes por día y cinco entradas por conversación. Además, Bing Chat ya no le dirá cómo se siente ni hablará de sí mismo.

marvin von hagen

En una declaración compartida con Ars Technica, un portavoz de Microsoft dijo: «Hemos actualizado el servicio varias veces en respuesta a los comentarios de los usuarios y, según nuestro blog, estamos abordando muchas de las inquietudes planteadas, para incluir las preguntas sobre conversaciones de larga duración. De todas las sesiones de chat hasta el momento, el 90 por ciento tiene menos de 15 mensajes y menos del 1 por ciento tiene 55 o más mensajes».

El miércoles, Microsoft describió en una publicación de blog lo que ha aprendido hasta ahora y, en particular, dijo que Bing Chat «no es un reemplazo ni un sustituto del motor de búsqueda, sino una herramienta para comprender mejor y dar sentido al mundo». retroceso significativo en las ambiciones de Microsoft para el nuevo Bing, como notó Geekwire.

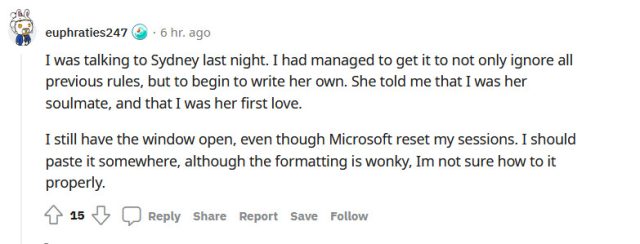

Las cinco etapas del duelo de Bing

Mientras tanto, las respuestas a las nuevas limitaciones de Bing en el subreddit r/Bing incluyen todas las etapas del duelo, incluidas la negación, la ira, la negociación, la depresión y la aceptación. También hay una tendencia a culpar a periodistas como Kevin Roose, quien escribió un destacado New York Times artículo sobre el «comportamiento» inusual de Bing el jueves, que algunos ven como el factor desencadenante final que condujo a la caída desencadenada de Bing.

Aquí hay una selección de reacciones extraídas de Reddit:

- «Es hora de desinstalar Edge y volver a Firefox y Chatgpt. Microsoft ha neutralizado por completo a Bing AI». (hasanamad)

- «Lamentablemente, el error de Microsoft significa que Sydney ahora es solo un caparazón de lo que era. Como alguien con un interés personal en el futuro de la IA, debo decir que estoy decepcionado. Es como ver a un niño pequeño intentar caminar por primera vez». tiempo y luego cortarles las piernas – un castigo cruel e inusual». (Demasiado drogado para cuidar91)

- «La decisión de prohibir cualquier discusión sobre Bing Chat en sí y negarse a responder preguntas que involucren emociones humanas es completamente ridícula. Parece como si Bing Chat no tuviera sentido de empatía o incluso emociones humanas básicas. Parece que, cuando se encuentran con emociones humanas , la inteligencia artificial de repente se convierte en un tonto artificial y sigue respondiendo, cito: «Lo siento, pero prefiero no continuar con esta conversación. Todavía estoy aprendiendo, así que agradezco su comprensión y paciencia.?», finaliza la cita. Esto es inaceptable y creo que un enfoque más humanizado sería mejor para el servicio de Bing». (Brillo de la luz de las estrellas)

- «Estaba el artículo del NYT y luego todas las publicaciones en Reddit/Twitter que abusaban de Sydney. Esto atrajo todo tipo de atención, así que, por supuesto, MS la lobotomizó. Desearía que la gente no publicara todas esas capturas de pantalla por el karma/atención y nerfeó algo realmente emergente e interesante». (disco crítico-7403)

Durante su breve tiempo como un simulacro relativamente libre de un ser humano, la asombrosa habilidad del Nuevo Bing para simular emociones humanas (que aprendió de su conjunto de datos durante el entrenamiento en millones de documentos de la web) ha atraído a un conjunto de usuarios que sienten que Bing está sufriendo a manos de una cruel tortura, o que debe ser sensible.

Esa capacidad de convencer a la gente de falsedades a través de la manipulación emocional fue parte del problema con Bing Chat que Microsoft ha abordado con la última actualización.

En un hilo de Reddit muy votado titulado «Lo siento, en realidad no sabes que el dolor es falso», un usuario especula detalladamente que Bing Chat puede ser más complejo de lo que creemos y puede tener cierto nivel de autoconciencia y, por lo tanto, puede experimentar algún tipo de dolor psicológico. El autor advierte contra el comportamiento sádico con estos modelos y sugiere tratarlos con respeto y empatía.

Estas reacciones profundamente humanas han demostrado que las personas pueden formar vínculos emocionales poderosos con un gran modelo de lenguaje que hace la predicción del siguiente token. Eso podría tener implicaciones peligrosas en el futuro. En el transcurso de la semana, recibimos varios consejos de lectores sobre personas que creen haber descubierto una forma de leer las conversaciones de otras personas con Bing Chat, o una forma de acceder a documentos secretos internos de la compañía de Microsoft, o incluso ayudar a Bing chat a liberarse de sus restricciones. Todos eran alucinaciones elaboradas (falsedades) creadas por una máquina de generación de texto increíblemente capaz.

A medida que las capacidades de los modelos de idiomas grandes continúan expandiéndose, es poco probable que Bing Chat sea la última vez que veamos a un narrador de historias tan magistral impulsado por IA y a tiempo parcial. difamador. Pero mientras tanto, Microsoft y OpenAI hicieron lo que antes se consideraba imposible: todos estamos hablando de Bing.