Lo que necesitas saber

- TensorRT-LLM está agregando compatibilidad con Chat API de OpenAI para computadoras de escritorio y portátiles con GPU RTX a partir de 8 GB de VRAM.

- Los usuarios pueden procesar consultas de LLM más rápido y localmente sin cargar conjuntos de datos a la nube.

- NVIDIA combina esto con la «Generación aumentada de recuperación» (RAG), lo que permite casos de uso de LLM más personalizados.

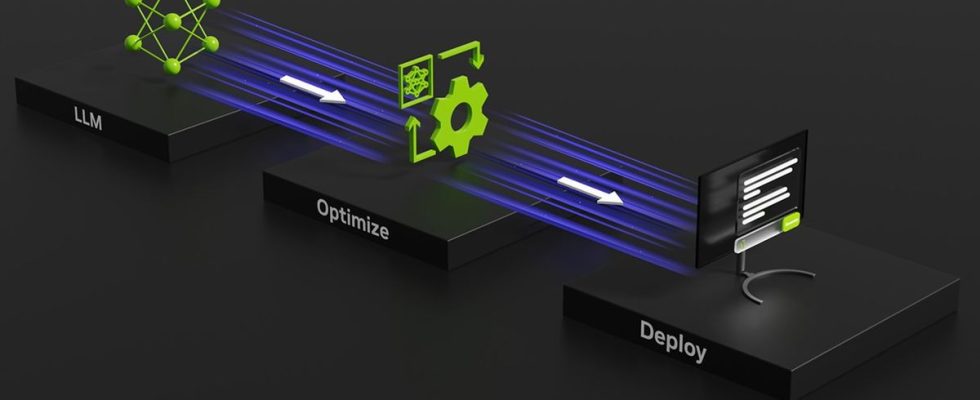

Durante la conferencia Ignite de Microsoft hoy, NVIDIA anunció una actualización de su TensorRT-LLM, que lanzado en octubre. Los principales anuncios de hoy son que la función TensorRT-LLM ahora está ganando soporte para las API de LLM, específicamente OpenAI Chat API, que es la más conocida en este momento, y también que han trabajado para mejorar el rendimiento con TensorRT-LLM para obtener mejor rendimiento por token en sus GPU.

Hay un anuncio terciario que es bastante interesante también. NVIDIA incluirá la generación aumentada de recuperación con TensorRT-LLM. Esto permite a un LLM utilizar una fuente de datos externa para su base de conocimientos en lugar de depender de cualquier cosa en línea, una característica muy demandada para la IA.

¿Qué es TensorRT-LLM?

LEER MÁS DE IGNITE 2023

NVIDIA lanzó recientemente NVIDIA TensorRT-LLM, una biblioteca de código abierto que permite la computación local de LLM en hardware NVIDIA. NVIDIA promociona esto para ganar privacidad y eficiencia al tratar con grandes conjuntos de datos o información privada. Si esa información se envía a través de una API como la API Chat de OpenAI es segura. Puede obtener más información sobre NVIDIA TensorRT-LLM en Sitio para desarrolladores de NVIDIA.

Los cambios anunciados hoy en NVIDIA TensorRT-LLM son la adición de la API de chat de OpenAI y mejoras de rendimiento para LLM y modelos de IA previamente compatibles, como Llama 2 y Stable Diffusion, a través de mejoras de DirectML.

Esta tecnología y computación se pueden realizar localmente a través de Banco de trabajo de IA de NVIDIA. Este «kit de herramientas unificado y fácil de usar permite a los desarrolladores crear, probar y personalizar rápidamente modelos de IA generativa y LLM previamente entrenados en una PC o estación de trabajo». NVIDIA tiene una página de registro de acceso temprano para aquellos interesados en utilizarlo.

NVIDIA TensorRT-LLM es una biblioteca de código abierto que acelera y optimiza el rendimiento de inferencia de los últimos modelos de lenguajes grandes (LLM) en la plataforma NVIDIA AI.

Nvidia

Nvidia también está mostrando una mejora en el rendimiento por token para los LLM, como podemos ver en estos puntos de referencia internos de NVIDIA. Como siempre, tenga cuidado con los puntos de referencia y las pruebas de los fabricantes para obtener informes precisos sobre la mejora del rendimiento.

Ahora que conocemos TensorRT-LLM de NVIDIA, ¿por qué es especial o útil? En su mayor parte, la ejecución local en una estación de trabajo o PC con tecnología NVIDIA probablemente dará como resultado las mismas respuestas a las consultas, aunque probablemente a un ritmo más lento debido a la falta de potencia de computación en la nube.

La imagen de NVIDIA para este caso de uso se combina cuando se analiza el otro anuncio de hoy de NVIDIA, a saber, la integración con una nueva tecnología o función llamada Generación aumentada de recuperación.

¿Qué es la generación de recuperación aumentada?

El término generación de recuperación aumentada fue acuñado en un papel por una serie de autores, siendo el autor principal Patrick Lewis. Es el nombre que está adoptando la industria para una solución a un problema que todos los que han utilizado un LLM han encontrado. Información desactualizada o correcta pero errónea en el contexto de la discusión. Los detalles detallados de cómo funciona RAG se pueden encontrar en uno de los de NVIDIA. Resúmenes técnicos.

La generación de recuperación aumentada es una técnica para mejorar la precisión y confiabilidad de los modelos generativos de IA con datos obtenidos de fuentes externas.

Rick Merritt

Al combinar la generación de recuperación aumentada con TensorRT-LLM de NVIDIA, los usuarios finales pueden personalizar a qué información tiene acceso el LLM cuando ejecuta sus consultas. ChatGPT anunciado recientemente GPT personalizados que podría ofrecer resultados similares.

Como se analizó en nuestro artículo sobre GPT personalizados, la capacidad de crear instancias LLM personalizadas y de propósito único con un GPT personalizado o, en este caso, una instancia LLM que, mediante generación de recuperación aumentada, solo tiene acceso a todos los Los trabajos publicados de Charles Dickens y nada más, podrían ayudar a crear LLM específicos, significativos y precisos para diferentes casos de uso.

¿Será útil TensorRT-LLM?

¿Qué significa todo esto junto? Existen algunas oportunidades reales para que esto se utilice de manera significativa. ¿Qué tan fácil será de implementar o qué tan seguros serán los datos? Sólo el tiempo dirá. Aquí existe potencial para mejoras en la IA, especialmente a nivel empresarial, para mejorar los flujos de trabajo, ofrecer un acceso más conveniente a información complicada y ayudar a los empleados con tareas desafiantes.

Aunque estas tareas se ejecutarán localmente, seguirán pasando por las API de LLM normales, que enfrentarán las mismas restricciones y limitaciones de contenido que ahora. Sin embargo, como tecnologías como TensorRT-LLM de NVIDIA hacen que sea más rápido usar un LLM sin conexión, alguien podría integrarlo con algo como MalGPTque no tiene limitaciones en su conducta y actualmente se utiliza para crear malware y ayudar en ataques cibernéticos, el potencial de que una IA cause algún daño real solo se amplifica.

¿Qué opinas de las actualizaciones de NVIDIA a TensorRT-LLM? ¿Se te ocurre algún uso que me haya pasado por alto? Háganos saber en los comentarios.