Hoy, NVIDIA anunció que sus primeros sistemas DGX H100 se enviarán a clientes de todo el mundo para avanzar en las cargas de trabajo de IA.

Los sistemas impulsados por GPU NVIDIA DGX H100 ahora se envían a todo el mundo para potenciar las cargas de trabajo de IA

Anunciado en GTX 2022, NVIDIA Hopper H100 se tituló el primer y más rápido chip de centro de datos de 4 nm del mundo, que ofrece hasta 4000 TFLOP de potencia de cómputo de IA. Con una nueva arquitectura de GPU con 80 000 millones de transistores, una memoria HBM3 ultrarrápida y capacidades NVLINK, este chip se destinó específicamente a varias cargas de trabajo, incluidas la inteligencia artificial (IA), el aprendizaje automático (ML), las redes neuronales profundas (DNN) y varias Cargas de trabajo informáticas centradas en HPC.

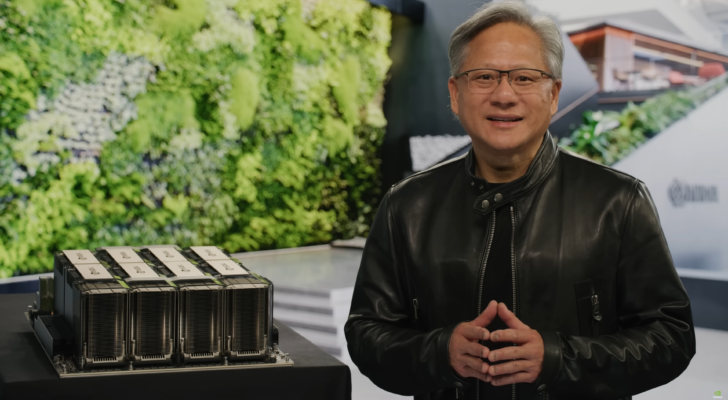

Ahora, los primeros sistemas DGX H100 Hopper se envían a clientes de Tokio a Estocolmo, dice NVIDIA. En su prensa, la compañía afirma que las GPU Hopper H100 nacieron para ejecutar la IA generativa que ha conquistado al mundo con herramientas como ChatGPT (GPT-4). El CEO, Jensen Huang, ya calificó a ChatGPT como una de las mejores cosas jamás hechas para la informática y dijo que es el momento iPhone de la IA. La compañía ha visto una gran demanda de sus GPU de IA, lo que ha provocado que sus acciones se disparen.

NVIDIA está a la cabeza en la potenciación de algunos de los principales clientes de centros de datos del mundo responsables de potenciar estas herramientas generativas. Algunas empresas se enumeran a continuación:

Boston Dynamics AI Institute (The AI Institute), una organización de investigación que tiene sus raíces en Boston Dynamics, el conocido pionero en robótica, utilizará un DGX H100 para perseguir esa visión. Los investigadores imaginan robots móviles diestros que ayudan a las personas en fábricas, almacenes, sitios de desastres y, finalmente, hogares.

Scissero tiene oficinas en Londres y Nueva York, y emplea un chatbot con tecnología GPT para hacer que los procesos legales sean más eficientes. Su Scissero GPT puede redactar documentos legales, generar informes y realizar investigaciones legales.

En Alemania, DeepL utilizará varios sistemas DGX H100 para ampliar servicios como la traducción entre docenas de idiomas que ofrece a los clientes, incluida Nikkei, la editorial más grande de Japón. DeepL lanzó recientemente un asistente de escritura de IA llamado DeepL Write.

En Tokio, los DGX H100 ejecutarán simulaciones e IA para acelerar el proceso de descubrimiento de fármacos como parte de la supercomputadora Tokyo-1. Xeureka, una startup lanzada en noviembre de 2021 por Mitsui & Co. Ltd., uno de los conglomerados más grandes de Japón, administrará el sistema.

nvidia

Pero eso no es todo. Verá, NVIDIA ha estado pasando lentamente de ser una empresa de hardware a una empresa y proveedor de software. Hacer hardware como GPU y sistemas HPC es una cosa, pero manejarlos es una tarea más importante. Para este propósito, NVIDIA tiene una gran cantidad de software que está diseñado para exprimir cada bit de jugo de sus GPU. Las suites de software como Base Command y AI Enterprise de NVIDIA y todo el marco CUDA son solo componentes básicos de toda la pila de software de NVIDIA disponible para sus clientes y socios.

«En NVIDIA, dedicamos el 20 % de nuestro tiempo al hardware y el 80 % al software.

Trabajamos continuamente en los algoritmos para comprender lo que nuestro hardware puede y no puede hacer. La IA es un problema completo».

– Manuvir Das, responsable de informática empresarial$NVDA… pic.twitter.com/zFM4XNbjVJ

— Simón Erickson (@7Innovator) 1 de mayo de 2023

La pila de software de NVIDIA ha evolucionado hasta tal punto a lo largo de los años que el director de informática empresarial de NVIDIA, Manuvir Das, dijo durante el evento Future Compute que ahora NVIDIA dedica el 20 % de su tiempo al hardware y el 80 % al software. También dijo que la compañía está trabajando continuamente en algoritmos que les ayuden a comprender lo que su hardware puede y no puede hacer.

El gigante de la GPU y el fabricante de chips también aprovecharán su propia destreza de inteligencia artificial para desarrollar la GPU de próxima generación. Con la ayuda de Machine Learning, NVIDIA podrá fabricar chips «mejores que los humanos» y, junto con cuLitho, los mismos chips se diseñarán y fabricarán 40 veces más rápido que los diseños tradicionales. NVIDIA está trabajando con ASML y TSMC para ayudar con la adopción de esta tecnología.

En los puntos de referencia recientes publicados por MLPerf, las GPU de NVIDIA, incluida la Hopper H100, vieron una mejora drástica en el rendimiento de las tareas de IA, como la inferencia y el aprendizaje profundo. Una vez más, esto se logra gracias a las actualizaciones continuas de la pila de software y la innovación que continúa creciendo.