Nvidia acaba de publicar algunos números de rendimiento nuevos para su GPU de cómputo H100 en MLPerf 3.0, la última versión de un importante punto de referencia para cargas de trabajo de aprendizaje profundo. El procesador Hopper H100 no solo supera a su predecesor A100 en las mediciones de tiempo de entrenamiento, sino que está ganando rendimiento gracias a las optimizaciones de software. Además, Nvidia también reveló las primeras comparaciones de rendimiento de su GPU de cómputo compacta L4 compacta con su predecesora, la GPU T4.

Nvidia publicó por primera vez los resultados de la prueba H100 obtenidos en el benchmark MLPerf 2.1 en septiembre de 2022, revelando que su GPU de cómputo insignia puede vencer a su predecesor A100 hasta 4.3–4.4 veces en varias cargas de trabajo de inferencia. Los números de rendimiento recientemente publicados obtenidos en MLPerf 3.0 no solo confirman que el H100 de Nvidia es más rápido que su A100 (no es de extrañar), sino que reafirma que también es tangiblemente más rápido que el procesador Xeon Platinum 8480+ (Sapphire Rapids) recientemente lanzado de Intel, así como el procesador de NeuChips. ReccAccel N3000 y las soluciones Cloud AI 100 de Qualcomm en una gran cantidad de cargas de trabajo

Estas cargas de trabajo incluyen clasificación de imágenes (ResNet 50 v1.5), procesamiento de lenguaje natural (BERT Large), reconocimiento de voz (RNN-T), imágenes médicas (3D U-Net), detección de objetos (RetinaNet) y recomendación (DLRM). Nvidia destaca que sus GPU no solo son más rápidas, sino que tienen un mejor soporte en toda la industria de ML: algunas de las cargas de trabajo fallaron en las soluciones de la competencia.

Sin embargo, hay una trampa con los números publicados por Nvidia. Los proveedores tienen la opción de enviar sus resultados de MLPerf en dos categorías: cerrados y abiertos. En la categoría cerrada, todos los proveedores deben ejecutar redes neuronales matemáticamente equivalentes, mientras que en la categoría abierta pueden modificar las redes para optimizar el rendimiento de su hardware. Los números de Nvidia solo reflejan la categoría cerrada, por lo que las optimizaciones que Intel u otros proveedores pueden introducir para optimizar el rendimiento de su hardware no se reflejan en los resultados de este grupo.

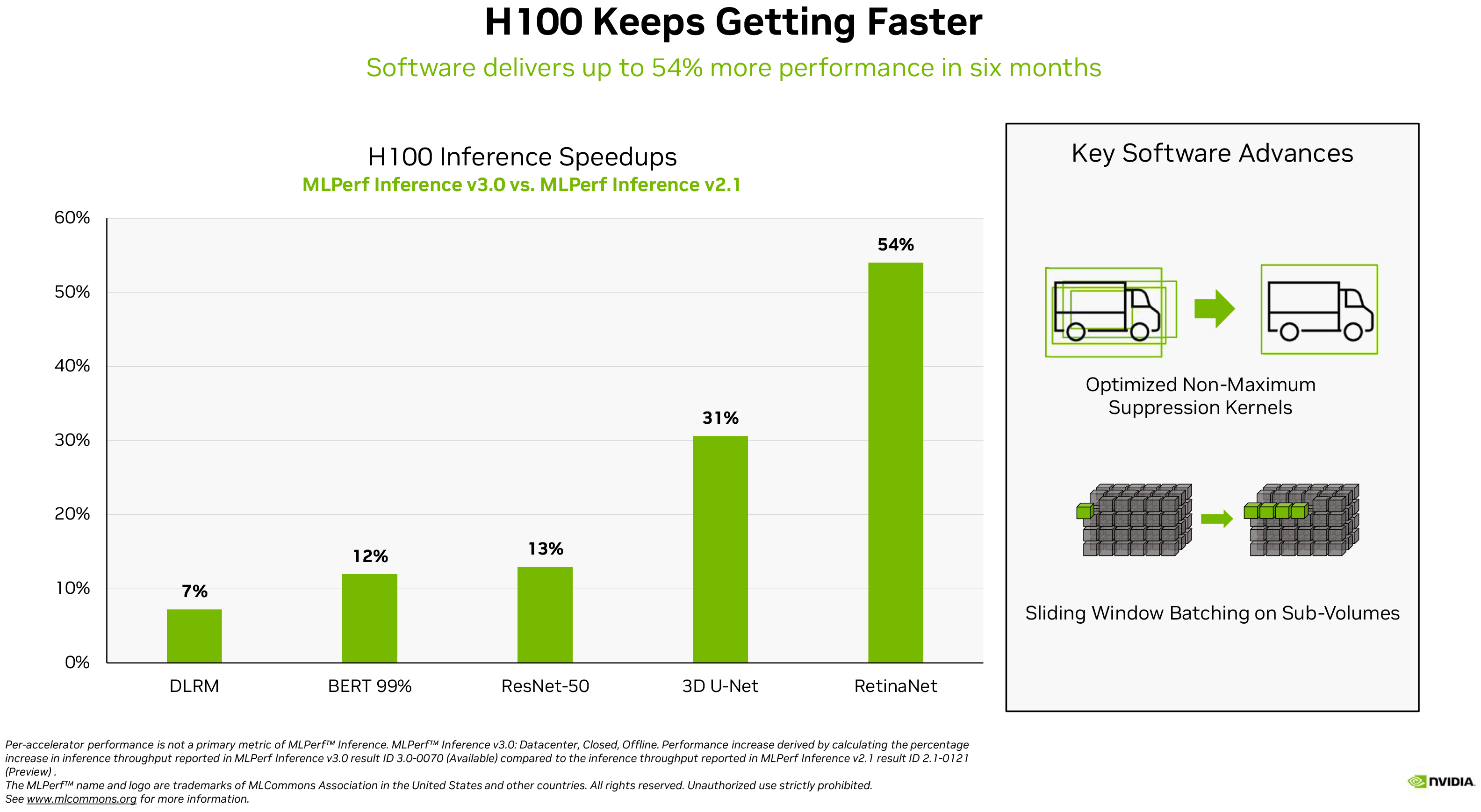

Las optimizaciones de software pueden traer grandes beneficios al hardware de IA moderno, como muestra el propio ejemplo de Nvidia. El H100 de la empresa ganó entre un 7 % en cargas de trabajo de recomendación y un 54 % en cargas de trabajo de detección de objetos con MLPerf 3.0 frente a MLPerf 2.1, lo que representa una mejora considerable del rendimiento.

Haciendo referencia a la explosión de ChatGPT y servicios similares, Dave Salvator, Director de IA, Benchmarking y Cloud, en Nvidia, escribe en una publicación de blog: «En este momento iPhone de IA, el rendimiento en la inferencia es vital… El aprendizaje profundo ahora está siendo implementado en casi todas partes, impulsando una necesidad insaciable de rendimiento de inferencia desde las plantas de producción hasta los sistemas de recomendación en línea».

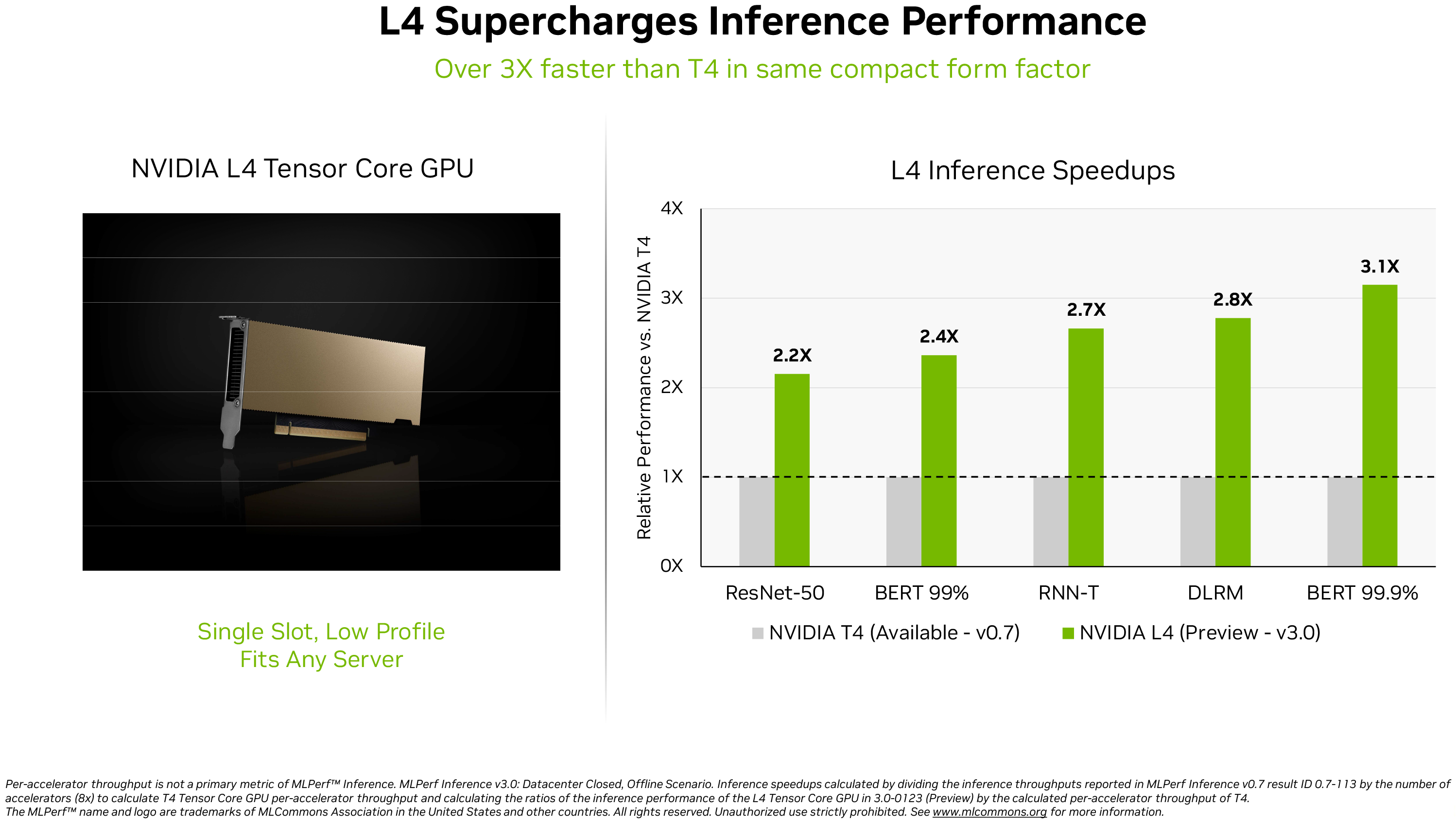

Además de reafirmar que su H100 es el rey del rendimiento de inferencia en MLPerf 3.0, la compañía también dio un adelanto del rendimiento de su GPU de cómputo L4 basada en AD104 recientemente lanzada. (se abre en una pestaña nueva). Esta tarjeta GPU de cómputo con tecnología Ada Lovelace viene en un factor de forma de perfil bajo de una sola ranura para adaptarse a cualquier servidor, pero ofrece un rendimiento formidable: hasta 30.3 FP32 TFLOPS para cómputo general y hasta 485 FP8 TFLOPS (con escasez ).

Nvidia solo comparó su L4 con una de sus otras GPU compactas para centros de datos, la T4. Esta última se basa en la GPU TU104 con la arquitectura Turing de 2018, por lo que no sorprende que la nueva GPU sea entre 2,2 y 3,1 veces más rápida que la predecesora en MLPerf 3.0, según la carga de trabajo.

«Además del rendimiento estelar de la IA, las GPU L4 ofrecen una decodificación de imágenes hasta 10 veces más rápida, un procesamiento de video hasta 3,2 veces más rápido y un rendimiento de representación en tiempo real y gráficos más de 4 veces más rápido», escribió Salvator.

Sin duda, los resultados de referencia de las GPU de cómputo H100 y L4 de Nvidia, que ya ofrecen los principales fabricantes de sistemas y proveedores de servicios en la nube, parecen impresionantes. Aún así, tenga en cuenta que estamos tratando con números de referencia publicados por la propia Nvidia en lugar de pruebas independientes.