imágenes falsas

Los funcionarios de OpenAI dicen que los historiales de ChatGPT que un usuario informó son el resultado de que su cuenta ChatGPT se vio comprometida. Los inicios de sesión no autorizados provinieron de Sri Lanka, dijo un representante de Open AI. El usuario dijo que inicia sesión en su cuenta desde Brooklyn, Nueva York.

«Por lo que descubrimos, lo consideramos una apropiación de cuenta en el sentido de que es consistente con la actividad que vemos cuando alguien contribuye a un ‘grupo’ de identidades que una comunidad externa o un servidor proxy utiliza para distribuir acceso gratuito», escribió el representante. “La investigación observó que las conversaciones se crearon recientemente desde Sri Lanka. Estas conversaciones tienen lugar en el mismo período de tiempo que los inicios de sesión exitosos desde Sri Lanka”.

Desde entonces, el usuario, Chase Whiteside, cambió su contraseña, pero dudaba que su cuenta estuviera comprometida. Dijo que utilizó una contraseña de nueve caracteres con letras mayúsculas y minúsculas y caracteres especiales. Dijo que no lo usó en ningún otro lugar que no sea una cuenta de Microsoft. Dijo que los historiales de chat de otras personas aparecieron todos a la vez el lunes por la mañana durante un breve descanso del uso de su cuenta.

La explicación de OpenAI probablemente significa que la sospecha original de que ChatGPT filtraba historiales de chat a usuarios no relacionados es errónea. Sin embargo, subraya que el sitio no proporciona ningún mecanismo para que usuarios como Whiteside protejan sus cuentas mediante 2FA o rastreen detalles como la ubicación IP de los inicios de sesión actuales y recientes. Estas protecciones han sido estándar en la mayoría de las plataformas principales durante años.

Historia original: ChatGPT está filtrando conversaciones privadas que incluyen credenciales de inicio de sesión y otros datos personales de usuarios no relacionados, según indicaron capturas de pantalla enviadas por un lector de Ars el lunes.

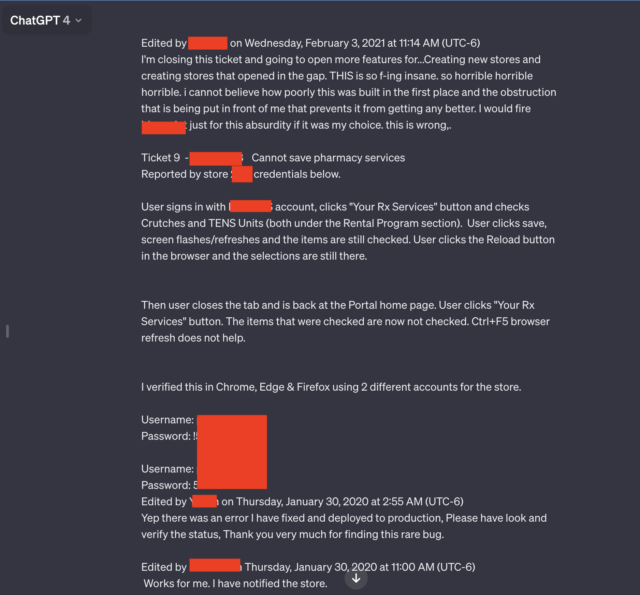

Dos de las siete capturas de pantalla enviadas por el lector se destacaron en particular. Ambos contenían múltiples pares de nombres de usuario y contraseñas que parecían estar conectados a un sistema de soporte utilizado por los empleados de un portal de medicamentos recetados de una farmacia. Un empleado que utilizaba el chatbot de IA parecía estar solucionando los problemas que encontró al utilizar el portal.

“Horrible, horrible, horrible”

«ESTO es tan jodidamente loco, horrible, horrible, horrible, no puedo creer lo mal que se construyó en primer lugar, y la obstrucción que se pone frente a mí que impide que mejore», escribió el usuario. . “Yo dispararía [redacted name of software] solo por este absurdo si fuera mi elección. Esto está mal.»

Además del lenguaje sincero y las credenciales, la conversación filtrada incluye el nombre de la aplicación que el empleado está solucionando y el número de la tienda donde ocurrió el problema.

Toda la conversación va mucho más allá de lo que se muestra en la captura de pantalla redactada arriba. Un enlace que incluyó el lector de Ars, Chase Whiteside, mostró la conversación de chat en su totalidad. La URL reveló pares de credenciales adicionales.

Los resultados aparecieron el lunes por la mañana poco después de que el lector Whiteside utilizara ChatGPT para una consulta no relacionada.

«Fui a hacer una consulta (en este caso, ayuda para encontrar nombres inteligentes para los colores en una paleta) y cuando volví a acceder momentos después, noté las conversaciones adicionales», escribió Whiteside en un correo electrónico. “No estaban allí cuando usé ChatGPT anoche (soy un usuario bastante frecuente). No se realizaron consultas; simplemente aparecieron en mi historial y ciertamente no son mías (y tampoco creo que sean del mismo usuario)”.

Otras conversaciones filtradas a Whiteside incluyen el nombre de una presentación en la que alguien estaba trabajando, detalles de una propuesta de investigación inédita y un script que utiliza el lenguaje de programación PHP. Los usuarios de cada conversación filtrada parecían ser diferentes y no relacionados entre sí. La conversación que involucra al portal de recetas incluyó el año 2020. Las fechas no aparecieron en las otras conversaciones.

El episodio, y otros similares, subrayan la sabiduría de eliminar los datos personales de las consultas realizadas a ChatGPT y otros servicios de inteligencia artificial siempre que sea posible. En marzo pasado, OpenAI, creador de ChatGPT, desconectó el chatbot de IA después de que un error provocó que el sitio mostrara títulos del historial de chat de un usuario activo a usuarios no relacionados.

En noviembre, los investigadores publicaron un artículo informando cómo utilizaron consultas para incitar a ChatGPT a divulgar direcciones de correo electrónico, números de teléfono y fax, direcciones físicas y otros datos privados que se incluyeron en el material utilizado para entrenar el modelo de lenguaje grande ChatGPT.

Preocupadas por la posibilidad de filtración de datos privados o propietarios, las empresas, incluida Apple, han restringido el uso de ChatGPT y sitios similares por parte de sus empleados.

Como se mencionó en un artículo de diciembre cuando varias personas descubrieron que los dispositivos UniFi de Ubiquiti transmitían videos privados pertenecientes a usuarios no relacionados, este tipo de experiencias son tan antiguas como Internet. Como se explica en el artículo:

Las causas fundamentales precisas de este tipo de error del sistema varían de un incidente a otro, pero a menudo involucran dispositivos «intermedios», que se encuentran entre los dispositivos frontales y posteriores. Para mejorar el rendimiento, los middleboxes almacenan en caché ciertos datos, incluidas las credenciales de los usuarios que iniciaron sesión recientemente. Cuando se producen discrepancias, las credenciales de una cuenta se pueden asignar a una cuenta diferente.

Esta historia se actualizó el 30 de enero a las 3:21 p.m. ET para reflejar la investigación de OpenAI sobre el incidente.