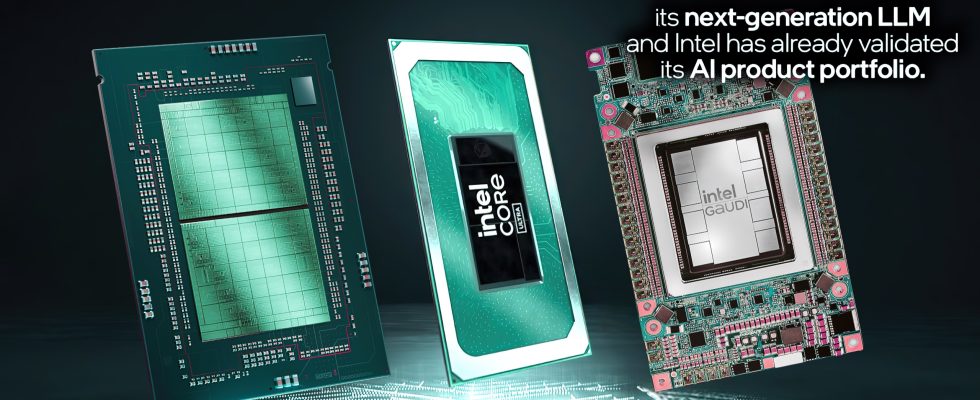

Por qué es importante: Como parte de su misión de llevar la IA a todas partes, Intel invierte en software y ecosistema de IA para garantizar que sus productos estén preparados para las últimas innovaciones en el espacio dinámico de la IA. En el centro de datos, los procesadores Gaudi y Xeon con aceleración Advanced Matrix Extension (AMX) brindan a los clientes opciones para cumplir con requisitos dinámicos y de amplio alcance.

Los procesadores Intel Core Ultra y los productos gráficos Arc brindan un vehículo de desarrollo local y una implementación en millones de dispositivos con soporte para marcos y herramientas de software integrales, incluidos PyTorch e Intel Extension para PyTorch utilizados para investigación y desarrollo local y el kit de herramientas OpenVINO para desarrollo e inferencia de modelos. .

Acerca de Llama 3 ejecutándose en Intel: Las pruebas iniciales y los resultados de rendimiento de Intel para los modelos Llama 3 8B y 70B utilizan software de código abierto, incluidos PyTorch, DeepSpeed, la biblioteca Optimum Habana e Intel Extension para PyTorch para proporcionar las últimas optimizaciones de software.

- Los aceleradores Intel Gaudi 2 han optimizado el rendimiento en los modelos Llama 2 (parámetros 7B, 13B y 70B) y ahora tienen mediciones de rendimiento iniciales para el nuevo modelo Llama 3. Con la madurez del software Gaudí, Intel ejecutó fácilmente el nuevo modelo Llama 3 y generó resultados para inferencias y ajustes. Llama 3 también cuenta con el apoyo del acelerador Gaudí 3 recientemente anunciado.

- Los procesadores Intel Xeon abordan cargas de trabajo exigentes de IA de extremo a extremo e Intel invierte en optimizar los resultados de LLM para reducir la latencia. Los procesadores Xeon 6 con núcleos de rendimiento (cuyo nombre en código es Granite Rapids) muestran una mejora del doble en la latencia de inferencia de Llama 3 8B en comparación con los procesadores Xeon de cuarta generación y la capacidad de ejecutar modelos de lenguaje más grandes, como Llama 3 70B, por debajo de 100 ms por token generado.

- Intel Core Ultra y Arc Graphics ofrecen un rendimiento impresionante para Llama 3. En una ronda inicial de pruebas, los procesadores Core Ultra ya generan velocidades de lectura humanas más rápidas que las típicas. Además, la GPU Arc A770 tiene Xmi Aceleración de IA Matrix eXtensions (XMX) y 16 GB de memoria dedicada para proporcionar un rendimiento excepcional para cargas de trabajo de LLM.

Procesadores escalables Xeon

Intel ha estado optimizando continuamente la inferencia LLM para plataformas Xeon. Como ejemplo, en comparación con el lanzamiento de Llama 2, las mejoras del software en PyTorch e Intel Extension para PyTorch han evolucionado para ofrecer una reducción de latencia 5 veces mayor. La optimización utiliza la atención paginada y el tensor paralelo para maximizar la utilización informática disponible y el ancho de banda de la memoria. La Figura 1 muestra el rendimiento de la inferencia de Meta Llama 3 8B en la instancia AWS m7i.metal-48x, que se basa en el procesador escalable Xeon de cuarta generación.

Comparamos Meta Llama 3 en un procesador Xeon 6 con núcleos Performance (anteriormente llamado Granite Rapids) para compartir una vista previa del rendimiento. Estos números de vista previa demuestran que Xeon 6 ofrece una mejora del doble en la latencia de inferencia de Llama 3 8B en comparación con los procesadores Xeon de cuarta generación ampliamente disponibles, y la capacidad de ejecutar modelos de lenguaje más grandes, como Llama 3 70B, por debajo de 100 ms por token generado en un solo dos. servidor de socket.

| Modelo | TP | Precisión | Longitud de entrada | Longitud de salida | Rendimiento | Latencia* | Lote |

| Meta-Llama-3-8B-Instrucción | 1 | fp8 | 2k | 4k | 1549.27

token/seg |

7.747

EM |

12 |

| Meta-Llama-3-8B-Instrucción | 1 | bf16 | 1k | 3k | 469.11

token/seg |

8.527

EM |

4 |

| Meta-Llama-3-70B-Instrucción | 8 | fp8 | 2k | 4k | 4927.31

token/seg |

56,23

EM |

277 |

| Meta-Llama-3-70B-Instrucción | 8 | bf16 | 2k | 2k | 3574.81

token/seg |

60.425

EM |

216 |

Plataformas de clientes

En una ronda inicial de evaluación, el procesador Intel Core Ultra ya genera velocidades de lectura más rápidas que las típicas de los humanos. Estos resultados están impulsados por la GPU Arc integrada con 8 núcleos Xe, aceleración AI DP4a incluida y hasta 120 GB/s de ancho de banda de memoria del sistema. Estamos entusiasmados de invertir en optimizaciones continuas de rendimiento y eficiencia energética en Llama 3, especialmente a medida que pasamos a nuestros procesadores de próxima generación.

Con soporte el día del lanzamiento para los procesadores Core Ultra y los productos gráficos Arc, la colaboración entre Intel y Meta proporciona tanto un vehículo de desarrollo local como una implementación en millones de dispositivos. El hardware del cliente Intel se acelera a través de herramientas y marcos de software integrales, incluidos PyTorch e Intel Extension para PyTorch utilizados para investigación y desarrollo local, y OpenVINO Toolkit para implementación e inferencia de modelos.

Que sigue: En los próximos meses, Meta espera introducir nuevas capacidades, tamaños de modelos adicionales y un rendimiento mejorado. Intel continuará optimizando el rendimiento de sus productos de IA para respaldar este nuevo LLM.