NVIDIA ha criticado bastante a toda la industria de las CPU en Computex 2023. Jensen subió al escenario en el primer show en vivo después de 4 años y declaró con audacia (y con bastante acierto) que la IA generativa y la computación acelerada son el futuro de la computación. Al leer un elogio a la sabiduría convencional de la Ley de Moore, declaró que el tiempo en el que podía obtener una velocidad 10x en 5 años manteniendo la misma potencia y el mismo costo se acabó. En el futuro, la mayoría de las aceleraciones provendrán de la IA generativa y los enfoques basados en computación acelerada. También compartió un TCO absolutamente encantador con la audiencia:

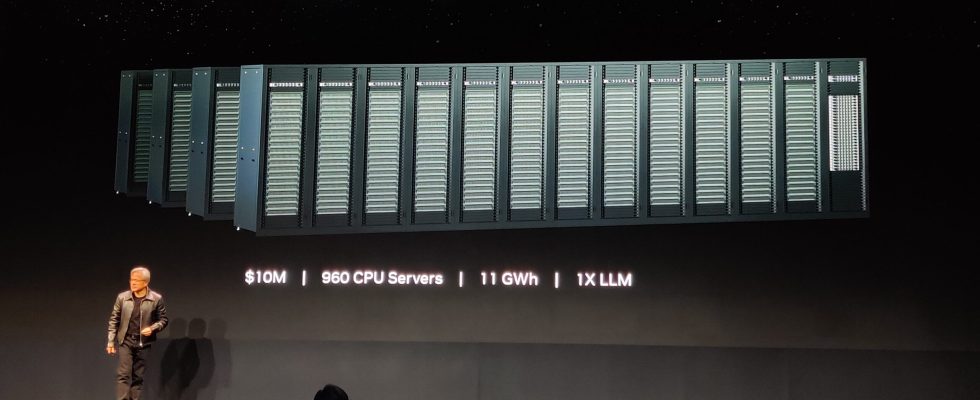

NVIDIA presenta un análisis de TCO de modelo de lenguaje grande (LLM) en Comptuex:

Comencemos con la línea de base primero. Se necesitan servidores de 10 millones de dólares basados en CPU 960 para entrenar 1 LLM (modelo de lenguaje grande). Para ser claros, NVIDIA calculó el costo total del clúster de servidores necesario para entrenar un solo modelo de lenguaje grande (incluidas las redes, la carcasa, las interconexiones, todo) y descubrió que se necesitaron aproximadamente $ 10 millones de dólares y un consumo de energía de 11 GWh para entrenar un único modelo de lenguaje grande.

Por otro lado, si mantiene el mismo costo y compra un clúster de GPU de $ 10 millones, puede entrenar 44 modelos de lenguaje grandes por el mismo costo y una fracción del costo de energía (3.2 GWh). Este escenario se denomina costo ISO en un análisis de TCO (manteniendo el mismo costo irrecuperable).

Si cambia a la potencia ISO o mantiene el mismo consumo de energía, puede lograr una aceleración de 150x al entrenar 150 LLM con el mismo consumo de energía de 11 GWh a un costo de $ 34 millones de dólares. La huella de este clúster aún sería significativamente menor que la del clúster de CPU.

Finalmente, si quisiera mantener la carga de trabajo exactamente igual, solo necesitaría un servidor GPU de $ 400,000 USD que consume 0.13 GWh para entrenar un solo LLM. Esencialmente, lo que dice NVIDIA es que puede entrenar un LLM con solo el 4 % del costo y solo el 1,2 % del consumo de energía, lo que representa una reducción enorme en comparación con los servidores basados en CPU.