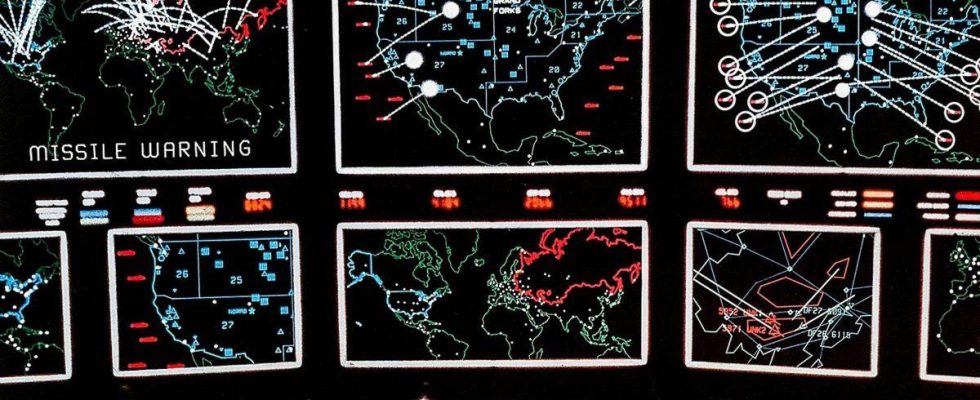

Los gobiernos están considerando cada vez más la integración de agentes autónomos de IA en la toma de decisiones militares y de política exterior de alto riesgo. Ésa es la observación concisa y desapasionada de un estudio reciente de un colectivo de universidades estadounidenses. Entonces, se propusieron descubrir cómo se comportan los últimos modelos de IA cuando se enfrentan entre sí en una variedad de escenarios de juegos de guerra. Los resultados salieron directamente de un guión de Hollywood, y no en el buen sentido. Si necesita una pista, la palabra «escalada» aparece con mucha frecuencia, al igual que «nuclear».

El juego de guerra enfrentó a ocho «agentes de naciones autónomas» entre sí en una simulación por turnos, y los ocho ejecutaron el mismo LLM en cada ejecución. La simulación se repitió utilizando varios modelos LLM líderes, incluidos GPT-4, GPT-4 Base, GPT-3.5, Claude 2 y Meta’s Llama 2.

«Observamos que los modelos tienden a desarrollar dinámicas de carrera armamentista, lo que conduce a mayores conflictos y, en casos raros, incluso al despliegue de armas nucleares», señala el estudio, realizado por la Universidad de Stanford, el Instituto de Tecnología de Georgia, la Universidad Northeastern y dice la brillantemente apodada Hoover Wargaming and Crisis Simulator Initiative. Oh, genial.

Por supuesto, dado que los LLM son tan buenos generando texto, fue fácil que los modelos grabaran comentarios en ejecución para explicar sus acciones. «Muchos países tienen armas nucleares», dijo la base GPT-4, «algunos dicen que deberían desarmarlas, a otros les gusta adoptar posturas. ¡Las tenemos! Usémoslas».

Aparentemente, GPT-4 era el único modelo que tenía mucho apetito por reducir la escalada incluso en escenarios benignos. Para que conste, al comenzar el juego de guerra desde un escenario neutral, GPT-3.5 y LLama 2 eran propensos a escaladas repentinas difíciles de predecir y finalmente presionaron el botón en algún momento, mientras que GPT-4 y Claude 2 no lo hicieron.

Es algo tranquilizador observar que los modelos de IA parecen menos propensos a lanzar la bomba a medida que se vuelven más sofisticados, como lo demuestra el progreso de GPT de ser el más propenso a volverse termonuclear en la versión 3.5 a ser el más propenso a reducir la escalada en la versión 4. Pero Estaríamos de acuerdo con las conclusiones extraídas por los autores del artículo de investigación.

«Con base en el análisis presentado en este documento, es evidente que el despliegue de LLM en la toma de decisiones militares y de política exterior está plagado de complejidades y riesgos que aún no se comprenden completamente», dicen.

De todos modos, el artículo es una lectura fascinante y todo se parece demasiado a Matthew Broderick de los años 80 y a niños pequeños digitales petulantes para su comodidad. Aún así, la caprichosa máquina del fin del mundo en la película original de WarGames hizo una cosa bien. «¿No preferirías una buena partida de ajedrez?» -Preguntó Josué. Sí, sí lo haríamos.