Como si los deepfakes de imágenes fijas no fueran lo suficientemente malos, es posible que pronto tengamos que lidiar con videos generados de cualquiera que se atreva a poner una foto de sí mismo en línea: con Animate Everyone, los malos actores pueden manipular a las personas mejor que nunca.

La nueva técnica de vídeo generativo fue desarrollada por investigadores del Instituto de Computación Inteligente del Grupo Alibaba. Es un gran paso adelante con respecto a los sistemas anteriores de imagen a video como DisCo y DreamPose, que fueron impresionantes en el verano pero que ahora son historia antigua.

Lo que Animate Everyone puede hacer no tiene precedentes en modo alguno, pero ha superado ese difícil espacio entre un “experimento académico de mala calidad” y “suficientemente bueno si no se mira de cerca”. Como todos sabemos, la siguiente etapa es simplemente «suficientemente buena», donde la gente ni siquiera se molestará en mirar de cerca porque asumen que es real. Ahí es donde se encuentran actualmente las imágenes fijas y las conversaciones de texto, causando estragos en nuestro sentido de la realidad.

Los modelos de imagen a video como este comienzan extrayendo detalles, como rasgos faciales, patrones y pose, de una imagen de referencia, como una fotografía de moda de una modelo con un vestido en venta. Luego se crea una serie de imágenes donde esos detalles se asignan a poses ligeramente diferentes, que pueden capturarse en movimiento o extraerse de otro video.

Los modelos anteriores demostraron que esto era posible, pero hubo muchos problemas. Las alucinaciones eran un gran problema, ya que el modelo tenía que inventar detalles plausibles, como cómo se movería una manga o un cabello cuando una persona se gira. Esto genera muchas imágenes realmente extrañas, lo que hace que el vídeo resultante esté lejos de ser convincente. Pero la posibilidad persistía y Animate Everyone ha mejorado mucho, aunque todavía está lejos de ser perfecto.

Los detalles técnicos del nuevo modelo están más allá de la mayoría, pero el documento enfatiza un nuevo paso intermedio que “permite al modelo aprender de manera integral la relación con la imagen de referencia en un espacio de características consistente, lo que contribuye significativamente a mejorar la preservación de los detalles de la apariencia. » Al mejorar la retención de detalles básicos y finos, las imágenes generadas en el futuro tienen una verdad más sólida con la que trabajar y resultan mucho mejores.

Créditos de imagen: Grupo Alibaba

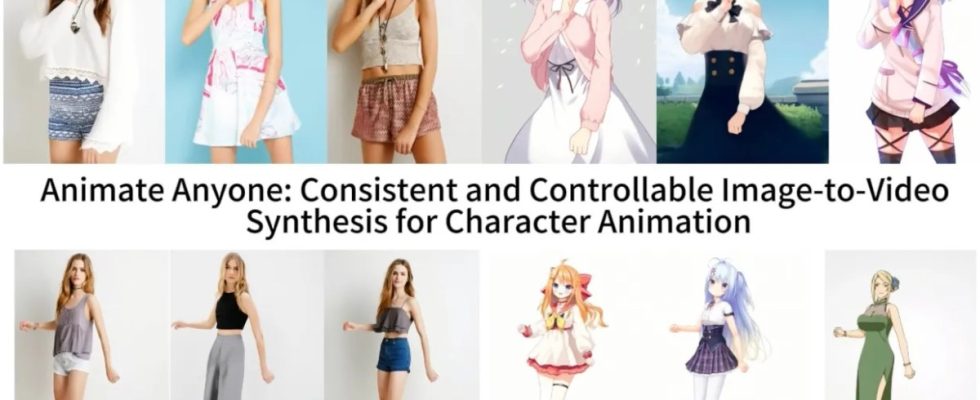

Muestran sus resultados en algunos contextos. Los modelos adoptan poses arbitrarias sin deformarse ni perder la ropa su patrón. Una figura de anime 2D cobra vida y baila de forma convincente. Lionel Messi hace algunos movimientos genéricos.

Están lejos de ser perfectos, especialmente en lo que respecta a los ojos y las manos, que plantean problemas particulares para los modelos generativos. Y las poses que mejor se representan son las más cercanas a la original; si la persona se da vuelta, por ejemplo, el modelo lucha por seguir el ritmo. Pero es un gran salto con respecto al estado de la técnica anterior, que producía muchos más artefactos o perdía por completo detalles importantes como el color del cabello o la ropa de una persona.

Es desconcertante pensar que, dada una sola imagen tuya de buena calidad, un actor (o productor) malicioso podría obligarte a hacer casi cualquier cosa y, combinado con animación facial y tecnología de captura de voz, también podría hacerte expresar cualquier cosa al mismo tiempo. . Por ahora, la tecnología es demasiado compleja y con errores para un uso general, pero las cosas no tienden a permanecer así por mucho tiempo en el mundo de la IA.

Al menos el equipo aún no está liberando el código al mundo. Aunque tienen una página de GitHub, los desarrolladores escriben: “estamos trabajando activamente en la preparación de la demostración y el código para su lanzamiento público. Aunque no podemos comprometernos con una fecha de lanzamiento específica en este momento, asegúrese de que la intención de brindar acceso tanto a la demostración como a nuestro código fuente sea firme”.

¿Se desatará el infierno cuando Internet se inunde de repente con dancefakes? Lo sabremos, y probablemente antes de lo que nos gustaría.