La próxima era de potentes chatbots de IA puede muy bien remodelar el mundo de maneras radicales e imprevistas, pero podría hacerlo a un costo ambiental inmenso. un nuevo informe lanzado hoy por el Stanford Institute for Human-Centered Artificial Intelligence estima la cantidad de energía necesaria para entrenar modelos de IA como OpenAI GPT-3que impulsa el mundialmente famoso ChatGPT, podría alimentar el hogar de un estadounidense promedio durante cientos de años. De los tres modelos de IA revisados en la investigación, el sistema de OpenAI fue, con mucho, el que más energía-hambriento.

La investigación, destacada en el Índice de Inteligencia Artificial publicado recientemente por Stanford, se basa en investigaciones recientes que miden los costos del carbono. asociado con la formación de cuatro modelos: Gopher de DeepMindiniciativas de BigScience’ FLORACIÓN, OPT de Metay GPT de OpenAI-3. Según se informa, el modelo de OpenAI lanzó 502 toneladas métricas de carbono durante su formación. Para poner eso en perspectiva, eso es 1,4 veces más carbono que Gopher y 20,1 veces más que BLOOM. GPT-3 también requirió el mayor consumo de energía del lote con 1287 MWh.

Numerosos factores entraron en la determinación del consumo de energía de cada modelo, incluida la cantidad de puntos de datos, o parámetros, en los que fueron entrenados y la eficiencia energética de los centros de datos donde están alojados. A pesar de las marcadas diferencias en el consumo de energía, tres de los cuatro modelos (excluyendo Gopher de DeepMind) fueron entrenados en aproximadamente 175 mil millones de parámetros equivalentes. OpenAI no dirá cuántos parámetros se lanzaron recientemente GTP-4 está entrenado, pero dados los grandes saltos en los datos requeridos entre versiones anteriores del modelo, es seguro asumir GTP-4 requiere incluso más datos que sus predecesores. Un entusiasta de la IA estimó GPT-4 podría ser entrenado en 100 billones de parámetros, aunque el CEO de OpenAI, Sam Altman, ha desde que se llama esa figura«completa mierda».

G/O Media puede recibir una comisión

$32 de descuento

El conjunto completo del complejo revitalizante del cabello

Combate la caída del cabello con ciencia

En este momento, puede obtener el conjunto completo de The Hair Revitalizing Complex por el precio de la recarga. Eso es solo $ 98 por un suministro de 30 días y $ 32 de descuento sobre el precio normal del suplemento. Se ha comprobado que este suplemento brinda resultados. Augustinus Bader realizó un ensayo doble ciego de seis meses que encontró que aquellos que tomaron el suplemento habían aumentado la cantidad de cabello en un 56 %, el brillo del cabello en un 100 % y vieron una reducción del 98 % en el daño del cabello en comparación con los que tomaron un placebo.

«Si solo estamos escalando sin tener en cuenta los impactos ambientales, podemos llegar a una situación en la que estamos haciendo más daño que bien con los modelos de aprendizaje automático», dijo Peter Henderson, investigador de Stanford. dijo el año pasado. “Realmente queremos mitigar eso tanto como sea posible y traer un bien social neto”.

Los modelos de IA son, sin duda, hambrientos de datos, pero el informe de Stanford señala que puede ser demasiado pronto para decir si eso significa necesariamente que presagian un desastre ambiental. Los potentes modelos de IA del futuro podrían utilizarse para optimizar el consumo de energía en los centros de datos y otros entornos. En un experimento de tres meses, por ejemplo, el agente BCOOLER de DeepMind pudo lograr un ahorro de energía de alrededor del 12,7 % en un centro de datos de Google mientras mantenía el edificio lo suficientemente fresco para que las personas trabajaran cómodamente.

Los costos ambientales de la IA reflejan el dilema del clima criptográfico

Si todo esto suena familiar, es porque básicamente vimos esta misma dinámica ambiental hace varios años con la última gran obsesión de la tecnología: Crypto y web3. En ese caso, Bitcoin emergió como la industria punto sensible ambiental obvio debido a las grandes cantidades de energía necesarias para extraer monedas en su modelo de prueba de trabajo. Algunas estimaciones sugerir La biotocina por sí sola requiere más energía cada año que el consumo anual de electricidad de Noruega.

Sin embargo, años de críticas por parte de los activistas ambientales llevaron a la criptoindustria a realizar algunos cambios. Ethereum, la segunda moneda más grande en la cadena de bloques, cambiado oficialmente el año pasado a un modelo de prueba de participación que, según los partidarios, podría reducir su consumo de energía en más del 99%. Otras monedas más pequeñas fueron igualmente diseñado con la eficiencia energética en mente. En el gran esquema de las cosas, los grandes modelos de lenguaje aún están en su infancia y no está nada claro cómo se desarrollará su boleta de calificaciones ambientales.

Los modelos de lenguaje grande se están volviendo absurdamente caros

Los requisitos de energía no son las únicas cifras que aumentan con los nuevos LLM. También lo son sus etiquetas de precio. Cuando OpenAI lanzó GPT 2 en 2019, el informe de Stanford señala que le costó a la empresa solo $ 50,000 entrenar su modelo basado en 1,5 mil millones de parámetros. Solo tres años después, Google reveló su propio y poderoso modelo PaLM entrenado en 540 mil millones de parámetros. Ese modelo cuesta $ 8 millones para entrenar. PaLM, según el informe, era unas 360 veces más grande que GPT-2 y costaba 160 veces más. Nuevamente, estos modelos, ya sea lanzados por OpenAI o Google, solo se están haciendo más grandes.

“En general, los modelos multimodales y de idiomas grandes son cada vez más grandes y más caros”, señala el informe.

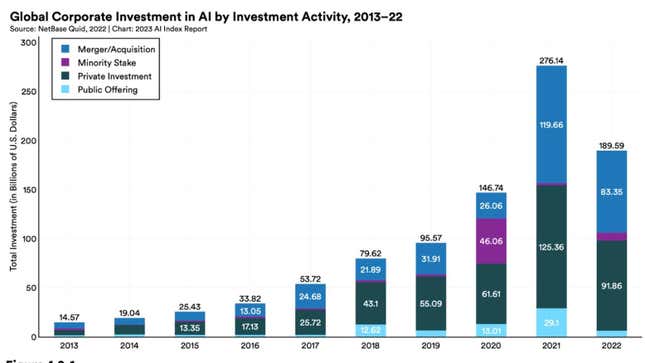

Todo ese dinero podría tener efectos de arrastre en la economía en general. Stanford estima que la cantidad de inversión privada en IA a nivel mundial en 2022 fue 18 veces mayor que en 2013. Las ofertas de trabajo relacionadas con IA en todos los sectores, por fin en los EE. UU., también están creciendo y aumentaron del 1,7 % al 1,9 % en 2022. A escala global, EE. UU. sigue siendo inigualable en términos de inversión general en IA y, según se informa, invirtió $ 47.4 mil millones en tecnología de IA en 2022. Eso es 3.5 veces más que China, el siguiente mayor gastador. Cuando se trata de quemar dinero, Estados Unidos no tiene rival.

Los legisladores intentan ponerse al día

La reciente ola de poderosos chatbots y las cuestiones éticas y legales que los rodean afectaron a casi todos, excepto a los ingenieros de IA, incluidos los legisladores. De manera lenta pero segura, los legisladores están tratando de ponerse al día con la legislación. En 2021, según el informe de Stanford, solo el 2% de todos los proyectos de ley federales relacionados con la IA se convirtieron en ley. Esa cifra subió hasta un 10% el año pasado. Muchos de esos proyectos de ley se escribieron de manera similar antes de la histeria actual en torno a GPT4 y las descripciones prematuras de algunos investigadores como «inteligencia general artificial.”

legisladores también están más interesados que nunca en la IA. En 2022, Stanford identificó 110 casos legales relacionados con IA presentados en tribunales federales y estatales de EE. UU. Eso puede no parecer mucho, pero aún son 6.5 veces más casos que los que se detectaron en 2016. La mayoría de esos casos tuvieron lugar en California, Illinois y Nueva York. Alrededor del 29% de esos casos de AI involucraron derecho civil, mientras que el 19% se refirieron a derechos de propiedad intelectual. si es reciente quejas presentados por escritores y artistas sobre el uso de su estilo por parte de los generadores de IA son una guía, es posible que la porción de casos de derechos de propiedad aumente.

¿Quiere saber más sobre la IA, los chatbots y el futuro del aprendizaje automático? Consulte nuestra cobertura completa de inteligencia artificialo explore nuestras guías para Los mejores generadores de arte de IA gratuitos y Todo lo que sabemos sobre ChatGPT de OpenAI.