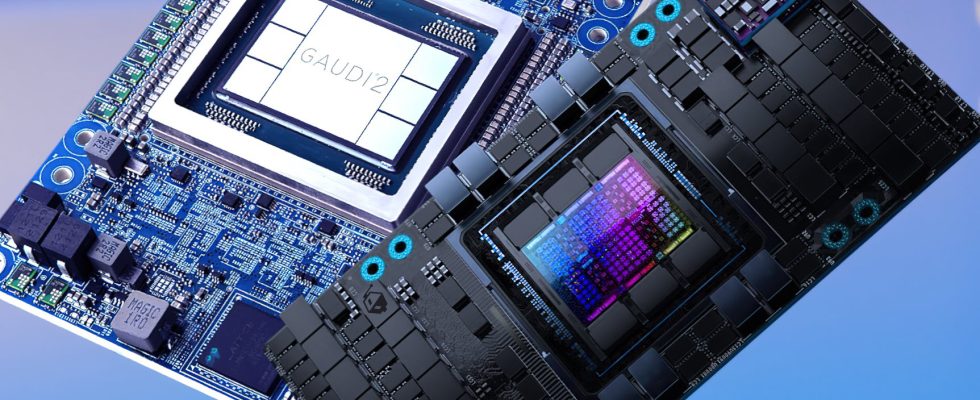

Stability AI ha publicado una nueva publicación de blog que ofrece un enfrentamiento comparativo de IA entre los aceleradores GPU Intel Gaudi 2 y NVIDIA H100 y A100. Los puntos de referencia muestran que las soluciones de Intel ofrecen un gran valor y pueden verse como una alternativa respetada para los clientes que buscan una solución rápida y fácilmente disponible en comparación con las ofertas de NVIDIA.

Enfrentamiento entre Intel y NVIDIA AI Accelerator: Gaudi 2 muestra un sólido rendimiento frente a H100 y A100 en Stable Diffusion y Llama 2 LLM, excelente rendimiento/$ destacado como una fuerte razón para optar por el equipo azul

La empresa de inteligencia artificial Stability AI ha estado creando modelos abiertos que pueden manejar una amplia gama de tareas de manera eficiente. Para probar esto, Stability AI utilizó dos de sus modelos que incluyen Stable Diffusion 3, e hizo una evaluación comparativa entre los aceleradores de IA más populares de NVIDIA e Intel para ver cómo se desempeñan entre sí.

En Stability Diffusion 3, el siguiente capítulo del muy popular modelo de texto a imagen, el acelerador de IA Gaudi 2 de Intel arrojó algunos resultados excepcionales. El modelo oscila entre los parámetros 800M y 8B y se probó utilizando la versión de parámetros 2B. A modo de comparación, se utilizaron 2 nodos con un total de 16 aceleradores Intel y NVIDIA con un tamaño de lote establecido en 16 por acelerador y un tamaño de lote de hasta 512. El resultado final fue que Intel Gaudi 2 ofrece una aceleración del 56 % en comparación con el H100. GPU de 80 GB y una aceleración de 2,43 veces en comparación con la GPU A100 de 80 GB.

La capacidad de 96 GB HBM también permitió que el Gaudi 2 de Intel encajara en un tamaño de lote de 32 por acelerador para un tamaño de lote total de 512. Esto permitió una velocidad adicional de 1254 imágenes por segundo, una aceleración del 35% con respecto a los 16 lotes. Acelerador Gaudi 2, 2,10 veces más que el H100 de 80 GB y 3,26 veces más que el A100 de 80 GB con GPU AI.

Al ampliar aún más hasta 32 nodos (256 aceleradores) para las GPU Gaudi 2 y A100 de 80 GB, se observa un aumento de 3,16 veces en la solución Intel, que puede generar 49,4 imágenes/segundo/dispositivo frente a solo 15,6 en la solución A100.

Si bien el rendimiento del entrenamiento es excelente con los aceleradores de IA Gaudi 2, parece que NVIDIA aún conserva el trono en inferencia gracias a sus optimizaciones Tensor-RT que han logrado grandes avances durante el año anterior y el equipo ecológico está continuamente dando grandes pasos en este ecosistema. Se dice que las GPU A100 producen imágenes hasta un 40% más rápido en estas cargas de trabajo particulares bajo el mismo modelo Stable Diffusion 3 8B en comparación con los aceleradores Gaudi 2.

En las pruebas de inferencia con el modelo de parámetros Stable Diffusion 3 8B, los chips Gaudi 2 ofrecen una velocidad de inferencia similar a la de los chips Nvidia A100 que utilizan PyTorch base. Sin embargo, con la optimización de TensorRT, los chips A100 producen imágenes un 40% más rápido que Gaudi 2. Anticipamos que con una mayor optimización, Gaudi 2 pronto superará a los A100 en este modelo. En pruebas anteriores en nuestro modelo SDXL con PyTorch base, Gaudi 2 genera una imagen de 1024×1024 en 30 pasos en 3,2 segundos, frente a 3,6 segundos para PyTorch en A100 y 2,7 segundos para una generación con TensorRT en un A100.

La mayor memoria y la rápida interconexión de Gaudi 2, además de otras consideraciones de diseño, lo hacen competitivo para ejecutar la arquitectura Diffusion Transformer que sustenta esta próxima generación de modelos de medios.

a través de la estabilidad AI

Por último, tenemos resultados en el segundo modelo, que es Stable Beluga 2.5 70B, una versión mejorada del LLaMA 2 70B. Sin optimizaciones adicionales y funcionando bajo PyTorch, los 256 aceleradores de IA Intel Gaudi 2 lograron un rendimiento promedio de 116,777 tokens/segundo. Era aproximadamente un 28% más rápido que la solución A100 de 80 GB que se ejecuta con TensorRT.

Todo esto demuestra cuán competitivo se está volviendo el panorama de la IA y no es el hardware lo que más importa, sino el software y las optimizaciones para cada acelerador específico. Si bien el hardware es esencial, puedes tener lo último y lo mejor, pero si no hay una base sólida para impulsar todos esos núcleos, memoria y varios aceleradores específicos de IA, entonces tendrás dificultades en este espacio.

NVIDIA lo sabe desde hace mucho tiempo, por lo que Intel y AMD acaban de comenzar a solidificar sus paquetes de software para IA y aún está por verse si alcanzarán al gigante verde o podrán abordar la arquitectura CUDA/Tensor con lanzamientos rápidos de software. ser visto. Estos puntos de referencia muestran que Intel se está convirtiendo en una solución muy viable, no solo como una alternativa sino también como una solución competitiva frente a las ofertas de NVIDIA, y con las futuras ofertas de GPU de IA y Gaudí, podemos esperar un segmento de IA más sólido con excelentes soluciones para que los clientes seleccionen. en lugar de depender de una sola empresa.