La startup de computación fotónica Lightmatter está tomando su gran oportunidad en el mercado de computación de IA en rápido crecimiento con una combinación de hardware y software que, según afirma, ayudará a la industria a subir de nivel y ahorrar mucha electricidad para arrancar.

Los chips de Lightmatter básicamente usan flujo óptico para resolver procesos computacionales como productos de matriz vectorial. Esta matemática está en el corazón de una gran cantidad de trabajo de IA y actualmente la realizan GPU y TPU que se especializan en ella pero usan transistores y puertas de silicio tradicionales.

El problema con ellos es que nos estamos acercando a los límites de densidad y, por lo tanto, de velocidad para un vataje o tamaño determinado. Todavía se están logrando avances, pero a un gran costo y empujando los límites de la física clásica. Las supercomputadoras que hacen posibles los modelos de entrenamiento como GPT-4 son enormes, consumen enormes cantidades de energía y producen una gran cantidad de calor residual.

“Las empresas más grandes del mundo se están enfrentando a un muro de poder energético y experimentan desafíos masivos con la escalabilidad de la IA. Los chips tradicionales superan los límites de lo que es posible enfriar y los centros de datos producen huellas de energía cada vez más grandes. Los avances de la IA se ralentizarán significativamente a menos que implementemos una nueva solución en los centros de datos”, dijo el CEO y fundador de Lightmatter, Nick Harris.

“Algunos han proyectado que entrenar un solo modelo de lenguaje grande puede consumir más energía de la que consumen 100 hogares estadounidenses en un año. Además, hay estimaciones de que entre el 10 % y el 20 % de la potencia total del mundo se destinará a la inferencia de IA para finales de la década, a menos que se creen nuevos paradigmas informáticos”.

Lightmatter, por supuesto, pretende ser uno de esos nuevos paradigmas. Su enfoque es, al menos potencialmente, más rápido y más eficiente, utilizando matrices de guías de ondas ópticas microscópicas para permitir que la luz realice operaciones lógicas simplemente al pasar a través de ellas: una especie de híbrido analógico-digital. Dado que las guías de ondas son pasivas, el principal consumo de energía es crear la luz en sí, luego leer y manejar la salida.

Un aspecto realmente interesante de esta forma de computación óptica es que puede aumentar la potencia del chip simplemente usando más de un color a la vez. El azul hace una operación mientras que el rojo hace otra, aunque en la práctica es más como una longitud de onda de 800 nanómetros hace una, y 820 hace otra. No es trivial hacerlo, por supuesto, pero estos «chips virtuales» pueden aumentar enormemente la cantidad de cómputo realizado en la matriz. El doble de colores, el doble de potencia.

Harris fundó la empresa basándose en el trabajo de computación óptica que él y su equipo hicieron en el MIT (que les está otorgando licencias de las patentes relevantes) y logró disputar una ronda inicial de $ 11 millones en 2018. Un inversor dijo entonces que «esto no es un proyecto científico”, pero Harris admitió en 2021 que, si bien sabían “en principio” que la tecnología debería funcionar, había mucho que hacer para que fuera operativa. Afortunadamente, me dijo eso en el contexto de los inversores que arrojaron otros $ 80 millones en la empresa.

Ahora Lightmatter ha recaudado una ronda C de $154 millones y se está preparando para su debut real. Tiene varios pilotos con su pila completa de Envise (hardware informático), Passage (interconexión, crucial para grandes operaciones informáticas) e Idiom, una plataforma de software que, según Harris, debería permitir que los desarrolladores de aprendizaje automático se adapten rápidamente.

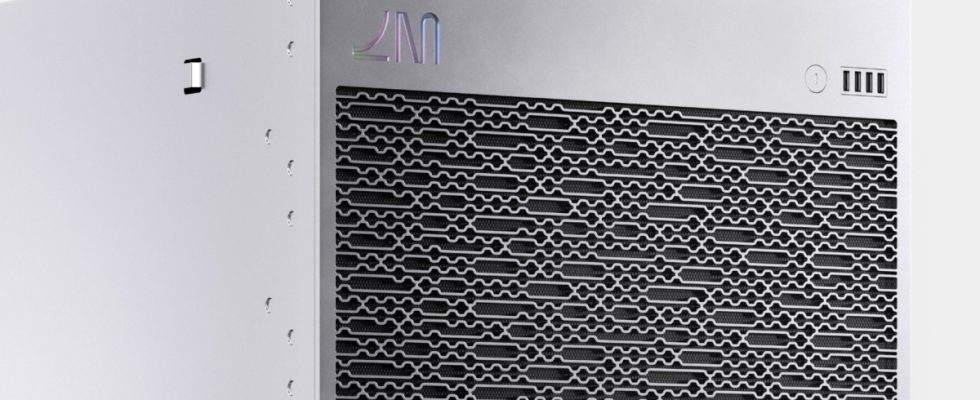

Una unidad Lightmatter Envise en cautiverio. Créditos de imagen: materia ligera

“Hemos creado una pila de software que se integra a la perfección con PyTorch y TensorFlow. El flujo de trabajo para los desarrolladores de aprendizaje automático es el mismo a partir de ahí: tomamos las redes neuronales integradas en estas aplicaciones estándar de la industria e importamos nuestras bibliotecas, por lo que todo el código se ejecuta en Envise”, explicó.

La compañía se negó a hacer afirmaciones específicas sobre aceleraciones o mejoras en la eficiencia, y debido a que es una arquitectura y un método informático diferentes, es difícil hacer comparaciones de manzanas con manzanas. Pero definitivamente estamos hablando de un orden de magnitud, no de un mísero 10% o 15%. Interconnect se actualiza de manera similar, ya que es inútil tener ese nivel de procesamiento aislado en una placa.

Por supuesto, este no es el tipo de chip de propósito general que podría usar en su computadora portátil; es muy específico para esta tarea. Pero es la falta de especificidad de la tarea a esta escala lo que parece estar frenando el desarrollo de la IA, aunque «frenar» es un término incorrecto, ya que se está moviendo a gran velocidad. Pero ese desarrollo es enormemente costoso y difícil de manejar.

Los pilotos están en versión beta y la producción en masa está prevista para 2024, momento en el que presumiblemente deberían tener suficiente retroalimentación y madurez para implementar en los centros de datos.

La financiación de esta ronda provino de SIP Global, Fidelity Management & Research Company, Viking Global Investors, GV, HPE Pathfinder e inversores existentes.