Getty Images/Benj Edwards

Recientemente, varios videos musicales virales de un canal de YouTube llamado There I Ruined It han incluido voces generadas por IA de artistas musicales famosos que cantan letras de canciones sorprendentes. Un ejemplo reciente imagina a Elvis cantando la letra de Sir Mix-a-Lot’s. El bebé volvió. Otro presenta a un falso Johnny Cash cantando la letra de Aqua’s niña Barbie.

(Desde entonces, el video original de Elvis se eliminó de YouTube debido a un reclamo de derechos de autor de Universal Music Group, pero gracias a la magia de Internet, puedes escucharlo de todos modos).

https://www.youtube.com/watch?v=IXcITn507Jk

Una copia del extracto del video «Elvis Sings Baby Got Back».

Obviamente, dado que Elvis lleva muerto 46 años (y Cash 20), ninguno de los dos podría haber cantado las canciones. Ahí es donde entra en juego la IA. Pero, como veremos, aunque la IA generativa puede ser increíble, todavía hay mucho talento humano y esfuerzo involucrados en la elaboración de estas mezclas musicales.

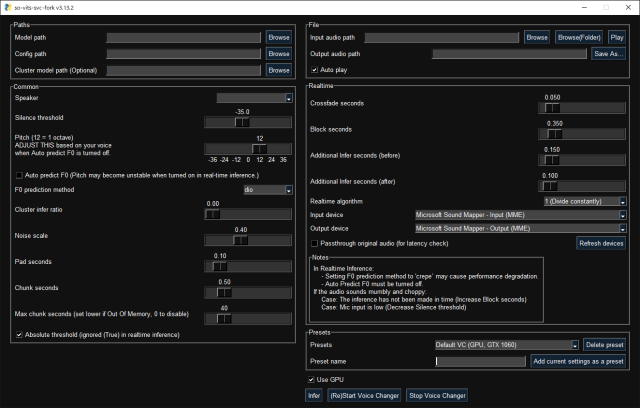

para averiguar cómo Ahí lo arruiné hace su magia, primero contactamos al creador del canal, el músico Dustin Ballard. La respuesta de Ballard fue escasa en detalles, pero expuso el flujo de trabajo básico. Utiliza un modelo de IA llamado so-vits-svc para transformar sus propias voces que graba en las de otros artistas. «Actualmente no es un proceso muy fácil de usar (y el entrenamiento en sí mismo es aún más difícil)», dijo a Ars Technica en un correo electrónico, «pero básicamente una vez que tienes el modelo entrenado (basado en una gran muestra de referencias de audio limpias) , luego puedes cargar tu propia pista de voz, y la reemplaza con la voz que has modelado. Luego, la pones en tu mezcla y construyes la canción a su alrededor».

Pero retrocedamos un segundo: ¿Qué significa «so-vits-svc»? El nombre se origina a partir de una serie de tecnologías de código abierto que se encadenan. La parte «so» proviene de «SoftVC» (VC para «conversión de voz»), que divide el audio de origen (la voz de un cantante) en partes clave que una red neuronal puede codificar y aprender. La parte «VITS» es un acrónimo de «Inferencia variable con aprendizaje antagónico para texto a voz de extremo a extremo», acuñado en este documento de 2021. VITS toma conocimiento del modelo vocal entrenado y genera la salida de voz convertida. Y «SVC» significa «conversión de voz de canto», convertir una voz de canto en otra, en lugar de convertir la voz de alguien.

El reciente Ahí lo arruiné Las canciones utilizan principalmente IA en un aspecto: el modelo de IA se basa en la interpretación vocal de Ballard, pero cambia el timbre de su voz al de otra persona, de forma similar a cómo la tecnología de voz a voz de Respeecher puede transformar la interpretación de Darth Vader de un actor en La voz de James Earl Jones. El resto de la canción proviene del arreglo de Ballard en una aplicación de música convencional.

Un proceso complicado—por el momento

Michael van Voorst

Para obtener más información sobre el proceso de clonación de voz musical con so-vits-svc-fork (una versión alterada del so-vits-svc original), localizamos a Michael van Voorst, el creador del modelo de IA de voz de Elvis que Ballard usado en su El bebé volvió video. Nos guió a través de los pasos necesarios para crear una combinación de IA.

«Para crear una réplica precisa de una voz, se comienza con la creación de un conjunto de datos de muestras de audio vocal limpias de la persona de la que se está creando un modelo de voz», dijo van Voorst. «Las muestras de audio deben tener calidad de estudio para obtener los mejores resultados. Si son de menor calidad, se reflejarán en el modelo vocal».

En el caso de Elvis, van Voorst usó pistas vocales de las famosas canciones del cantante. Aloha de Hawai concierto en 1973 como material fundacional para entrenar el modelo de voz. Después de una cuidadosa selección manual, van Voorst extrajo 36 minutos de audio de alta calidad, que luego dividió en fragmentos de 10 segundos para un procesamiento correcto. «Escuché atentamente cualquier interferencia, como el ruido de la banda o de la audiencia, y lo eliminé de mi conjunto de datos», dijo. Asimismo, trató de captar una amplia variedad de expresiones vocales: “La calidad del modelo mejora con más y más variados samples”.