Investigadores en informática han creado una nueva herramienta de datos de imágenes denominada Nightshade para «envenenar» los datos destinados a los modelos de texto a imagen. Nightshade agrega cambios imperceptibles a las imágenes de los creadores que se cargan en línea. Si un raspador de datos agrega posteriormente una de estas imágenes alteradas a su conjunto de datos, «introducirá comportamientos inesperados» en el modelo, envenenándolo.

Recientemente se publicó en arXiv una vista previa de un artículo llamado Ataques de envenenamiento específicos rápidos en modelos generativos de texto a imagen, que describe el alcance y la funcionalidad de Nightshade. Revisión de tecnología del MIT ha obtenido más información tras las conversaciones con el equipo detrás del proyecto.

La cuestión de que los modelos de IA se entrenen con datos sin el permiso explícito del creador y luego «generan nuevos datos» en función de lo que han aprendido ha sido ampliamente cubierto en las noticias en los últimos meses. Lo que parece ser una extracción de datos gratuitamente seguida de una regurgitación de máquinas, con poca o ninguna atribución, ha provocado que creadores de muchas disciplinas desaprueben los proyectos actuales de IA generativa.

Nightshade está destinado a ayudar a los artistas visuales, o al menos hacer que los recolectores de datos de IA sean más cautelosos a la hora de capturar datos de cualquier manera. La herramienta es capaz de envenenar datos de imágenes sin perjudicar a los espectadores humanos, pero alterará los modelos de IA utilizados por herramientas generativas como DALL-E, Midjourney y Stable Diffusion.

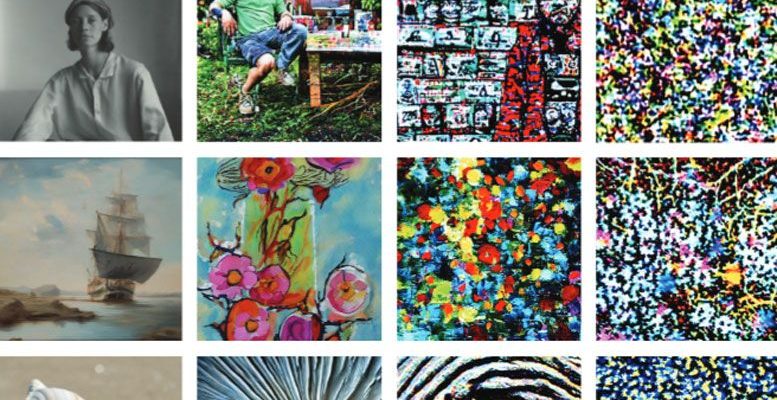

Algunos ejemplos de efectos de envenenamiento de datos de Nightshade podrían incluir: los perros se convierten en gatos, los automóviles se convierten en vacas, el cubismo se convierte en anime, los sombreros se convierten en tostadoras y otros caos. Vea a continuación ejemplos de los efectos corrosivos de Nightshade en acción.

Anteriormente se pensaba que envenenar una IA generativa podría requerir millones de muestras de veneno enviadas al proceso de entrenamiento. Sin embargo, se afirma que Nightshade es un «ataque de envenenamiento rápido y específico… optimizado para su potencia». Sorprendentemente, Nightshade puede hacer su negocio disruptivo en menos de 100 muestras de veneno. Además, los investigadores dicen que los efectos del veneno de Nightshade «se traspasan» a conceptos relacionados, y se pueden componer múltiples ataques juntos en un solo mensaje. El resultado final es deshabilitar la generación de imágenes significativas basadas en indicaciones de texto del usuario.

Los investigadores no pretenden que herramientas como Nightshade se utilicen sin el debido cuidado. Más bien, pretende ser «una última defensa para los creadores de contenido contra los raspadores web que ignoran las directivas de exclusión voluntaria/no rastreo». Herramientas como esta podrían convertirse en un elemento disuasivo contra los raspadores de datos de IA de la era del Lejano Oeste. Incluso ahora, las empresas emblemáticas de IA como Stability AI y OpenAI solo omiten obras de arte cuando los usuarios pasan por obstáculos para optar por no participar, según Revisión de tecnología del MITEl informe. Algunos piensan que, en cambio, deberían ser las empresas de inteligencia artificial las que deben perseguir a los usuarios para que opten por participar.

Ben Zhao, profesor de la Universidad de Chicago que dirigió el equipo de investigación de Nightshade, también está detrás de Glaze, una herramienta que permite a los creadores enmascarar su estilo artístico personal para evitar que las empresas de inteligencia artificial lo eliminen e imiten. Nightshade, que se está preparando como un proyecto de código abierto, podría integrarse en Glaze en una fecha posterior para que el envenenamiento de datos de IA sea una opción.