SAN JOSÉ – “Espero que se den cuenta de que esto no es un concierto”, dijo el presidente de Nvidia, Jensen Huang, ante una audiencia tan grande que llenó el Centro SAP en San José. Así presentó lo que quizás sea todo lo contrario de un concierto: el evento GTC de la empresa. “Has llegado a una conferencia de desarrolladores. Habrá mucha ciencia que describirá algoritmos, arquitectura de computadoras y matemáticas. Siento un peso muy pesado en la habitación; De repente, estás en el lugar equivocado”.

Puede que no haya sido un concierto de rock, pero el director general de 61 años de la tercera empresa más valiosa del mundo por capitalización de mercado, vestido con una chaqueta de cuero, ciertamente tenía un buen número de fans entre el público. La empresa se fundó en 1993 con la misión de llevar la informática general más allá de sus límites. La “computación acelerada” se convirtió en el lema de Nvidia: ¿no sería fantástico fabricar chips y placas especializados, en lugar de tener un propósito general? Los chips Nvidia brindan a los jugadores ávidos de gráficos las herramientas que necesitan para jugar en mayor resolución, con mayor calidad y velocidades de cuadro más altas.

Quizás no sea una gran sorpresa que el CEO de Nvidia estableciera paralelismos con un concierto. El lugar era, en una palabra, muy parecido a un concierto. Créditos de imagen: TechCrunch / Haje Kamps

La conferencia magistral del lunes fue, en cierto modo, un regreso a la misión original de la empresa. «Quiero mostrarles el alma de Nvidia, el alma de nuestra empresa, en la intersección de los gráficos por computadora, la física y la inteligencia artificial, todo ello entrelazado dentro de una computadora».

Luego, durante las siguientes dos horas, Huang hizo algo raro: se volvió nerd. Duro. Cualquiera que hubiera acudido al discurso de apertura esperando que él hiciera un Tim Cook, con un discurso hábil y centrado en la audiencia, seguramente se sentiría decepcionado. En general, el discurso de apertura estuvo lleno de tecnología, plagado de acrónimos y, sin disculpas, fue una conferencia de desarrolladores.

Necesitamos GPU más grandes

Las unidades de procesamiento de gráficos (GPU) es donde comenzó Nvidia. Si alguna vez ha construido una computadora, probablemente esté pensando en una tarjeta gráfica que va en una ranura PCI. Ahí empezó el viaje, pero desde entonces hemos recorrido un largo camino.

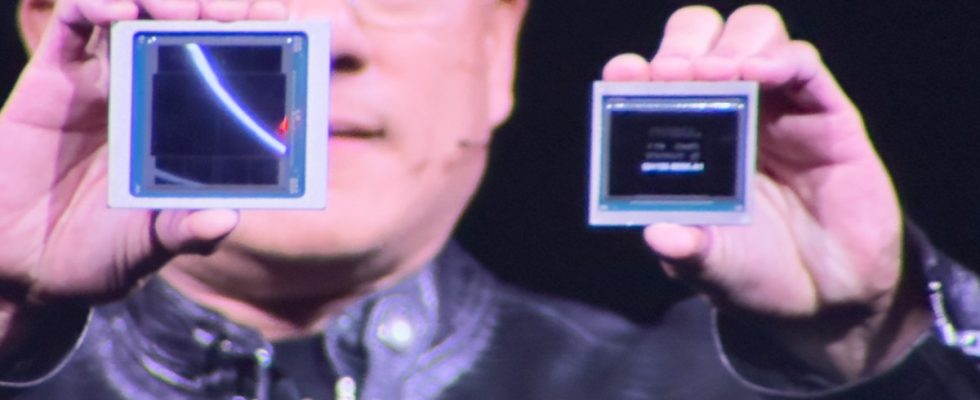

La compañía anunció su nueva plataforma Blackwell, que es un monstruo absoluto. Huang dice que el núcleo del procesador estaba «superando los límites de la física sobre el tamaño que podía tener un chip». Utiliza combina la potencia de dos chips, ofreciendo velocidades de 10 Tbps.

“Aquí tengo equipos por valor de alrededor de 10 mil millones de dólares”, dijo Huang, sosteniendo un prototipo de Blackwell. “El próximo costará 5 mil millones de dólares. Por suerte para todos ustedes, a partir de ahí se vuelve más barato”. Juntar un montón de estos chips puede generar una potencia realmente impresionante.

La generación anterior de GPU optimizada para IA se llamaba Hopper. Blackwell es entre 2 y 30 veces más rápido, dependiendo de cómo se mida. Huang explicó que se necesitaron 8.000 GPU, 15 megavatios y 90 días para crear el modelo GPT-MoE-1.8T. Con el nuevo sistema, podrías usar solo 2000 GPU y utilizar el 25% de la energía.

Estas GPU están generando una cantidad fantástica de datos, lo cual es una muy buena transición hacia otro tema del que habló Huang.

Que sigue

Nvidia lanzó un nuevo conjunto de herramientas para los fabricantes de automóviles que trabajan en vehículos autónomos. La empresa ya era un actor importante en la robótica, pero se duplicó con nuevas herramientas para que los robóticos hicieran sus robots más inteligentes.

La compañía también presentó Nvidia NIM, una plataforma de software destinada a simplificar la implementación de modelos de IA. NIM aprovecha el hardware de Nvidia como base y tiene como objetivo acelerar las iniciativas de IA de las empresas proporcionando un ecosistema de contenedores preparados para IA. Admite modelos de diversas fuentes, incluidas Nvidia, Google y Hugging Face, y se integra con plataformas como Amazon SageMaker y Microsoft Azure AI. NIM ampliará sus capacidades con el tiempo, incluidas herramientas para chatbots de IA generativa.

«Cualquier cosa que se pueda digitalizar: siempre que haya alguna estructura en la que podamos aplicar algunos patrones, significa que podemos aprender los patrones», dijo Huang. “Y si podemos aprender los patrones, podemos entender el significado. Cuando entendemos el significado, también podemos generarlo. Y aquí estamos, en la revolución de la IA generativa”.