Algunas semanas en las noticias sobre IA son inquietantemente tranquilas, pero durante otras, controlar los eventos de la semana parece intentar frenar la marea. Esta semana se han producido tres lanzamientos notables de modelos de lenguaje grande (LLM): Google Gemini Pro 1.5 alcanzó la disponibilidad general con un nivel gratuito, OpenAI envió una nueva versión de GPT-4 Turbo y Mistral lanzó un nuevo LLM con licencia abierta, Mixtral 8x22B. Los tres lanzamientos se produjeron en 24 horas a partir del martes.

Con la ayuda del ingeniero de software e investigador independiente de IA Simon Willison (quien también escribió sobre los agitados lanzamientos de LLM de esta semana en su propio blog), cubriremos brevemente cada uno de los tres eventos principales en orden aproximadamente cronológico y luego profundizaremos en algo más de IA. acontecimientos de esta semana.

Lanzamiento general de Géminis Pro 1.5

El martes por la mañana, hora del Pacífico, Google anunció que su modelo Gemini 1.5 Pro (que cubrimos por primera vez en febrero) ahora está disponible en más de 180 países, excluyendo Europa, a través de la API Gemini en una vista previa pública. Este es el LLM público más poderoso de Google hasta el momento y está disponible en un nivel gratuito que permite hasta 50 solicitudes por día.

Admite hasta 1 millón de tokens de contexto de entrada. Como señala Willison en su blog, el precio API de Gemini 1.5 Pro de $7/millón de tokens de entrada y $21/millón de tokens de salida cuesta un poco menos que GPT-4 Turbo (con un precio de $10/millón de entrada y $30/millón de salida) y más que Claude 3 Sonnet (LLM de nivel medio de Anthropic, con un precio de $3/millón de entrada y $15/millón de salida).

En particular, Gemini 1.5 Pro incluye procesamiento de entrada de audio (voz) nativo que permite a los usuarios cargar mensajes de audio o video, una nueva API de archivos para manejar archivos, la capacidad de agregar instrucciones personalizadas del sistema (mensajes del sistema) para guiar las respuestas del modelo y un formato JSON. Modo para extracción de datos estructurados.

Lanzamiento del GPT-4 Turbo “muy mejorado”

Poco después del lanzamiento de Google 1.5 Pro el martes, OpenAI anunció que estaba lanzando una versión «muy mejorada» de GPT-4 Turbo (una familia de modelos lanzada originalmente en noviembre) llamada «gpt-4-turbo-2024-04″. -09.» Integra el procesamiento multimodal GPT-4 Vision (que reconoce el contenido de las imágenes) directamente en el modelo y se lanzó inicialmente solo mediante acceso API.

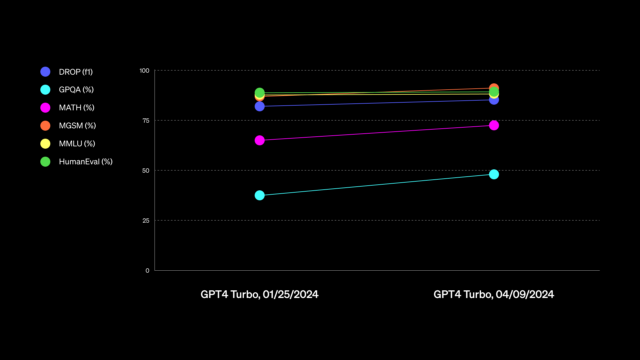

Luego, el jueves, OpenAI anunció que el nuevo modelo GPT-4 Turbo acababa de estar disponible para usuarios pagos de ChatGPT. OpenAI dijo que el nuevo modelo mejora «las capacidades de escritura, matemáticas, razonamiento lógico y codificación» y compartió un cuadro que no es particularmente útil para juzgar las capacidades (que luego actualizaron). La compañía también proporcionó un ejemplo de una supuesta mejora, diciendo que al escribir con ChatGPT, el asistente de inteligencia artificial utilizará un lenguaje «más directo, menos detallado y más conversacional».

La naturaleza vaga de los anuncios del GPT-4 Turbo de OpenAI generó cierta confusión y críticas en línea. En X, Willison escribió: «¿Quién será el primer proveedor de LLM en publicar notas de la versión realmente útiles?» En cierto modo, este es nuevamente un caso de «vibraciones de IA», como comentamos en nuestra queja sobre el mal estado de los puntos de referencia de LLM durante el debut de Claude 3. «En realidad, no he detectado ninguna diferencia definida en la calidad. [related to GPT-4 Turbo]», nos dijo Willison directamente en una entrevista.

La actualización también amplió el límite de conocimiento de GPT-4 hasta abril de 2024, aunque algunas personas informan que lo logra mediante búsquedas web sigilosas en segundo plano, y otras en las redes sociales han informado problemas con confabulaciones relacionadas con fechas.

El misterioso lanzamiento Mixtral 8x22B de Mistral

Para no quedarse atrás, el martes por la noche, la empresa francesa de inteligencia artificial Mistral lanzó su último modelo con licencia abierta, Mixtral 8x22B, por tuiteando un enlace de torrent desprovisto de cualquier documentación o comentario, al igual que lo ha hecho con versiones anteriores.

El nuevo lanzamiento de la combinación de expertos (MoE) pesa con un mayor número de parámetros que su modelo abierto anteriormente más capaz, Mixtral 8x7B, que cubrimos en diciembre. Se rumorea que es potencialmente tan capaz como GPT-4 (¿De qué manera, preguntas? Vibraciones). Pero eso aún está por verse.

«Las evaluaciones aún están en marcha, pero la mayor pregunta abierta en este momento es qué tan bien se adapta Mixtral 8x22B», dijo Willison a Ars. «Si está en la misma clase de calidad que GPT-4 y Claude 3 Opus, entonces finalmente tendremos un modelo con licencia abierta que no estará muy por detrás de los mejores propietarios».

Esta versión tiene a Willison muy entusiasmado y dice: «Si esa cosa realmente es de clase GPT-4, es una locura, porque puedes ejecutarla en una computadora portátil (muy cara). Creo que necesitas 128 GB de RAM de MacBook, el doble de lo que yo». tener.»

El nuevo Mixtral aún no figura en Chatbot Arena, señaló Willison, porque Mistral aún no ha lanzado un modelo ajustado para chatear. Sigue siendo un LLM de tokens sin procesar y que predice el próximo. «Sin embargo, ahora hay al menos una versión adaptada de instrucción comunitaria», dice Willison.

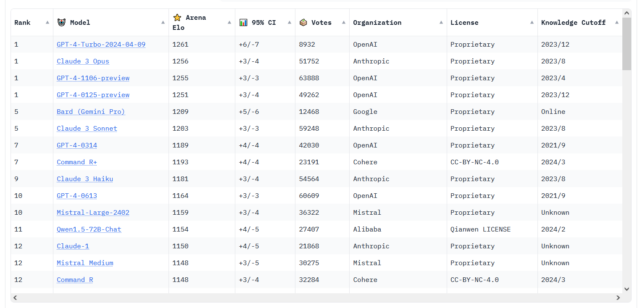

Cambios en la clasificación de Chatbot Arena

Benj Edwards

Las noticias sobre LLM de esta semana no se limitan solo a los grandes nombres en el campo. También ha habido rumores en las redes sociales sobre el creciente rendimiento de los modelos de código abierto como Command R+ de Cohere, que alcanzó la posición 6 en la clasificación LMSYS Chatbot Arena, la clasificación más alta jamás alcanzada para un modelo de peso abierto.

Y para aún más acción en Chatbot Arena, aparentemente la nueva versión de GPT-4 Turbo está resultando competitiva con Claude 3 Opus. Los dos todavía están empatados estadísticamente, pero recientemente el GPT-4 Turbo se adelantó numéricamente. (En marzo, informamos cuando Claude 3 se adelantó numéricamente por primera vez al GPT-4 Turbo, que fue entonces la primera vez que otro modelo de IA superó a un miembro del modelo de la familia GPT-4 en la clasificación).

Con respecto a esta feroz competencia entre los LLM, de la cual la mayor parte del mundo muggle desconoce y probablemente nunca lo conocerá, Willison le dijo a Ars: «Los últimos dos meses han sido un torbellino; finalmente tenemos no solo uno, sino varios modelos que son competitivos con GPT. -4.» Veremos si el rumoreado lanzamiento de GPT-5 por parte de OpenAI a finales de este año restaurará el liderazgo tecnológico de la compañía, que alguna vez pareció insuperable. Pero por ahora, dice Willison, «OpenAI ya no es el líder indiscutible en los LLM».