Microsoft finalmente presenta su primer lote de chips de IA «de cosecha propia», el acelerador de IA Azure Maia y la CPU ARM Azure Cobalt destinados a lograr un rendimiento computacional de vanguardia.

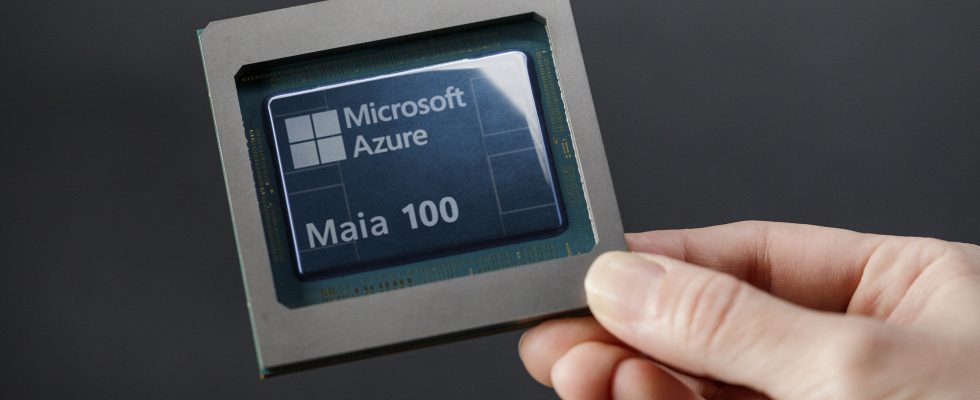

Microsoft presenta la primera IA personalizada y silicio informático: conozca Azure Maia 100 y Azure Cobalt 100

Ahora, echemos un vistazo a algunos factores que realmente llevaron a Microsoft a cambiar a soluciones de inteligencia artificial internas. El primero es destacarse entre los competidores, ya que actualmente, en términos de la «carrera de la IA», Microsoft está muy por delante, principalmente porque la empresa está en pleno proceso de integración de capacidades de IA generativa en toda su cartera, incluidas las aplicaciones convencionales y empresariales.

La segunda razón es reducir la dependencia de toda la «cadena de suministro», ya que actualmente todo el mercado está confinado a proveedores específicos, entre los que destacan NVIDIA y TSMC, que se enfrentan a enormes retrasos en los pedidos.

En el evento Microsoft Ignite de hoy, la compañía emitió un comunicado revelando que planea tomar las riendas en sus propias manos. Microsoft cree que la introducción de componentes de IA locales es «la última pieza del rompecabezas» cuando se trata de ofrecer una infraestructura de primer nivel a sus clientes y socios, así como un paso hacia la reducción de la dependencia de los proveedores de la industria.

Microsoft está construyendo la infraestructura para respaldar la innovación en IA y estamos reinventando cada aspecto de nuestros centros de datos para satisfacer las necesidades de nuestros clientes.

A la escala en la que operamos, es importante para nosotros optimizar e integrar cada capa de la infraestructura para maximizar el rendimiento, diversificar nuestra cadena de suministro y brindar a los clientes opciones de infraestructura.

-Scott Guthrie, vicepresidente ejecutivo del grupo Cloud + AI de Microsoft

La introducción de los productos de inteligencia artificial personalizados de Microsoft no es una sorpresa, ya que se rumorea que la compañía está desarrollando soluciones internas desde hace mucho tiempo. La ventaja que tiene Microsoft aquí es que puede «optimizar» los chips de IA de acuerdo con las cargas de trabajo de IA y la nube de la propia empresa. Aprovechando el poder de los recursos de software ya creados, Microsoft planea combinar hardware para crear un producto final que ayudará a la empresa a propagarse en el futuro en términos de potencia, rendimiento, sostenibilidad y costo.

Pasando a las partes más interesantes, lamentablemente es triste revelar que Microsoft no ha revelado ningún tipo de especificaciones o estadísticas sobre ninguno de sus chips de IA, pero la empresa ha revelado que su acelerador Maia AI ya ha sido adoptado por OpenAI, y Dado que el acelerador está dirigido específicamente a la pila de hardware de Azure, y con las mejoras generacionales en el diseño de chips y la infraestructura de inteligencia artificial, Microsoft cree que podría generar «enormes ganancias» con su producto.

Profundizando en los aspectos técnicos, Microsoft Azure Maia 100 es un ASIC construido sobre el nodo de 5 nm de TSMC y utiliza un host x86. El chip se montará en bastidores personalizados refrigerados por líquido que ofrecerán hasta 4 chips. El chip admitirá formatos de datos estándar INT8 e INT4 y utilizará interfaces Ethernet integradas.

Nos emocionó cuando Microsoft compartió por primera vez sus diseños para el chip Maia y trabajamos juntos para perfeccionarlo y probarlo con nuestros modelos. La arquitectura de IA de extremo a extremo de Azure, ahora optimizada hasta el silicio con Maia, allana el camino para entrenar modelos más capaces y hacer que esos modelos sean más baratos para nuestros clientes.

-Sam Altman, director ejecutivo de OpenAI

La CPU Microsoft Azure Cobalt 100 está construida sobre una arquitectura ARM, y Microsoft cree que la firma británica tiene los mejores diseños del mercado, lo que les permite exprimir el máximo «rendimiento por vatio» para los centros de datos de la compañía. La compañía ha definido un total de 128 núcleos Neoverse N2 con soporte de memoria DDR5 de 12 canales y hasta un 40% más de rendimiento por núcleo en comparación con los chips de servidor ARM salientes.

¿Qué tipo de impacto tendría la industria con los propios chips de IA de Microsoft? Bueno, es seguro que aumentaría la competitividad, pero eso no se puede concluir en este momento ya que no tenemos ningún tipo de estadística de desempeño que respalde nuestra conclusión. Lo que Microsoft ha revelado es que las plataformas Azure AI y Azure CPU estarán respaldadas por un enfoque totalmente personalizado que involucra controladores personalizados y plazos de entrega personalizados.

Sin embargo, el enfoque de cambiar a productos locales se ha estado «cocinando» desde hace mucho tiempo, y Microsoft cree que en la industria se necesita algo diferente. Será interesante ver cómo el acelerador Azure Maia 100 AI y la pila de CPU Azure Cobalt 100 se encuentran entre las ofertas de la industria, pero los competidores deben ser cautelosos. Microsoft seguirá ofreciendo servicios en la nube de Azure con silicio de terceros, ya que ya anunció nuevas instancias NVIDIA Hopper H100 y H200 y también aprovechará la próxima plataforma Instinct MI300X y EPYC de cuarta generación de AMD para alimentar las máquinas virtuales.