Nvidia afirma que su nuevo software de código abierto TensorRT-LL puede aumentar drásticamente el rendimiento de los modelos de lenguajes grandes (LLM) en sus GPU. Según la compañía, las capacidades de TensorRT-LL de Nvidia le permitieron duplicar el rendimiento de su GPU de cómputo H100 en GPT-J LLM con seis mil millones de parámetros. Es importante destacar que el software puede permitir esta mejora del rendimiento sin volver a entrenar el modelo.

Nvidia desarrolló TensorRT-LLM específicamente para acelerar el rendimiento de la inferencia LLM y los gráficos de rendimiento proporcionados por Nvidia muestran un aumento de velocidad 2 veces mayor para su H100 debido a las optimizaciones de software apropiadas. Una característica particularmente destacada de TensorRT-LLM de Nvidia es su innovadora técnica de procesamiento por lotes en vuelo. Este método aborda las cargas de trabajo dinámicas y diversas de los LLM, que pueden variar mucho en sus demandas computacionales.

El procesamiento por lotes en vuelo optimiza la programación de estas cargas de trabajo, lo que garantiza que los recursos de la GPU se utilicen en su máximo potencial. Como resultado, las solicitudes de LLM del mundo real en las GPU H100 Tensor Core ven una duplicación en el rendimiento, lo que lleva a procesos de inferencia de IA más rápidos y eficientes.

Nvidia dice que su TensorRT-LLM integra un compilador de aprendizaje profundo con núcleos optimizados, pasos de pre y posprocesamiento y primitivas de comunicación multi-GPU/multi-nodo, asegurando que se ejecuten de manera más eficiente en sus GPU. Esta integración se complementa aún más con una API Python modular, que proporciona una interfaz fácil de usar para los desarrolladores para aumentar aún más las capacidades del software y el hardware sin profundizar en lenguajes de programación complejos. Por ejemplo, MosaicML agregó funciones específicas que necesitaba además de TensorRT-LLM sin problemas y las integró en su servicio de inferencia.

«TensorRT-LLM es fácil de usar, está repleto de funciones con transmisión de tokens, procesamiento por lotes en vuelo, atención paginada, cuantificación y más, y es eficiente», afirmó Naveen Rao, vicepresidente de ingeniería de Databricks. «Ofrece un rendimiento de última generación para el servicio LLM utilizando GPU NVIDIA y nos permite trasladar el ahorro de costos a nuestros clientes».

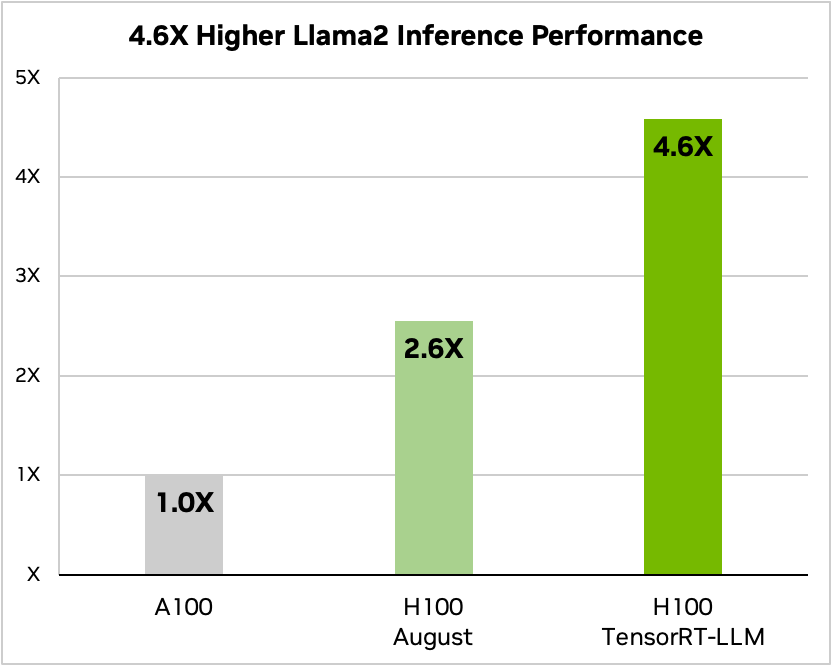

El rendimiento del H100 de Nvidia cuando se combina con TensorRT-LLM es impresionante. En la arquitectura Hopper de NVIDIA, la GPU H100, cuando se combina con TensorRT-LLM, supera a la GPU A100 por un factor de ocho. Además, al probar el modelo Llama 2 desarrollado por Meta, TensorRT-LLM logró una aceleración de 4,6 veces en el rendimiento de inferencia en comparación con las GPU A100. Estas cifras subrayan el potencial transformador del software en el ámbito de la inteligencia artificial y el aprendizaje automático.

Por último, las GPU H100, cuando se utilizan junto con TensorRT-LLM, admiten el formato FP8. Esta capacidad permite una reducción en el consumo de memoria sin pérdida en la precisión del modelo, lo cual es beneficioso para las empresas que tienen un presupuesto y/o espacio en el centro de datos limitado y no pueden instalar una cantidad suficiente de servidores para ajustar sus LLM.