El auge de la IA generativa está impulsando las ventas de servidores utilizados para la inteligencia artificial (IA) y la computación de alto rendimiento (HPC), y decenas de empresas se beneficiarán de él. Pero una empresa probablemente se beneficiará más que otras. Se estima que Nvidia venderá más de medio millón de sus GPU de cómputo H100 de gama alta por valor de decenas de miles de millones de dólares en 2023, informa Financial Times.

Nvidia está listo para enviar alrededor de 550,000 de sus últimas GPU de cómputo H100 en todo el mundo en 2023, y la mayoría se destinará a firmas tecnológicas estadounidenses, según varios expertos vinculados a Nvidia y TSMC que hablaron con Financial Times. Nvidia optó por no hacer ningún comentario sobre el asunto, lo cual es comprensible teniendo en cuenta las reglas de la FTC.

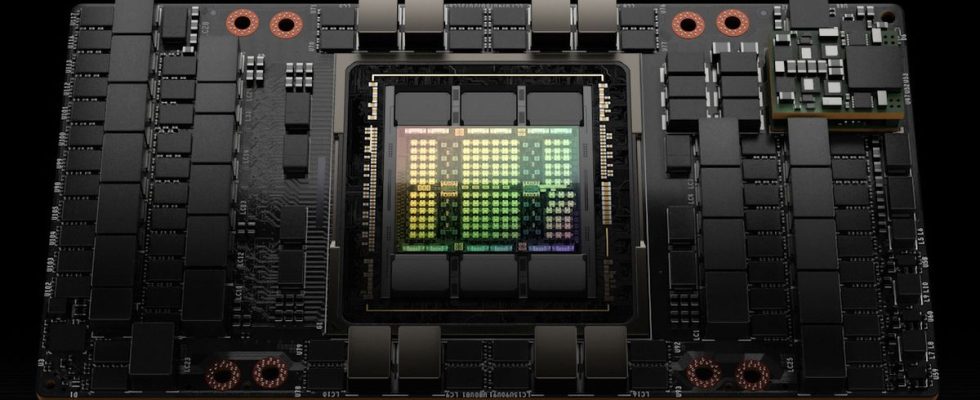

Si bien no conocemos la combinación precisa de GPU vendidas, cada tarjeta complementaria de GPU de cómputo HBM2E Nvidia H100 de 80 GB (14 592 núcleos CUDA, 26 FP64 TFLOPS, 1513 FP16 TFLOPS) se vende al por menor por alrededor de $ 30 000 en los EE. UU. Sin embargo, esto no es la pieza basada en la arquitectura Hopper de mayor rendimiento de la empresa. De hecho, este es el más barato, al menos por ahora. Mientras tanto, en China, una tarjeta de este tipo puede costar hasta 70.000 dólares.

Las ofertas de gama alta de Nvidia con tecnología H100 incluyen H100 SXM 80GB HBM3 (16,896 CUDA cores, 34 FP64 TFLOPS, 1,979 FP16 TFLOPS) y la solución de tarjeta dual H100 NVL 188GB HBM3. Estas piezas se venden directamente a fabricantes de servidores como Foxconn y Quanta, o se suministran dentro de servidores que Nvidia vende directamente. Además, Nvidia está a punto de comenzar a enviar su plataforma GH200 Grace Hopper que consta de su procesador Grace de 72 núcleos y una GPU de cómputo H100 de 80 GB HBM3E.

Nvidia no publica los precios de sus productos H100 SXM, H100 NVL y GH200 Grace Hopper, ya que dependen del volumen y la relación comercial entre Nvidia y un cliente en particular. Mientras tanto, incluso si Nvidia vende cada uno de los productos basados en H100 por $ 30,000, eso representaría $ 16,5 mil millones este año solo en las GPU de cómputo de última generación. Pero la compañía no vende solo GPU de cómputo de la serie H100.

Hay empresas que todavía usan las GPU de cómputo A100 de la generación anterior de Nvidia para impulsar sus implementaciones existentes sin realizar ningún cambio en su software y hardware. También están los modelos A800 y H800 específicos de China.

Si bien no podemos hacer estimaciones precisas sobre dónde aterrizarán las ganancias de Nvidia por la venta de GPU de cómputo, ni la cantidad precisa de GPU de cómputo que la compañía venderá este año, podemos hacer algunas conjeturas. El negocio del centro de datos de Nvidia generó $ 4,284 mil millones en el primer trimestre del año fiscal 2024 de la compañía (finalizado el 30 de abril). Dado el actual frenesí de la IA, parece que las ventas de las GPU de cómputo de Nvidia fueron más altas en el segundo trimestre del año fiscal 2024, que finalizó a fines de julio. En otras palabras, el año fiscal completo de 2023 batirá récords para la unidad de centro de datos de Nvidia.

Es digno de mención que el socio de Nvidia, TSMC, apenas puede satisfacer la demanda de GPU de cómputo en este momento, ya que todos usan el paquete CoWoS y la fundición está luchando para aumentar la capacidad de este método de paquete de chips. Con numerosas empresas que buscan comprar decenas de miles de GPU de cómputo para fines de inteligencia artificial, es probable que la oferta no coincida con la demanda durante bastante tiempo.