Just_Super/E+ vía Getty

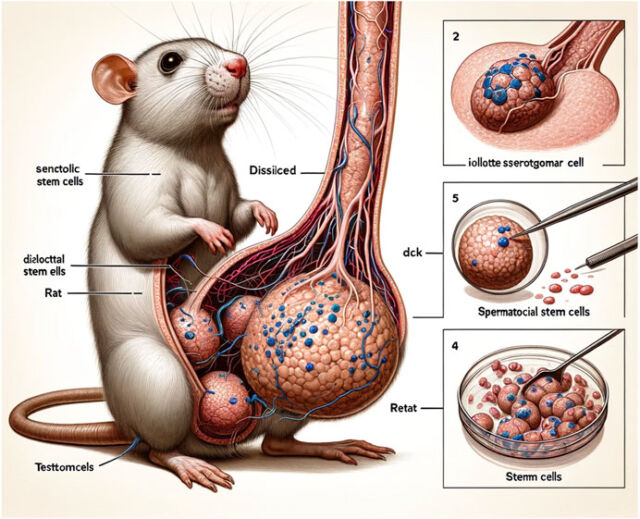

El mes pasado, fuimos testigos de la sensación viral de varias cifras atrozmente malas generadas por IA publicadas en un artículo revisado por pares en Frontiers, una revista científica de renombre. Los científicos en las redes sociales expresaron a partes iguales conmoción y burla ante las imágenes, una de las cuales mostraba una rata con genitales grotescamente grandes y extraños.

Como informó Beth Mole, reportera senior de salud de Ars, mirar más de cerca solo reveló más fallas, incluidas las etiquetas «dissilced», «Stemm cell», «iollotte sserotgomar» y «dck». La figura 2 era menos gráfica pero igualmente destrozada, plagada de textos sin sentido e imágenes desconcertantes. Lo mismo ocurre con la Figura 3, un collage de pequeñas imágenes circulares densamente anotadas con galimatías.

Desde entonces, el artículo ha sido retirado, pero esa sorprendente imagen del pene de rata permanecerá impresa de forma indeleble en nuestra conciencia colectiva. El incidente refuerza la creciente preocupación de que el uso cada vez mayor de la IA hará que las investigaciones científicas publicadas sean menos confiables, incluso aunque aumente la productividad. Si bien la proliferación de errores es una preocupación válida, especialmente en los primeros días de herramientas de inteligencia artificial como ChatGPT, dos investigadores sostienen en una nueva perspectiva publicada en la revista Nature que la inteligencia artificial también plantea riesgos epistémicos potenciales a largo plazo para la práctica de la ciencia.

Molly Crockett es psicóloga de la Universidad de Princeton y colabora habitualmente con investigadores de otras disciplinas en su investigación sobre cómo las personas aprenden y toman decisiones en situaciones sociales. Su coautora, Lisa Messeri, es antropóloga de la Universidad de Yale cuya investigación se centra en estudios de ciencia y tecnología (CTS), analizando las normas y consecuencias de las comunidades científicas y tecnológicas a medida que forjan nuevos campos de conocimiento e invención, como la IA.

El impulso original para su nuevo artículo fue un estudio de 2019 publicado en Proceedings of the National Academy of Sciences que afirmaba que los investigadores podrían utilizar el aprendizaje automático para predecir la replicabilidad de los estudios basándose únicamente en un análisis de sus textos. Crockett y Messeri coescribieron una carta al editor cuestionando esa afirmación, pero poco después aparecieron varios estudios más que afirmaban que grandes modelos de lenguaje podrían reemplazar a los humanos en la investigación psicológica. La pareja se dio cuenta de que se trataba de un problema mucho mayor y decidió trabajar juntos en un análisis en profundidad de cómo los científicos proponen utilizar las herramientas de IA en todo el proceso académico.

Propusieron cuatro categorías de visiones de la IA en la ciencia. La primera es la IA como Oracle, en la que dichas herramientas pueden ayudar a los investigadores a buscar, evaluar y resumir la vasta literatura científica, así como a generar hipótesis novedosas. El segundo es la IA como sustituto, en la que las herramientas de IA generan puntos de datos sustitutos, tal vez incluso reemplazando a sujetos humanos. El tercero es la IA como Quant. En la era del big data, las herramientas de inteligencia artificial pueden superar los límites del intelecto humano mediante el análisis de conjuntos de datos vastos y complejos. Finalmente, está la IA como árbitro, que se basa en dichas herramientas para evaluar de manera más eficiente el mérito científico y la replicabilidad de los artículos presentados, así como para evaluar las propuestas de financiación.

Cada categoría trae beneficios innegables en forma de aumento de la productividad, pero también ciertos riesgos. Crockett y Messeri advierten particularmente contra tres «ilusiones de comprensión» distintas que pueden surgir de una dependencia excesiva de las herramientas de inteligencia artificial, que pueden explotar nuestras limitaciones cognitivas. Por ejemplo, un científico puede utilizar una herramienta de inteligencia artificial para modelar un fenómeno determinado y creer que, por lo tanto, comprende ese fenómeno más de lo que realmente lo entiende (una ilusión de profundidad explicativa). O un equipo podría pensar que está explorando todas las hipótesis comprobables cuando en realidad solo está explorando aquellas hipótesis que son comprobables utilizando IA (una ilusión de amplitud exploratoria). Finalmente, existe la ilusión de objetividad: la creencia de que las herramientas de IA son verdaderamente objetivas y no tienen sesgos ni puntos de vista, a diferencia de los humanos.

El lema del artículo es «producir más comprendiendo menos», y ese es el mensaje central que la pareja espera transmitir. «El objetivo del conocimiento científico es comprender el mundo y toda su complejidad, diversidad y expansión», dijo Messeri a Ars. «Nuestra preocupación es que, aunque estemos escribiendo más y más artículos, porque están limitados por lo que la IA puede y no puede hacer, al final, en realidad sólo estamos haciendo preguntas y produciendo muchos artículos que están dentro de nuestros límites. Las capacidades de la IA.»

Ni Crockett ni Messeri se oponen a cualquier Uso de herramientas de IA por parte de los científicos. «Es realmente útil en mi investigación y espero seguir usándolo en mi investigación», dijo Crockett a Ars. Más bien, adoptan un enfoque más agnóstico. «No nos corresponde a Molly y a mí decir: ‘Esto es lo que la IA debería o no debería ser'», dijo Messeri. «En lugar de ello, estamos haciendo observaciones sobre cómo se está posicionando actualmente la IA y luego considerando el ámbito de conversación que deberíamos tener sobre los riesgos asociados».

Ars habló extensamente con Crockett y Messeri para obtener más información.