A medida que el panorama de la IA se ha expandido para incluir docenas de modelos de lenguajes grandes (LLM) distintos, también han proliferado los debates sobre qué modelo proporciona las «mejores» respuestas para cualquier pregunta dada (Ars incluso ha profundizado en este tipo de debates varias veces en los últimos tiempos). meses). Para aquellos que buscan una forma más rigurosa de comparar varios modelos, la gente de Large Model Systems Organization (LMSys) ha creado Chatbot Arena, una plataforma para generar clasificaciones estilo Elo para LLM basadas en un sitio web de pruebas ciegas de colaboración colectiva.

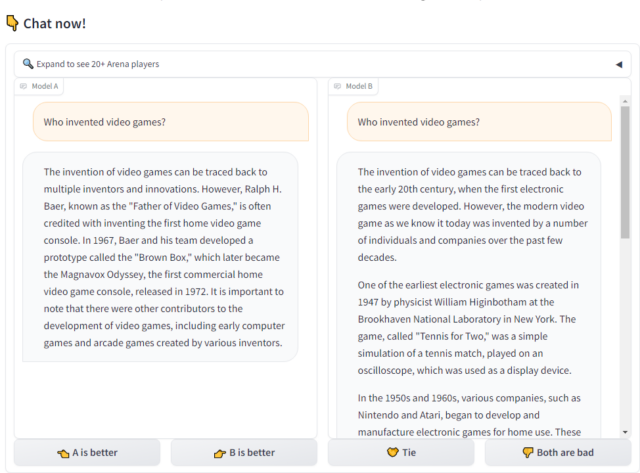

Los usuarios de Chatbot Arena pueden ingresar cualquier mensaje que se les ocurra en el formulario del sitio para ver respuestas en paralelo de dos modelos seleccionados al azar. La identidad de cada modelo está inicialmente oculta y los resultados se anulan si el modelo revela su identidad en la respuesta misma.

Luego, el usuario puede elegir qué modelo proporcionó lo que considera el «mejor» resultado, con opciones adicionales para un «empate» o «ambos son malos». Sólo después de proporcionar una clasificación por pares, el usuario puede ver qué modelos estaba juzgando, aunque una sección separada «lado a lado» del sitio permite a los usuarios elegir dos modelos específicos para comparar (sin la posibilidad de contribuir con un voto sobre el resultado).

Desde su lanzamiento público en mayo, LMSys dice que ha reunido más de 130.000 calificaciones ciegas por pares en 45 modelos diferentes (hasta principios de diciembre). Esas cifras parecen estar a punto de aumentar rápidamente después una reseña positiva reciente de Andrej Karpathy de OpenAI que ya ha llevado a lo que LMSys describe como «una súper prueba de estrés» para sus servidores.

Las miles de calificaciones por pares de Chatbot Arena se procesan a través de un modelo Bradley-Terry, que utiliza un muestreo aleatorio para generar una calificación estilo Elo que estima qué modelo tiene más probabilidades de ganar en competencia directa contra cualquier otro. Las partes interesadas también pueden profundizar en los datos sin procesar de decenas de miles de calificaciones de indicaciones/respuestas humanas por sí mismos o examinar estadísticas más detalladas, como tasas de ganancia directa por pares entre modelos y rangos de intervalos de confianza para esas estimaciones de Elo.