Al igual que muchas de las mejores y peores ideas del mundo, el plan de los investigadores del MIT para combatir las falsificaciones profundas generadas por IA nació cuando uno de ellos vio su programa de noticias favorito.

Tráiler de anuncio de Star Wars: Shatterpoint

02:27

Las primeras cosas que hacer en realidad virtual, parte 3

Hoy 9:39 a. m.

En el episodio del 25 de octubre de The Daily Show con Trevor Noah, la directora de tecnología de OpenAI, Mira Murati imágenes generadas por IA. Aunque probablemente podría hablar sobre el generador de imágenes de IA DALL-E 2 de OpenAI con gran detalle, no fue una entrevista muy profunda. Después de todo, se puso a disposición de todas las personas que probablemente entiendan poco o nada sobre el arte de la IA. Aún así, ofreció algunas pepitas de pensamiento. Noah le preguntó a Murati si había una manera de asegurarse de que los programas de inteligencia artificial no nos lleven a un mundo «donde nada es real y todo lo que es real, ¿no lo es?»

La semana pasada, los investigadores del Instituto Tecnológico de Massachusetts dijeron que querían responder esa pregunta. Idearon un programa relativamente simple que puede usar técnicas de envenenamiento de datos para alterar esencialmente los píxeles dentro de una imagen para crear un ruido invisible, lo que hace que los generadores de arte de IA sean incapaces de generar imágenes realistas. falsificaciones profundas basado en las fotos que están alimentados. Aleksander Madry, profesor de computación en el MIT, trabajó con el equipo de investigadores para desarrollar el programa y publicó sus resultados en Twitter y su blog del laboratorio.

Usando fotos de Noah con el comediante Michael Kosta del Daily Show, mostraron cómo este ruido imperceptible en la imagen impide que un generador de imágenes de IA del modelo de difusión cree una nueva foto usando la plantilla original. Los investigadores propusieron que cualquier persona que planee subir una imagen a Internet podría pasar su foto a través de su programa, básicamente inmunizándola contra los generadores de imágenes de IA.

G/O Media puede recibir una comisión

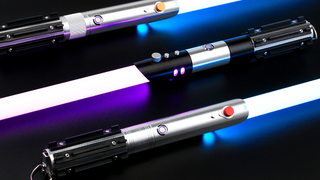

*zumbido de sable de luz*

sablespro

Para el fan de Star Wars con todo.

Estos sables de luz funcionan con Neopixels, tiras de LED que corren dentro de la forma de la hoja que permiten colores ajustables, sonidos interactivos y efectos de animación cambiantes cuando se baten en duelo.

Tenidoi Salman, un estudiante de doctorado en MIT cuyo trabajo gira en torno a los modelos de aprendizaje automático, le dijo a Gizmodo en una entrevista telefónica que el sistema que ayudó a desarrollar solo toma unos segundos para introducir ruido en una foto. Las imágenes de mayor resolución funcionan incluso mejor, dijo, ya que incluyen más píxeles que pueden alterarse minuciosamente.

Google está creando su propio generador de imágenes de IA llamado Imagen, aunque pocas personas han podido poner su sistema a prueba. La empresa también está trabajando en un sistema de video generativo de IA. Salman dijo que no han probado su sistema en video, pero en teoría aún debería funcionar, aunque el programa del MIT tendría que simular individualmente cada cuadro de un video, lo que podría ser decenas de miles de cuadros para cualquier video de más de unos minutos.

¿Se puede aplicar el envenenamiento de datos a los generadores de IA a escala?

Salman dijo que podía imaginar un futuro en el que las empresas, incluso las que generan los modelos de IA, pudieran certificar que las imágenes cargadas están inmunizadas contra los modelos de IA. Por supuesto, no son buenas noticias para los millones de imágenes que ya se cargaron en la biblioteca de código abierto como LAION, pero podría marcar la diferencia para cualquier imagen cargada en el futuro.

Madry también le dijo a Gizmodo por teléfono que este sistema, aunque su envenenamiento de datos ha funcionado en muchas de sus pruebas, es más una prueba de concepto que un lanzamiento de producto de cualquier tipo. El programa de los investigadores demuestra que hay formas de derrotar a los deepfakes antes de que sucedan.

Las empresas, dijo, deben conocer esta tecnología e implementarla en sus propios sistemas para que sea aún más resistente a la manipulación. Además, las empresas deberían asegurarse de que las versiones futuras de sus modelos de difusión, o cualquier otro tipo de generador de imágenes de IA, no puedan ignorar el ruido y generar nuevas falsificaciones profundas.

“Lo que realmente debería suceder en el futuro es que todas las empresas que desarrollan modelos de difusión deberían proporcionar la capacidad para una inmunización sólida y saludable”, dijo Madry.

Otros expertos en el campo del aprendizaje automático encontraron algunos puntos para criticar a los investigadores del MIT.

Florian Tramèr, profesor de informática en ETH Zurich en Suiza, tuiteó que la principal dificultad es que, básicamente, intentas engañar a todos los intentos futuros de crear una falsificación profunda con una imagen. Tramèr fue coautor de un papel 2021 publicado por la Conferencia Internacional sobre Representaciones de Aprendizaje que esencialmente encontró que el envenenamiento de datos, como lo que hace el sistema MIT con su ruido de imagen, no impedirá que los sistemas futuros encuentren formas de evitarlo. Más aún, la creación de estos sistemas de envenenamiento de datos creará una «carrera armamentista» entre los generadores de imágenes de IA comerciales y aquellos que intentan prevenir las falsificaciones profundas.

Ha habido otros programas de envenenamiento de datos destinados a lidiar con la vigilancia basada en IA, como Fawkes (sí, como el 5 de noviembre), que fue desarrollado por investigadores de la Universidad de Chicago. Fawkes también distorsiona los píxeles de las imágenes de tal manera que impiden que empresas como Clearview logren un reconocimiento facial preciso. Otros investigadores de la Universidad de Melbourne en Australia y la Universidad de Pekín en China también han analizado los posibles sistemas que pueden crear “ejemplos imposibles de aprender” que los generadores de imágenes de IA no pueden usar.

El problema es, como señaló la desarrolladora de Fawkes Emily Wenger en una entrevista con Revisión de tecnología del MITprogramas como Microsoft Azure lograron ganarle a Fawkes y detectar rostros a pesar de sus técnicas antagónicas.

Gautam Kamath, profesor de ciencias de la computación en la Universidad de Waterloo en Onatrio, Canadá, le dijo a Gizmodo en una entrevista de Zoom que en el «juego del gato y el ratón» entre quienes intentan crear modelos de IA y quienes encuentran formas de vencerlos, las personas que fabrican Los nuevos sistemas de inteligencia artificial parecen tener la ventaja, ya que una vez que una imagen está en Internet, en realidad nunca desaparece. Por lo tanto, si un sistema de IA logra eludir los intentos de evitar que sea falsificado, no hay una forma real de remediarlo.

“Es posible, si no probable, que en el futuro podamos evadir cualquier defensa que le pongas a esa imagen en particular”, dijo Kamath. “Y una vez que está ahí fuera, no puedes recuperarlo”.

Por supuesto, hay algunos sistemas de inteligencia artificial que pueden detectar videos falsos profundosy hay maneras de capacitar a las personas para detectar las pequeñas inconsistencias que muestran que un video está siendo falsificado. La pregunta es: ¿llegará un momento en que ni humanos ni máquinas puedan discernir si una foto o un video han sido manipulados?

¿Qué pasa con las empresas generadoras de IA más grandes?

Para Madry y Salman, la respuesta está en conseguir que las empresas de IA jueguen a la pelota. Madry dijo que están buscando ponerse en contacto con algunas de las principales empresas generadoras de IA para ver si estarían interesadas en facilitar su sistema propuesto, aunque, por supuesto, todavía está en sus inicios y el equipo del MIT todavía está trabajando en una API pública que permite a los usuarios inmunizar sus propias fotos (el código está disponible aquí).

De esa manera, todo depende de las personas que crean las plataformas de imágenes de IA. Si bien Murati de OpenAI le dijo a Noah en ese episodio de octubre que tienen «algunas medidas de protección» para su sistema, afirmando además que no permiten que las personas generen imágenes basadas en figuras públicas (que es un término bastante nebuloso en la era de las redes sociales donde prácticamente todos tiene una cara pública). El equipo también está trabajando en más filtros que impedirán que el sistema cree imágenes que contengan imágenes violentas o sexuales.

En septiembre, OpenAI anunció los usuarios podrían volver a subir rostros humanos a su sistema, pero afirmaron que habían construido formas de evitar que los usuarios mostraran rostros en contextos violentos o sexuales. También pidió a los usuarios que no subieran imágenes de personas sin su consentimiento, pero es mucho pedirle a Internet en general que haga promesas sin cruzar los dedos.

Sin embargo, eso no quiere decir que otros generadores de IA y las personas que los crearon estén dispuestos a moderar el contenido que generan sus usuarios. Stability AI, la compañía detrás de Stable Diffusion, ha demostrado que son mucho más reacios a introducir barreras que impidan que las personas creen pornografía o obras de arte derivadas utilizando su sistema. Si bien OpenAI ha sido, ejem, abierto sobre tratar de evitar que su sistema muestre sesgos en las imágenes que genera, StabilityAI se ha mantenido bastante callado.

Emad Mostaque, el CEO de Stability AI, ha abogado por un sistema sin influencia gubernamental o corporativa, y hasta ahora ha contraatacado en contra de las llamadas para poner más restricciones en su modelo de IA. Él tiene dijo que cree en la generación de imágenes se «resolverá en un año» y permitirá a los usuarios crear «cualquier cosa que puedas soñar». Por supuesto, eso es solo una exageración, pero muestra que Mostaque no está dispuesto a retroceder al ver que la tecnología avanza cada vez más.

Aún así, los investigadores del MIT se mantienen estables.

“Creo que hay muchas preguntas muy incómodas sobre cómo es el mundo cuando este tipo de tecnología es de fácil acceso y, nuevamente, ya es de fácil acceso y será aún más fácil de usar”, dijo Madry. “Estamos muy contentos y muy entusiasmados con el hecho de que ahora podemos hacer algo al respecto de manera consensuada”.