Durante mucho tiempo, la manipulación y la detección se han considerado dos pilares clave para desbloquear el potencial de la robótica. Hay un poco de superposición entre los dos, por supuesto. Dado que las pinzas se han convertido en un elemento fundamental de la robótica industrial, estos sistemas requieren mecanismos adecuados para interactuar con el mundo que los rodea.

La visión ha sido durante mucho tiempo una clave para todo esto, pero las empresas buscan cada vez más la tacticidad como método para recopilar datos. Entre otras cosas, le da al robot una mejor idea de cuánta presión debe aplicar a un objeto determinado, ya sea un producto o un ser humano.

Hace un par de meses, la startup Touchlab con sede en Edimburgo, Escocia, ganó el lanzamiento en nuestro evento TC Sessions: Robotics, entre una dura competencia. Los jueces acordaron que el enfoque de la empresa para la creación de una piel robótica es importante y puede ayudar a desbloquear un potencial más completo para la detección. El XPrize también ha estado de acuerdo hasta ahora. La compañía es actualmente finalista de la competencia XPrize Avatar de $ 10 millones.

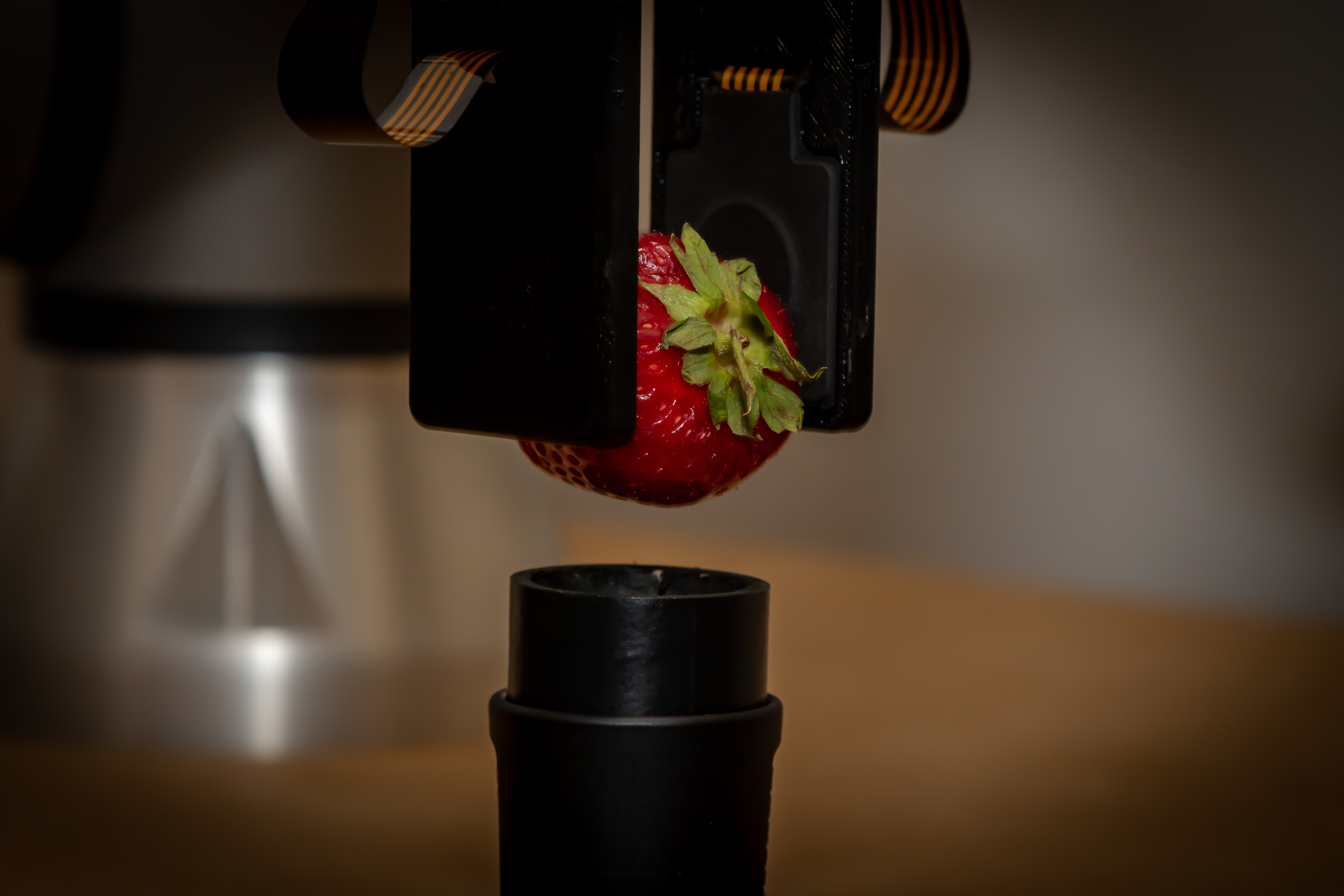

La firma está trabajando actualmente con la firma alemana de robótica Schunk, que proporciona la pinza para las finales de XPrize.

Créditos de imagen: laboratorio táctil

“Nuestra misión es hacer que esta piel electrónica para robots le dé a las máquinas el poder del toque humano”, dijo el cofundador y director ejecutivo Zaki Hussein, hablando con TechCrunch desde el nuevo espacio de oficinas de la compañía. “Hay muchos elementos que intervienen en la replicación del toque humano. Fabricamos esta tecnología de detección. Es más delgado que la piel humana y puede brindarle la posición y la presión donde sea que lo coloque en el robot. Y también le dará fuerzas 3D en el punto de contacto, lo que permite que los robots puedan realizar actividades diestras y desafiantes”.

Para empezar, la compañía está buscando aplicaciones de teleoperación (de ahí todo el asunto de XPrize Avatar), específicamente, usar el sistema para operar robots de forma remota en hospitales con poco personal. Por un lado, un robot TIAGo++ equipado con sus sensores brinda a los trabajadores humanos un par de manos adicionales; por el otro, un operador equipado con un traje háptico de realidad virtual que traduce todos los datos táctiles. Aunque tales tecnologías actualmente tienen sus limitaciones.

Créditos de imagen: laboratorio táctil

“Tenemos una capa de software que traduce la presión de la piel al traje. También estamos usando guantes hápticos”, dice Hussein. “Actualmente, nuestra piel recopila muchos más datos de los que podemos transmitir al usuario a través de interfaces hápticas. Así que hay un pequeño cuello de botella. Podemos usar todo el potencial de la mejor interfaz háptica del momento, pero hay un punto en el que el robot siente más de lo que el usuario puede sentir”.

La información adicional recopilada por el robot se traduce a través de una variedad de canales diferentes, como datos visuales a través de un auricular VR. La compañía está cerca de comenzar con pilotos del mundo real con el sistema. “Será en febrero”, dice Hussein. “Tenemos una prueba hospitalaria de tres meses con pacientes geriátricos en la sala de agudos geriátricos. Esta es una primicia mundial, donde este robot se implementará en ese entorno”.