Los megapíxeles solían ser mucho más simples: un número mayor significaba que su cámara podía capturar más detalles de la foto siempre que la escena tuviera suficiente luz. Pero una tecnología llamada agrupamiento de píxeles, ahora universal en los teléfonos inteligentes insignia, está cambiando las viejas reglas de la fotografía para mejor. En resumen, el agrupamiento de píxeles le brinda una cámara que ofrece muchos detalles cuando hay mucha luz, sin volverse inútil cuando hay poca luz.

Sin embargo, los cambios de hardware necesarios traen algunas compensaciones y detalles interesantes, y diferentes fabricantes de teléfonos están probando diferentes recetas de agrupamiento de píxeles, por lo que estamos analizando más de cerca.

Lee mas: Echa un vistazo a CNET Revisión de Google Pixel 7 Pro, Revisión del iPhone 14 Pro y Revisión del Galaxy S22 Ultra

El binning de píxeles llegó en 2018, se extendió ampliamente en 2020 con modelos como el Galaxy S20 Ultra de Samsung y el Mi 10 Pro de Xiaomi, y llegó al hardware de Apple y Google con los teléfonos iPhone 14 Pro y Pixel 7 en 2022. El modelo de gama alta de Samsung, el Galaxy S22 Ultra, cuenta con un Sensor de cámara principal de 108 megapíxelesy el binning de píxeles podría dar el siguiente salto tecnológico con el La esperada cámara principal de 200 megapíxeles del S23 Ultra ajustado a debut el 1 de febrero.

Aquí está su guía de lo que está pasando.

¿Qué es el agrupamiento de píxeles?

El binning de píxeles es una tecnología diseñada para hacer que un sensor de imagen se adapte mejor a diferentes condiciones al agrupar píxeles de diferentes maneras. Cuando hay mucha luz, puedes disparar a la máxima resolución del sensor, al menos en algunos teléfonos. Cuando está oscuro, los conjuntos de píxeles (2×2, 3×3 o 4×4, según el sensor) se pueden agrupar en píxeles virtuales más grandes que captan más luz pero toman fotografías de menor resolución.

Por ejemplo, Sensor Isocell HP2 de Samsung puede tomar fotografías de 200 megapíxeles, fotografías de 50 megapíxeles con grupos de 2×2 píxeles y fotografías de 12,5 megapíxeles con grupos de 4×4 píxeles.

El binning de píxeles ofrece otra ventaja que llegó a los teléfonos de 2020: el zoom virtual. Los teléfonos pueden recortar una toma para captar solo la luz de los píxeles centrales de la cámara principal de 48 megapíxeles del iPhone 14 Pro o la cámara de 50 megapíxeles del Google Pixel 7. Eso convierte una cámara principal de 1x en un zoom de 2x que toma fotos de 12 megapíxeles. Solo funcionará bien con una luz relativamente buena, pero es una excelente opción, y 12 megapíxeles es la resolución predominante desde hace años, por lo que sigue siendo una toma útil.

Con una resolución base tan alta, los sensores de agrupamiento de píxeles también pueden ser más hábiles con video de alta resolución, en particular con una resolución extremadamente alta de 8K.

El agrupamiento de píxeles requiere algunos cambios sofisticados en el propio sensor y en los algoritmos de procesamiento de imágenes que transforman los datos sin procesar del sensor en una foto o un video.

¿El agrupamiento de píxeles es un truco?

No. Bueno, mayormente no. Permite a los fabricantes de teléfonos presumir de números de megapíxeles que superan ampliamente lo que verá incluso en cámaras DSLR y sin espejo de nivel profesional. Eso es un poco tonto, ya que los píxeles más grandes de las cámaras de gama alta recogen mucha más luz y cuentan con mejores ópticas que los teléfonos inteligentes. Pero pocos de nosotros transportamos esas grandes cámaras, y el agrupamiento de píxeles puede sacar más calidad fotográfica de la cámara de su teléfono inteligente.

¿Cómo funciona el agrupamiento de píxeles?

Para comprender mejor el agrupamiento de píxeles, debe saber cómo es el sensor de imagen de una cámara digital. Es un chip de silicio con una cuadrícula de millones de píxeles (técnicamente llamados fotositos) que capturan la luz que entra por la lente de la cámara. Cada píxel registra un solo color: rojo, verde o azul.

Los colores están escalonados en un arreglo especial de tablero de ajedrez llamado patrón de Bayer que permite que una cámara digital reconstruya los tres valores de color para cada píxel, un paso clave para generar ese JPEG que desea compartir en Instagram.

Este diagrama muestra cómo el sensor de imagen de la cámara de 108 megapíxeles del Samsung Galaxy S20 Ultra tiene grupos de píxeles de 3×3 para permitir la agrupación de píxeles. La tecnología permite que una cámara tome fotos de alta resolución cuando hay mucha luz o tomas de menor resolución con poca luz.

Samsung

La combinación de datos de múltiples píxeles pequeños en el sensor de imagen en un píxel virtual más grande es realmente útil para situaciones de poca luz, donde los píxeles grandes son mejores para mantener a raya el ruido de la imagen y capturar mejor el color. Cuando hay más luz afuera, hay suficiente luz para que los píxeles individuales funcionen por sí solos, ofreciendo una toma de mayor resolución o una vista ampliada.

El agrupamiento de píxeles comúnmente combina cuatro píxeles reales en un «contenedor» de píxeles virtuales. Pero la línea Galaxy S Ultra de Samsung ha utilizado un grupo de 3×3 de píxeles reales en un píxel virtual, y es probable que la empresa surcoreana adopte el binning 4×4 con el Galaxy S23 Ultra.

¿Cuándo debería usar alta resolución versus agrupamiento de píxeles?

La mayoría de la gente estará contenta con las tomas de menor resolución, y esa es la opción predeterminada que recomiendan mis colegas Jessica Dolcourt y Patrick Holland después de probar los nuevos teléfonos Samsung Galaxy. Los iPhones de Apple ni siquiera tomarán fotos de 50 megapíxeles a menos que habilites específicamente la opción mientras disparas con su formato de imagen ProRaw de gama alta, y el Pixel 7 Pro de Google no ofrece fotos completas de 50 megapíxeles.

Las tomas de 12 megapíxeles ofrecen un mejor rendimiento con poca luz, pero también evitan los tamaños de archivo monstruosos de las imágenes de resolución completa que pueden consumir almacenamiento en su dispositivo y servicios en línea como Google Photos e iCloud. Por ejemplo, una toma de muestra mi colega Lexy Savvides tomó fue de 3,6 MB a 12 megapíxeles con agrupamiento de píxeles y 24 MB a 108 megapíxeles sin él.

Es más probable que los entusiastas de la fotografía deseen usar la resolución completa cuando sea factible. Eso podría ayudarlo a identificar aves distantes o tomar fotografías de naturaleza más dramáticas de sujetos distantes. Y si te gusta imprimir fotos grandes (sí, algunas personas todavía hacen impresiones), importan más megapíxeles.

¿Un Samsung Galaxy S21 Ultra de 108 megapíxeles toma mejores fotos que una cámara profesional Sony A7r V de 61 megapíxeles?

No. El tamaño de cada píxel en el sensor de imagen también importa, junto con otros factores como lentes y procesamiento de imágenes. Hay una razón por la que Sony A7r V cuesta $3898 mientras que el S22 Ultra cuesta $1200 y también puede ejecutar miles de aplicaciones y hacer llamadas telefónicas.

Los píxeles del sensor de imagen son cuadrados cuyo ancho se mide en millonésimas de metro o micras. Un cabello humano mide aproximadamente 75 micrones de ancho. En la Isocell HP2 de Samsung, un píxel virtual en una toma de 12 megapíxeles tiene 2,4 micrones de ancho. En el modo de 200 megapíxeles, un píxel mide solo 0,6 micrones. Sin embargo, en una Sony A7r V, un píxel mide 3,8 micrones de ancho. Eso significa que Sony puede captar dos veces y media más luz por píxel que un teléfono con el HP2 Ultra con modo binning de 12 megapíxeles y 39 veces más que en el modo de resolución completa de 200 megapíxeles, una mejora importante en la calidad de imagen.

Sin embargo, los teléfonos avanzan más rápido que las cámaras tradicionales y cierran la brecha de calidad de imagen. La tecnología de fotografía computacional, como la combinación de varios fotogramas en una sola toma, y otros trucos de procesamiento de software que son posibles gracias a los potentes chips de los teléfonos, también están ayudando. Por eso mi colega y profesional El fotógrafo Andrew Lanxon puede tomar fotos con teléfonos inteligentes con poca luz portátil que llevaría un trípode con su DSLR. Y los sensores de imagen en los teléfonos inteligentes son cada vez más grandes para mejorar la calidad.

¿Por qué es popular el agrupamiento de píxeles?

Porque la miniaturización ha hecho posibles píxeles cada vez más pequeños. «Lo que ha impulsado el binning es esta nueva tendencia de píxeles submicrónicos», aquellos de menos de una micra de ancho, dijo Devang Patel, gerente senior de marketing de Omnivision, un importante fabricante de sensores de imagen. Tener muchos de esos píxeles permite a los fabricantes de teléfonos, desesperados por hacer que el teléfono de este año se destaque, presumir de muchas clasificaciones de megapíxeles y videos de 8K. Binning les permite hacer ese alarde sin sacrificar la sensibilidad con poca luz.

¿Puedes disparar en bruto con binning de píxeles?

Eso depende del teléfono. A los entusiastas de la fotografía les gusta la flexibilidad y la calidad de imagen de las fotos sin procesar: los datos del sensor de imagen sin procesar, empaquetados como un archivo DNG. Pero no todos los teléfonos exponen la foto en bruto a máxima resolución. El iPhone 14 Pro sí, pero el Pixel 7 Pro no, por ejemplo.

La situación se complica por el hecho de que el software de procesamiento en bruto como Adobe Lightroom espera imágenes en bruto cuyos datos de color vengan en un patrón tradicional de Bayer, no celdas de píxeles agrupadas en parches de 2×2 o 3×3 del mismo color.

Sin embargo, el Isocell HP2 tiene un truco inteligente aquí: utiliza tecnología de inteligencia artificial para «quitar» los grupos de píxeles de 4×4 para construir el tablero de ajedrez de color del patrón tradicional de Bayer. Eso significa que puede tomar fotos en bruto con una resolución completa de 200 megapíxeles, aunque queda por ver si esa será una opción expuesta en los teléfonos inteligentes de envío.

¿Cuáles son las desventajas del agrupamiento de píxeles?

Para el sensor del mismo tamaño, 12 megapíxeles reales funcionarían un poco mejor que 12 megapíxeles agrupados, dice Judd Heape, director sénior de Qualcomm, que fabrica chips para teléfonos móviles. Es probable que el sensor también sea menos costoso. Y cuando dispara a máxima resolución, se requiere más procesamiento de imágenes, lo que acorta la duración de la batería.

De hecho, los costos del sensor de pixel binning y los requisitos de potencia de procesamiento y batería son las razones por las que es una opción principalmente en teléfonos de gama alta.

Para fotos de alta resolución, obtendrá una mejor nitidez con un patrón de Bayer normal que con un sensor binning que usa grupos de 2×2 o 3×3 de píxeles del mismo color. Pero eso no es un problema tan malo. «Con nuestro algoritmo, podemos recuperar entre el 90% y el 95% de la calidad de imagen real de Bayer», dijo Patel. Al comparar los dos enfoques en imágenes una al lado de la otra, probablemente no notará la diferencia fuera de las escenas de prueba de laboratorio con situaciones difíciles como líneas finas.

Si olvida cambiar su teléfono al modo binning y luego toma fotos de alta resolución en la oscuridad, la calidad de la imagen se ve afectada. Apple usa automáticamente el agrupamiento de píxeles para tomar fotos de menor resolución, eludiendo ese riesgo.

¿Las cámaras normales también podrían usar la agrupación de píxeles?

Sí, ya juzgar por algunos diseños de sensores de fotograma completo de Sony, el principal fabricante de sensores de imagen en este momento, algún día lo harán.

¿Cuál es el futuro del binning de píxeles?

Varios desarrollos son posibles. Los sensores de muy alta resolución con agrupamiento de 4×4 píxeles podrían extenderse a más teléfonos premium, y un agrupamiento menos exótico de 2×2 píxeles se extenderá a los teléfonos de gama baja.

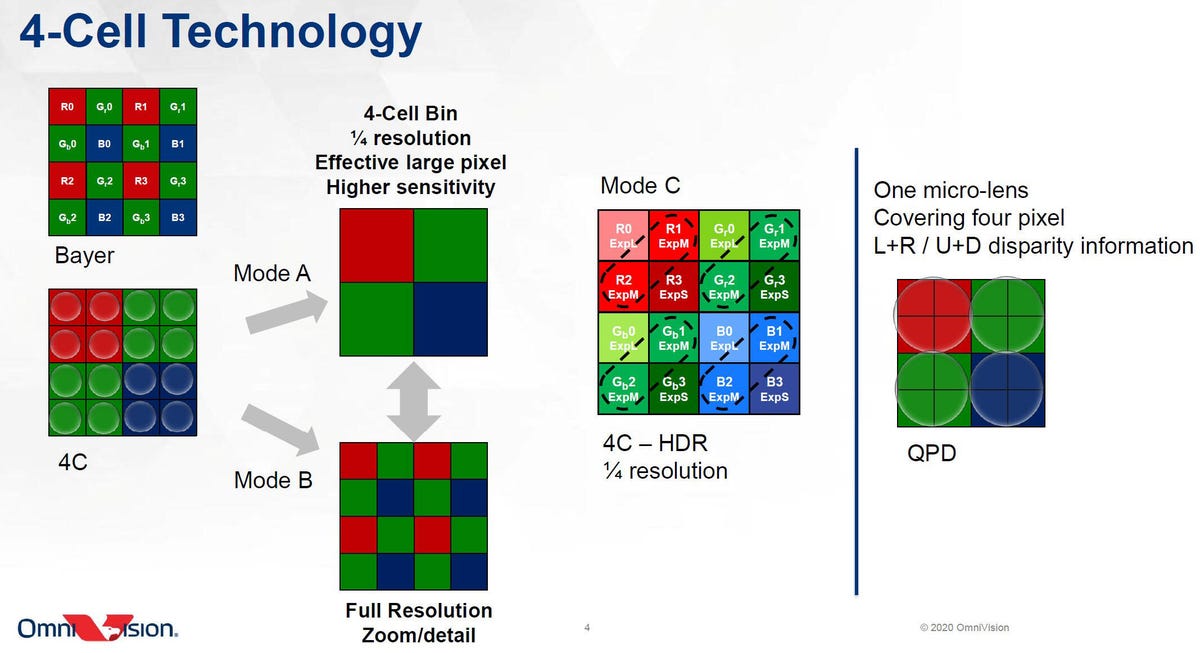

El fabricante de sensores Omnivision muestra cómo se puede usar el binning de 2×2 píxeles (abajo a la izquierda) para crear píxeles virtuales más grandes (segunda fila, arriba) o recrear un patrón de tablero de ajedrez tradicional de Bayer (segunda fila, abajo). También se puede usar para crear imágenes HDR (tercera fila) o para mejorar el enfoque automático con microlentes más grandes (cuarta fila).

Omnivisión

Otra dirección es una mejor fotografía HDR, o alto rango dinámico, que captura una mejor gama de datos de imágenes brillantes y oscuras. Los sensores de los teléfonos pequeños luchan por capturar un amplio rango dinámico, razón por la cual compañías como Google y Apple combinan múltiples tomas para generar computacionalmente fotos HDR.

Pero el agrupamiento de píxeles significa una nueva flexibilidad a nivel de píxeles. En un grupo de 2×2, puede dedicar dos píxeles a la exposición regular, uno a una exposición más oscura para capturar los reflejos como cielos brillantes y otro a una exposición más brillante para capturar los detalles de las sombras.

De hecho, la HP2 de Samsung puede dividir las tareas de píxeles de esta manera para las imágenes HDR.

Omnivision también espera mejoras en el enfoque automático. Con diseños anteriores, cada píxel está cubierto con su propia microlente diseñada para captar más luz. Pero ahora, una sola microlente a veces también abarca un grupo de 2×2, 3×3 o 4×4. Cada píxel debajo de la misma microlente obtiene una vista ligeramente diferente de la escena, según su posición, y la diferencia permite que una cámara digital calcule la distancia de enfoque. Eso debería ayudar a su cámara a mantener los sujetos de la foto bien enfocados.