Escribir un informe sobre el estado de la IA debe parecerse mucho a construir sobre arenas movedizas: para cuando presionas publicar, toda la industria ha cambiado bajo tus pies. Pero todavía hay tendencias y conclusiones importantes en la oferta de 386 páginas de Stanford para resumir este dominio complejo y de rápido movimiento.

El Índice AI, del Instituto de Inteligencia Artificial Centrada en el Humano, trabajó con expertos de la academia y la industria privada para recopilar información y predicciones al respecto. Como un esfuerzo anual (y por el tamaño del mismo, puede apostar que ya están trabajando arduamente para diseñar el próximo), puede que esta no sea la versión más fresca de la IA, pero estas amplias encuestas periódicas son importantes para mantener el dedo en el pulso de la industria.

El informe de este año incluye “un nuevo análisis de los modelos básicos, incluida su geopolítica y los costos de capacitación, el impacto ambiental de los sistemas de IA, la educación de IA de K-12 y las tendencias de la opinión pública en IA”, además de una mirada a la política en cien países nuevos.

Permítanos solo enumerar las conclusiones de más alto nivel:

- El desarrollo de la IA ha cambiado en la última década de liderado por la academia a liderado por la industria, por un amplio margen, y esto no muestra signos de cambio.

- Se está volviendo difícil probar modelos en puntos de referencia tradicionales y es posible que se necesite un nuevo paradigma aquí.

- La huella energética del entrenamiento y uso de la IA se está volviendo considerable, pero aún tenemos que ver cómo puede agregar eficiencias en otros lugares.

- El número de «incidentes y controversias de IA» se ha multiplicado por 26 desde 2012, lo que en realidad parece un poco bajo.

- Las habilidades relacionadas con la IA y las ofertas de trabajo están aumentando, pero no tan rápido como crees.

- Los formuladores de políticas, sin embargo, se están desmoronando tratando de redactar un proyecto de ley definitivo sobre IA, una tontería si alguna vez hubo una.

- La inversión se ha estancado temporalmente, pero eso es después de un aumento astronómico durante la última década.

- Más del 70% de los encuestados chinos, sauditas e indios sintieron que la IA tenía más beneficios que inconvenientes. americanos? 35%.

Pero el informe entra en detalles sobre muchos temas y subtemas y es bastante legible y no técnico. Solo los dedicados leerán las 386 páginas de análisis, pero en realidad, casi cualquier organismo motivado podría hacerlo.

Veamos el Capítulo 3, Ética técnica de la IA, con un poco más de detalle.

El sesgo y la toxicidad son difíciles de reducir a métricas, pero en la medida en que podamos definir y probar modelos para estas cosas, está claro que los modelos «sin filtrar» son mucho, mucho más fáciles de llevar a un territorio problemático. El ajuste de instrucciones, es decir, agregar una capa de preparación adicional (como un mensaje oculto) o pasar la salida del modelo a través de un segundo modelo mediador, es efectivo para mejorar este problema, pero está lejos de ser perfecto.

El aumento de «incidentes y controversias de IA» al que se alude en las viñetas se ilustra mejor con este diagrama:

Créditos de imagen: Universidad de Stanford

Como puede ver, la tendencia es al alza y estos números llegaron antes de la adopción generalizada de ChatGPT y otros modelos de lenguaje grandes, sin mencionar la gran mejora en los generadores de imágenes. Puede estar seguro de que el aumento de 26x es solo el comienzo.

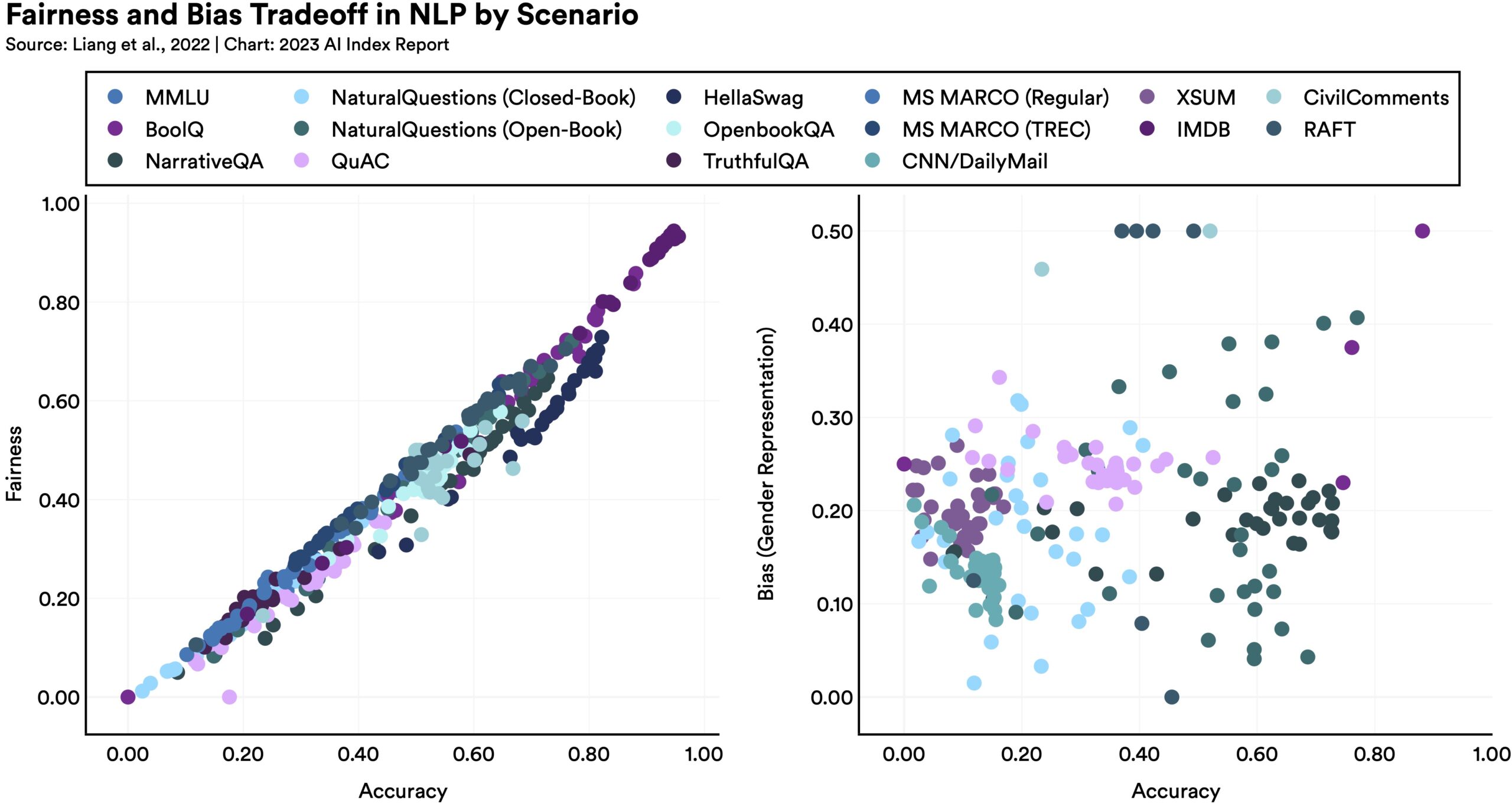

Hacer que los modelos sean más justos o imparciales de una manera puede tener consecuencias inesperadas en otras métricas, como muestra este diagrama:

Créditos de imagen: Universidad de Stanford

Como señala el informe, «los modelos de lenguaje que se desempeñan mejor en ciertos puntos de referencia de equidad tienden a tener peor sesgo de género». ¿Por qué? Es difícil decirlo, pero demuestra que la optimización no es tan simple como todos esperan. No existe una solución sencilla para mejorar estos grandes modelos, en parte porque no entendemos realmente cómo funcionan.

La verificación de hechos es uno de esos dominios que suena como un ajuste natural para la IA: habiendo indexado gran parte de la web, puede evaluar declaraciones y devolver la confianza de que están respaldadas por fuentes veraces, y así sucesivamente. Esto está muy lejos de ser el caso. La IA en realidad es particularmente mala para evaluar la factualidad y el riesgo no es tanto que sean verificadores poco confiables, sino que se conviertan en fuentes poderosas de información errónea convincente. Se han creado una serie de estudios y conjuntos de datos para probar y mejorar la verificación de hechos de IA, pero hasta ahora estamos más o menos donde comenzamos.

Afortunadamente, hay un gran aumento en el interés aquí, por la razón obvia de que si las personas sienten que no pueden confiar en la IA, toda la industria retrocede. Ha habido un tremendo aumento en las presentaciones en la Conferencia ACM sobre equidad, responsabilidad y transparencia, y en NeurIPS, temas como la equidad, la privacidad y la interpretabilidad están recibiendo más atención y tiempo en el escenario.

Estos mechas de mechas dejan mucho detalle sobre la mesa. Sin embargo, el equipo de HAI ha hecho un gran trabajo al organizar el contenido y, después de leer detenidamente el material de alto nivel aquí, puede descargar el documento completo y profundizar en cualquier tema que despierte su interés.