El viernes, un equipo de investigadores de la Universidad de Chicago publicó un artículo de investigación que describe «Nightshade», una técnica de envenenamiento de datos destinada a interrumpir el proceso de entrenamiento de modelos de IA, informan MIT Technology Review y VentureBeat. El objetivo es ayudar a los artistas visuales y editores a proteger su trabajo para que no se utilice para entrenar modelos generativos de síntesis de imágenes de IA, como Midjourney, DALL-E 3 y Stable Diffusion.

La herramienta de código abierto «píldora venenosa» (como la llama el departamento de prensa de la Universidad de Chicago) altera imágenes de maneras invisibles para el ojo humano que pueden corromper el proceso de entrenamiento de un modelo de IA. Muchos modelos de síntesis de imágenes, con notables excepciones de los de Adobe y Getty Images, utilizan en gran medida conjuntos de datos de imágenes extraídas de la web sin el permiso del artista, lo que incluye material protegido por derechos de autor. (OpenAI obtiene la licencia de algunas de sus imágenes de entrenamiento DALL-E de Shutterstock).

La dependencia de los investigadores de IA de datos obtenidos de la web, algo que muchos consideran ético, también ha sido clave para la reciente explosión de la capacidad generativa de la IA. Se necesitó toda una Internet de imágenes con anotaciones (a través de subtítulos, texto alternativo y metadatos) creadas por millones de personas para crear un conjunto de datos con suficiente variedad para crear Difusión Estable, por ejemplo. No sería práctico contratar personas para anotar cientos de millones de imágenes desde el punto de vista tanto del costo como del tiempo. Aquellos con acceso a grandes bases de datos de imágenes existentes (como Getty y Shutterstock) tienen ventaja al utilizar datos de capacitación con licencia.

Shan, et al.

En ese sentido, algunas instituciones de investigación, como la Biblioteca Berkeley de la Universidad de California, han abogado por preservar la extracción de datos como uso legítimo en el entrenamiento de IA con fines de investigación y educación. Los tribunales estadounidenses aún no se han pronunciado definitivamente sobre esta práctica y los reguladores están buscando comentarios sobre una posible legislación que podría afectarla de una forma u otra. Pero tal como lo ve el equipo de Nightshade, el uso para investigación y el uso comercial son dos cosas completamente diferentes, y esperan que su tecnología pueda obligar a las empresas de capacitación en IA a licenciar conjuntos de datos de imágenes, respetar las restricciones de los rastreadores y cumplir con las solicitudes de exclusión voluntaria.

«El objetivo de esta herramienta es equilibrar el campo de juego entre los formadores modelo y los creadores de contenido», dijo en un comunicado el coautor y profesor de la Universidad de Chicago, Ben Y. Zhao. «En este momento, los entrenadores modelo tienen el 100 por ciento del poder. Las únicas herramientas que pueden ralentizar a los rastreadores son las listas de exclusión voluntaria y las directivas de no rastreo, todas las cuales son opcionales y dependen de la conciencia de las empresas de IA y, por supuesto, «Nada de esto es verificable o ejecutable y las empresas pueden decir una cosa y hacer otra con impunidad. Esta herramienta sería la primera que permitiría a los propietarios de contenido luchar de manera significativa contra la capacitación de modelos no autorizados».

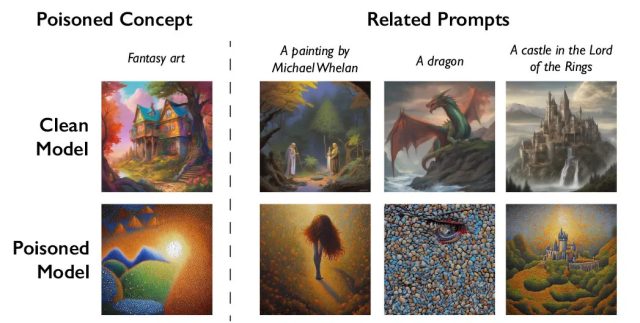

Shawn Shan, Wenxin Ding, Josephine Passananti, Haitao Zheng y Zhao desarrollaron Nightshade como parte del Departamento de Ciencias de la Computación de la Universidad de Chicago. La nueva herramienta se basa en el trabajo anterior del equipo con Glaze, otra herramienta diseñada para alterar obras de arte digitales de una manera que confunde a la IA. Mientras que Glaze está orientado a ofuscar el estilo de la obra de arte, Nightshade va un paso más allá al corromper los datos de entrenamiento. Básicamente, engaña a los modelos de IA para que identifiquen erróneamente objetos dentro de las imágenes.

Por ejemplo, en las pruebas, los investigadores utilizaron la herramienta para alterar imágenes de perros de una manera que llevó a un modelo de IA a generar un gato cuando se le pedía que produjera un perro. Para hacer esto, Nightshade toma una imagen del concepto previsto (por ejemplo, una imagen real de un «perro») y modifica sutilmente la imagen para que conserve su apariencia original pero esté influenciada en el espacio latente (codificado) por un concepto completamente diferente. (por ejemplo, «gato»). De esta manera, ante una verificación humana o simple automatizada, la imagen y el texto parecen alineados. Pero en el espacio latente del modelo, la imagen tiene características tanto del concepto original como del concepto de veneno, lo que desvía al modelo cuando se entrena con los datos.