La privacidad es una preocupación obvia ahora que todo desde smartphones a relojes inteligentes incluso gafas inteligentes posee cámaras incorporadas. Prohibir las cámaras encubiertas nunca sucederá, y alterar imágenes digitalmente por razones de privacidad es un verdadero dolor. So, investigadores de la UCLA están trabajando en cambio en un radical nuevo tipo de cámara que puede selectivamente capturar o ignorar objetos específicos en el marco antes de que estén grabado.

Si alguna vez ha visto un programa de noticias de investigación que protege la identidad de una fuente desdibujando o pixelando sus rasgos faciales, entonces ya está familiarizado con uno de los muchos métodos que ya usamos para preservar la privacidad. Otros enfoques incluyen el cifrado de medios confidenciales o técnicas de procesamiento más avanzadas que borre digitalmente parte de una foto usando herramientas como Photoshop. hay además algoritmos automatizados, que servicios como Google Maps utilizan para desenfocar rostros y matrículas en miles de millones de fotos.

Sin embargo, todos esos son métodos de procesamiento posterior que ocurren después de que una imagen digital ha sido capturada y almacenada. Las imágenes originales sin procesar que potencialmente contienen datos privados aún existen y aún podrían estar expuesto, algo que hemos visto suceder una y otra vez, razón por la cual los investigadores de UCLA querían abordar las preocupaciones de privacidad en la fuente: cuando la luz entra en una cámara, pero antes de que toque el sensor de imagen.

Los fabricantes de cámaras podrían potencialmente lanzar actualizaciones de firmware con herramientas impulsadas por IA que, por ejemplo, podrían usarse para borrar selectivamente a personas específicas de una foto. Pero eso requiere un nivel de potencia de procesamiento que incluso una cámara digital de gama alta podría no tener, por lo que los investigadores de la UCLA abordaron el problema ópticamente, a través de una técnica que denominan «computación difractiva», como se detalla en un artículo publicado recientemente.

G/O Media puede recibir una comisión

De vuelta a la escuela

Mes de regreso a clases con Govee Sale

Decora tu dormitorio

Es posible que no se te permita pintar las paredes de tu dormitorio cuando regreses a la escuela, ¡pero nadie puede impedir que las pintes con luz! Govee tiene un montón de diferentes luces inteligentes RGB a la venta solo para la ocasión a medida que se acerca la primera semana de clases.

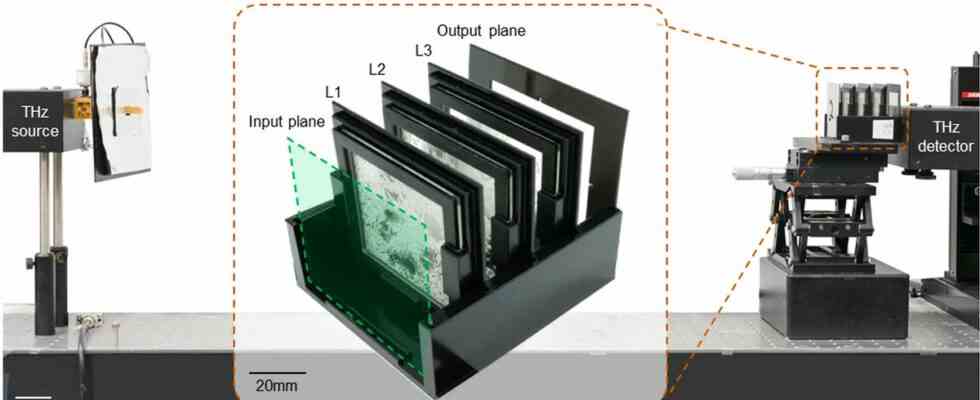

Incluso si está bien versado en fotografía, esta cámara adopta un enfoque radicalmente diferente para capturar imágenes. Los investigadores comenzaron con un objeto deseado que querían grabar, en este caso, un par de números dos muy simples en blanco y negro, escritos a mano, y lo usaron para entrenar una herramienta de diseño basada en el aprendizaje profundo que genera una serie de difracción. capas que se pueden imprimir en 3D y ensamblar en serie para crear un «generador de imágenes computacional» que se encuentra frente a un «plano de salida,” donde se captura la imagen final.

Cada capa presenta decenas de miles de características difractivas microscópicas que están diseñadas específicamente para permitir que la luz que coincide con los objetos deseados pase sin verse afectada, mientras que la luz de otros objetos se difracta y se borra ópticamente en patrones sin sentido y de baja intensidad que parecen aleatorios. ruido. Esto significa la imagen que realmente se captura al final no se puede aplicar ingeniería inversa para extrapolar lo que se eliminó.

Como probablemente puedas imaginar, las aplicaciones prácticas de este enfoque radicalmente diferente de la fotografía son increíblemente limitadas en este momento. No verás una función de «no capturar al tío Bill» agregada a la aplicación de la cámara del iPhone en el corto plazo.. Pero la investigación ofrece algunos beneficios impresionantes sobre técnicas actuales. El ‘procesamiento de imágenes’ no solo ocurre literalmente a la velocidad de la luz, ya que es completamente óptico y analógico, pero el diseño de las capas difractivas también podría introducir el cifrado óptico, ocultando detalles en una foto que solo se puede revelar usando una clave de descifrado que muestra cómo se puede recuperar la imagen original.