Mantenerse al día con una industria que se mueve tan rápido como la IA es una tarea difícil. Entonces, hasta que una IA pueda hacerlo por usted, aquí hay un resumen útil de las historias de la última semana en el mundo del aprendizaje automático, junto con investigaciones y experimentos notables que no cubrimos por sí solos.

Esta semana, Google dominó el ciclo de noticias de IA con una gama de nuevos productos que se lanzaron en su conferencia anual de desarrolladores de E/S. Van desde una IA generadora de código destinada a competir con Copilot de GitHub hasta un generador de música de IA que convierte las indicaciones de texto en canciones cortas.

Una buena cantidad de estas herramientas parecen ser ahorradores de mano de obra legítimos, más que pelusa de marketing, es decir. Estoy particularmente intrigado por Project Tailwind, una aplicación para tomar notas que aprovecha la IA para organizar, resumir y analizar archivos de una carpeta personal de Google Docs. Pero también exponen las limitaciones y deficiencias de incluso las mejores tecnologías de inteligencia artificial de la actualidad.

Tome PaLM 2, por ejemplo, el modelo de lenguaje grande (LLM) más nuevo de Google. PaLM 2 impulsará la herramienta de chat Bard actualizada de Google, el competidor de la compañía para ChatGPT de OpenAI, y funcionará como el modelo base para la mayoría de las nuevas funciones de IA de Google. Pero mientras PaLM 2 puede escribir código, correos electrónicos y más, como LLM comparables, también responde a las preguntas de manera tóxica y sesgada.

El generador de música de Google también está bastante limitado en lo que puede lograr. Como escribí en mis manos, la mayoría de las canciones que he creado con MusicLM suenan aceptables en el mejor de los casos, y en el peor, como un niño de cuatro años suelto en un DAW.

Se ha escrito mucho sobre cómo la IA reemplazará los trabajos, potencialmente el equivalente a 300 millones de trabajos de tiempo completo, según un informe de Goldman Sachs. En una encuesta realizada por Harris, el 40 % de los trabajadores familiarizados con ChatGPT, la herramienta de chatbot impulsada por IA de OpenAI, están preocupados de que reemplace sus trabajos por completo.

La IA de Google no es el final de todo. De hecho, podría decirse que la compañía está atrasada en la carrera de IA. Pero es un hecho innegable que Google emplea a algunos de los mejores investigadores de inteligencia artificial del mundo. Y si esto es lo mejor que pueden manejar, es un testimonio del hecho de que la IA está lejos de ser un problema resuelto.

Aquí están los otros titulares de AI de nota de los últimos días:

- Meta trae IA generativa a los anuncios: Esta semana, Meta anunció una especie de caja de arena de IA para que los anunciantes los ayuden a crear copias alternativas, generación de fondo a través de indicaciones de texto y recorte de imágenes para anuncios de Facebook o Instagram. La compañía dijo que las funciones están disponibles para anunciantes selectos en este momento y ampliará el acceso a más anunciantes en julio.

- Contexto añadido: Anthropic ha ampliado la ventana de contexto para Claude, su modelo de IA de generación de texto insignia, aún en versión preliminar, de 9000 tokens a 100 000 tokens. La ventana de contexto se refiere al texto que el modelo considera antes de generar texto adicional, mientras que los tokens representan texto sin procesar (p. ej., la palabra «fantástico» se dividiría en los tokens «fan», «tas» y «tic»). Históricamente e incluso hoy, la mala memoria ha sido un impedimento para la utilidad de la IA generadora de texto. Pero las ventanas de contexto más grandes podrían cambiar eso.

- Anthropic promociona la ‘IA constitucional’: Las ventanas de contexto más grandes no son el único diferenciador de los modelos antrópicos. Esta semana, la compañía detalló la «IA constitucional», su técnica interna de capacitación en IA que tiene como objetivo imbuir a los sistemas de IA con «valores» definidos por una «constitución». A diferencia de otros enfoques, Anthropic argumenta que la IA constitucional hace que el comportamiento de los sistemas sea más fácil de entender y más simple de ajustar según sea necesario.

- Un LLM creado para la investigación: El Allen Institute for AI Research (AI2), una organización sin fines de lucro, anunció que planea capacitar a un LLM centrado en la investigación llamado Open Language Model, que se suma a la gran y creciente biblioteca de código abierto. AI2 ve el Modelo de lenguaje abierto, o OLMo para abreviar, como una plataforma y no solo como un modelo, que permitirá a la comunidad de investigación tomar cada componente que crea AI2 y usarlo ellos mismos o buscar mejorarlo.

- Nuevo fondo para IA: En otras noticias de AI2, AI2 Incubator, el fondo de inicio de IA de la organización sin fines de lucro, se está acelerando nuevamente a tres veces su tamaño anterior: $ 30 millones frente a $ 10 millones. Veintiuna empresas han pasado por la incubadora desde 2017, atrayendo unos 160 millones de dólares en inversiones adicionales y al menos una adquisición importante: XNOR, un equipo de eficiencia y aceleración de IA que Apple adquirió posteriormente por unos 200 millones de dólares.

- La UE introduce reglas para la IA generativa: En una serie de votaciones en el Parlamento Europeo, los eurodiputados respaldaron esta semana una serie de enmiendas al proyecto de ley de IA del bloque, incluido el establecimiento de requisitos para los llamados modelos fundamentales que sustentan las tecnologías de IA generativa como ChatGPT de OpenAI. Las enmiendas imponen a los proveedores de modelos básicos la responsabilidad de aplicar controles de seguridad, medidas de gobernanza de datos y mitigaciones de riesgos antes de poner sus modelos en el mercado.

- Un traductor universal: Google está probando un nuevo y poderoso servicio de traducción que reduce el video en un nuevo idioma y al mismo tiempo sincroniza los labios del hablante con palabras que nunca dijo. Podría ser muy útil por muchas razones, pero la empresa fue sincera sobre la posibilidad de abuso y las medidas adoptadas para evitarlo.

- Explicaciones automatizadas: A menudo se dice que los LLM en la línea de ChatGPT de OpenAI son una caja negra, y ciertamente, hay algo de verdad en eso. En un esfuerzo por despegar sus capas, OpenAI está desarrollando una herramienta para identificar automáticamente qué partes de un LLM son responsables de cuál de sus comportamientos. Los ingenieros detrás de él enfatizan que está en las primeras etapas, pero el código para ejecutarlo está disponible en código abierto en GitHub a partir de esta semana.

- IBM lanza nuevos servicios de IA: En su conferencia anual Think, IBM anunció IBM Watsonx, una nueva plataforma que ofrece herramientas para construir modelos de IA y brinda acceso a modelos previamente entrenados para generar código de computadora, texto y más. La compañía dice que el lanzamiento estuvo motivado por los desafíos que muchas empresas aún experimentan al implementar IA en el lugar de trabajo.

Otros aprendizajes automáticos

Créditos de imagen: IA de aterrizaje

Landing AI, la nueva compañía de Andrew Ng, está adoptando un enfoque más intuitivo para crear entrenamiento de visión por computadora. Hacer que un modelo entienda lo que quieres identificar en las imágenes es bastante minucioso, pero su técnica de «indicación visual» te permite hacer unas pocas pinceladas y descubre tu intención a partir de ahí. Cualquiera que tenga que construir modelos de segmentación está diciendo «¡Dios mío, por fin!» Probablemente muchos estudiantes de posgrado que actualmente pasan horas enmascarando orgánulos y objetos domésticos.

Microsoft ha aplicado modelos de difusión de una manera única e interesante, usándolos esencialmente para generar un vector de acción en lugar de una imagen, habiéndolo entrenado en muchas acciones humanas observadas. Todavía es muy temprano y la difusión no es la solución obvia para esto, pero como son estables y versátiles, es interesante ver cómo se pueden aplicar más allá de las tareas puramente visuales. Su artículo se presentará en ICLR a finales de este año.

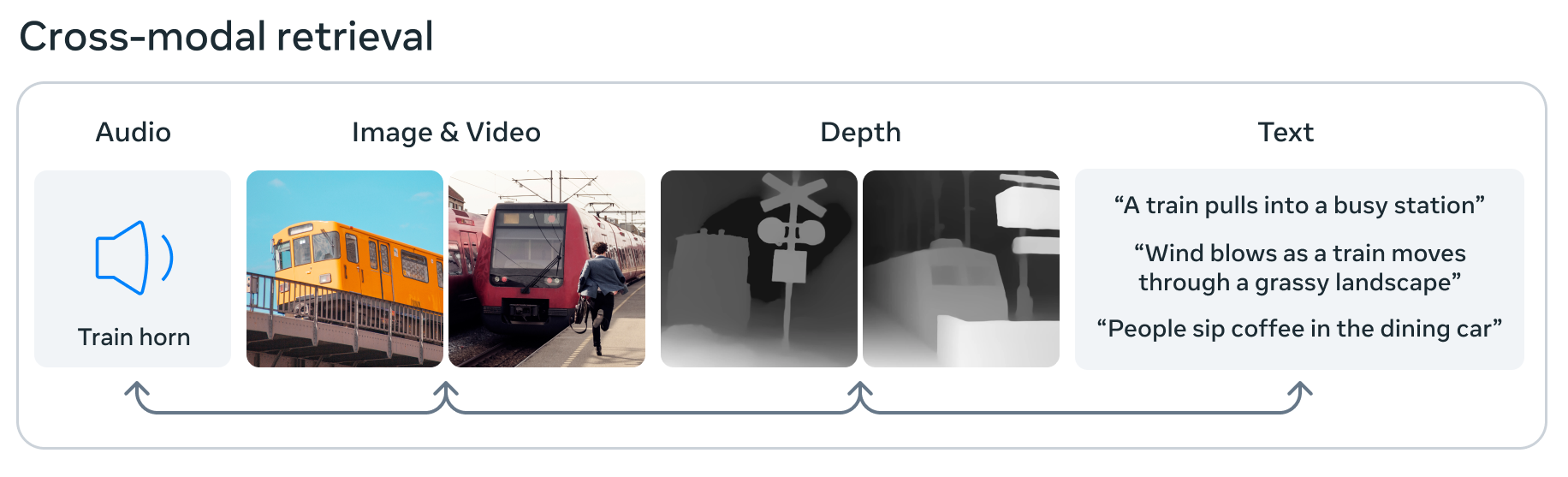

Créditos de imagen: Meta

Meta también está empujando los límites de la IA con ImageBind, que afirma es el primer modelo que puede procesar e integrar datos de seis modalidades diferentes: imágenes y video, audio, datos de profundidad 3D, información térmica y datos de movimiento o posición. Esto significa que en su pequeño espacio de incrustación de aprendizaje automático, una imagen puede asociarse con un sonido, una forma 3D y varias descripciones de texto, cualquiera de las cuales puede ser consultada o utilizada para tomar una decisión. Es un paso hacia la IA «general» en el sentido de que absorbe y asocia datos más como el cerebro, pero aún es básico y experimental, así que no te emociones demasiado todavía.

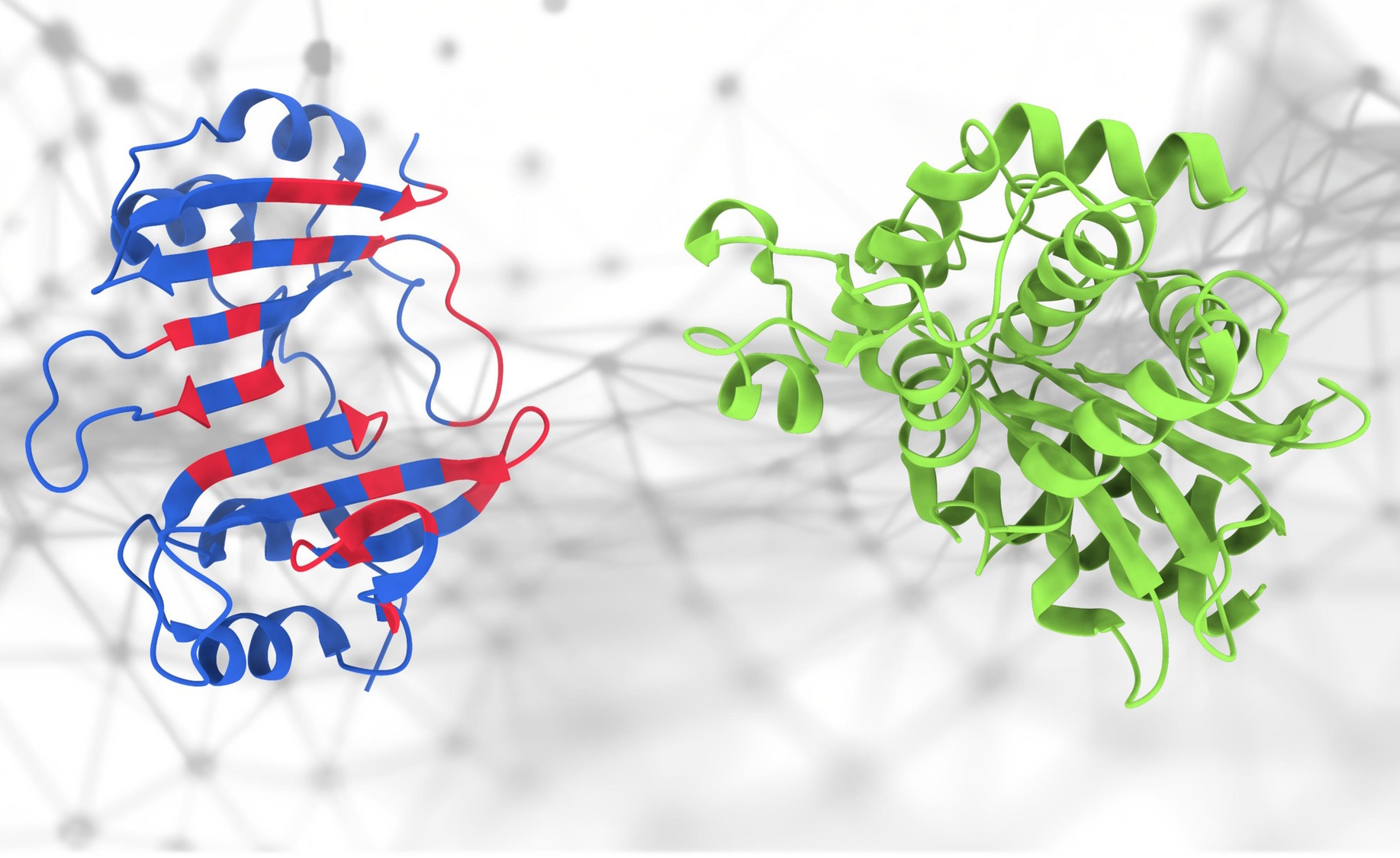

Si estas proteínas se tocan… ¿qué pasa?

Todo el mundo se entusiasmó con AlphaFold, y por una buena razón, pero en realidad la estructura es solo una pequeña parte de la compleja ciencia de la proteómica. La forma en que interactúan esas proteínas es importante y difícil de predecir, pero este nuevo modelo PeSTo de EPFL intenta hacer precisamente eso. “Se enfoca en átomos e interacciones importantes dentro de la estructura de la proteína”, dijo el desarrollador principal Lucien Krapp. «Significa que este método captura de manera efectiva las interacciones complejas dentro de las estructuras de proteínas para permitir una predicción precisa de las interfaces de unión de proteínas». Aunque no sea exacto o 100% fiable, no tener que empezar de cero es muy útil para los investigadores.

Los federales se están volviendo locos con la IA. El presidente incluso se presentó en una reunión con un grupo de los principales directores ejecutivos de IA para decir lo importante que es hacer esto bien. Tal vez un grupo de corporaciones no sean necesariamente las adecuadas para preguntar, pero al menos tendrán algunas ideas que vale la pena considerar. Pero ya tienen cabilderos, ¿no?

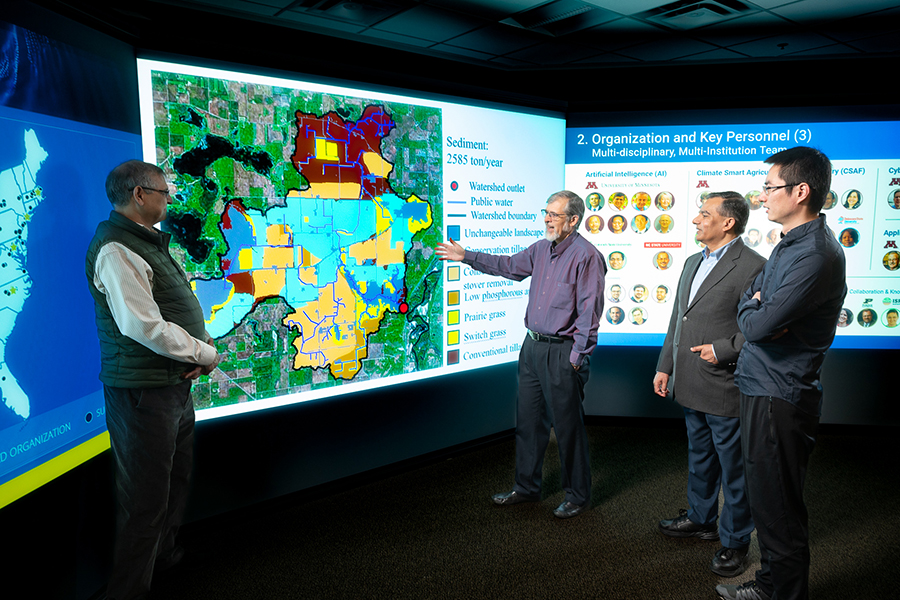

Estoy más entusiasmado con la aparición de nuevos centros de investigación de IA con fondos federales. La investigación básica es muy necesaria para contrarrestar el trabajo centrado en el producto que realizan empresas como OpenAI y Google, por lo que cuando tiene centros de IA con mandatos para investigar cosas como las ciencias sociales (en CMU) o el cambio climático y la agricultura (en U of Minnesota), se siente como campos verdes (tanto en sentido figurado como literal). Aunque también quiero dar un pequeño reconocimiento a esta investigación de Meta sobre medición forestal.

Hacer IA juntos en una pantalla grande: ¡es ciencia!

Hay muchas conversaciones interesantes sobre la IA. Pensé que esta entrevista con los académicos de UCLA (mi alma mater, go Bruins) Jacob Foster y Danny Snelson fue interesante. Aquí hay una gran idea sobre los LLM para fingir que se te ocurrió este fin de semana cuando la gente habla de IA:

Estos sistemas revelan cuán formalmente consistente es la mayoría de la escritura. Cuanto más genéricos sean los formatos que simulan estos modelos predictivos, más exitosos son. Estos desarrollos nos empujan a reconocer las funciones normativas de nuestras formas y potencialmente transformarlas. Después de la introducción de la fotografía, que es muy buena para capturar un espacio de representación, el entorno pictórico desarrolló el impresionismo, un estilo que rechazó por completo la representación precisa para quedarse con la materialidad de la pintura misma.

¡Definitivamente usando eso!