Las CPU Xeon de 4.ª generación de Intel con nombre en código Sapphire Rapids han logrado una mejora del rendimiento de hasta 10 veces en AI Stable Diffusion gracias a AMX.

Intel aumenta el rendimiento de difusión estable de IA con aceleración AMX en CPU Xeon Sapphire Rapids de cuarta generación

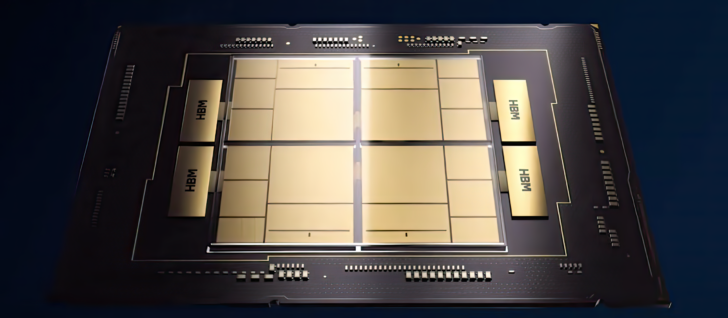

Las CPU Intel 4th Gen Xeon «Sapphire Rapids» lanzadas recientemente han visto una adopción acelerada en el segmento de la nube y el centro de datos. Una de las áreas clave en las que Intel ha puesto un esfuerzo adicional es su conjunto de características de hardware para la aceleración del aprendizaje profundo, que se potencia con los nuevos aceleradores AMX (Advanced Matrix Extension).

Intel primero muestra la latencia promedio entre las CPU Sapphire Rapids de generación actual y las CPU Ice Lake de última generación. Las CPU Xeon de 3.ª generación requieren alrededor de 45 segundos para ejecutar un código, mientras que las CPU de 4.ª generación tardan 32,3 segundos. Esta es una latencia un 28 % más baja sin ningún cambio en el código. Entonces, ¿qué pasaría si Intel usara un conjunto de herramientas optimizado y de código abierto para la inferencia de alto rendimiento como OpenVINO?

¡La respuesta es aún más aceleración en el rendimiento! Con Optimum Intel y OpenVino, las CPU Intel Xeon reducen la latencia a 16,7 segundos, una aceleración de más del doble. La optimización adicional del código a una resolución fija reduce la latencia a solo 4,7 segundos, lo que marca una aceleración de 3,5 a 3,8 veces con respecto al código intacto.

Con una forma estática, la latencia promedio se reduce a 4,7 segundosuna aceleración adicional de 3.5x.

Como puede ver, OpenVINO es una forma simple y eficiente de acelerar la inferencia de difusión estable. Cuando se combina con una CPU Sapphire Rapids, ofrece una aceleración de casi 10 veces en comparación con la inferencia de vainilla en Ice Lake Xeons.

Si no puede o no quiere usar OpenVINO, el resto de esta publicación le mostrará una serie de otras técnicas de optimización. ¡Abroche el cinturón de seguridad!

También habilitamos la

bloat16formato de datos para aprovechar el acelerador AMX de la unidad de multiplicación de matriz de mosaicos (TMMU) presente en las CPU Sapphire Rapids.Con esta versión actualizada, la latencia de inferencia se reduce aún más de 11,9 segundos a 5,4 segundos. Eso es más de 2x de aceleración gracias a IPEX y AMX.

Con esta versión final, la latencia de inferencia ahora se reduce a 5,05 segundos. En comparación con nuestra referencia inicial de Sapphire Rapids (32,3 segundos), ¡esto es casi 6,5 veces más rápido!

a través de Intel

Otras optimizaciones a nivel de sistema, IPEX y BF16 aportan aún más rendimiento a la mesa y los resultados se pueden ver en el gráfico proporcionado por Intel:

Las CPU Sapphire Rapids Xeon de Intel están actualmente disponibles para una vista previa en las instancias Amazon EC2 R7iz, puede registrarse aquí para acceder y ver las ventajas que la familia de CPU de 4.ª generación trae a la mesa. Con Stable Diffusion y modelos de IA similares cada vez más populares, se puede ver por qué las CPU de Intel se convertirán en una opción popular en este segmento.