OpenAI, la startup de inteligencia artificial fundada por Elon Musk detrás del popular generador de texto a imagen DALL-E, anunció el martes el lanzamiento de su nueva máquina de creación de imágenes POINT-E, que puede producir nubes de puntos 3D directamente desde mensajes de texto. Mientras que los sistemas existentes como DreamFusion de Google generalmente requieren varias horas y GPU para generar sus imágenes, Point-E solo necesita una GPU y uno o dos minutos.

IA abierta

El modelado 3D se utiliza en una variedad de industrias y aplicaciones. Los efectos CGI de los éxitos de taquilla de las películas modernas, los videojuegos, la realidad virtual y la realidad aumentada, las misiones de mapeo de cráteres lunares de la NASA, los proyectos de preservación de sitios patrimoniales de Google y la visión de Meta para Metaverse dependen de las capacidades de modelado 3D. Sin embargo, la creación de imágenes 3D fotorrealistas sigue siendo un proceso que consume mucho tiempo y recursos, a pesar del trabajo de NVIDIA para automatizar la generación de objetos y la aplicación móvil RealityCapture de Epic Game, que permite a cualquier persona con un teléfono iOS escanear objetos del mundo real como imágenes 3D.

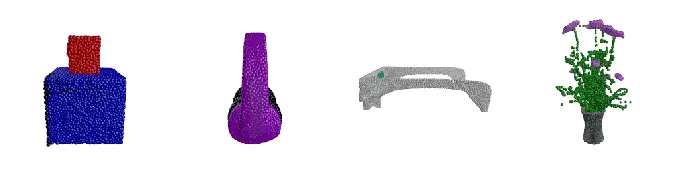

Los sistemas de texto a imagen como DALL-E 2 y Craiyon de OpenAI, DeepAI, Lensa de Prisma Lab o Stable Diffusion de HuggingFace han ganado rápidamente popularidad, notoriedad e infamia en los últimos años. Text-to-3D es una rama de esa investigación. Point-E, a diferencia de sistemas similares, «aprovecha un gran corpus de pares (texto, imagen), lo que le permite seguir indicaciones diversas y complejas, mientras que nuestro modelo de imagen a 3D se entrena en un conjunto de datos más pequeño de (imagen, 3D) pares», escribió el equipo de investigación de OpenAI dirigido por Alex Nichol en Point·E: A System for Generating 3D Point Clouds from Complex Prompts, publicado la semana pasada. «Para producir un objeto 3D a partir de un mensaje de texto, primero muestreamos una imagen utilizando el modelo de texto a imagen y luego muestreamos un objeto 3D condicionado a la imagen muestreada. Ambos pasos se pueden realizar en varios segundos, y no requieren costosos procedimientos de optimización».

IA abierta

Si tuviera que ingresar un mensaje de texto, por ejemplo, «Un gato comiendo un burrito», Point-E primero generará una representación 3D de vista sintética de dicho gato comiendo burrito. Luego, ejecutará esa imagen generada a través de una serie de modelos de difusión para crear la nube de puntos RGB 3D de la imagen inicial, produciendo primero un modelo de nube grueso de 1024 puntos, luego uno más fino de 4096 puntos. “En la práctica, asumimos que la imagen contiene la información relevante del texto y no condicionamos explícitamente las nubes de puntos en el texto”, señala el equipo de investigación.

Cada uno de estos modelos de difusión se entrenó en «millones» de modelos 3D, todos convertidos a un formato estandarizado. «Si bien nuestro método funciona peor en esta evaluación que las técnicas más modernas», reconoce el equipo, «produce muestras en una pequeña fracción del tiempo». Si desea probarlo usted mismo, OpenAI ha publicado el código fuente abierto del proyecto en Github.

Todos los productos recomendados por Engadget son seleccionados por nuestro equipo editorial, independiente de nuestra empresa matriz. Algunas de nuestras historias incluyen enlaces de afiliados. Si compra algo a través de uno de estos enlaces, podemos ganar una comisión de afiliado. Todos los precios son correctos en el momento de la publicación.