De la misma manera que las empresas adaptan su software para ejecutarlo en diferentes sistemas operativos de escritorio, móviles y en la nube, las empresas también necesitan configurar su software para la rápida revolución de la IA, donde han surgido grandes modelos de lenguaje (LLM) para servir nuevas y poderosas tecnologías. Aplicaciones de IA capaces de interpretar y generar texto en lenguaje humano.

Si bien una empresa ya puede crear una «instancia LLM» de su software basándose en su documentación API actual, el problema es que necesita asegurarse de que el ecosistema LLM más amplio pueda usarlo correctamente y obtener suficiente visibilidad de qué tan bien esta instancia de su producto realmente funciona en la naturaleza.

Y eso, efectivamente, es lo que Tidalflow se propone resolver, con una plataforma de extremo a extremo que permite a los desarrolladores hacer que su software existente funcione bien con el ecosistema LLM. La incipiente startup está emergiendo del sigilo hoy con $ 1,7 millones en una ronda de financiación codirigida por Gradient Ventures de Google junto con Dig Ventures, una firma de capital de riesgo creada por el fundador de MuleSoft, Ross Mason, con la participación de Antler.

Confianza

Considere este escenario hipotético: una plataforma de viajes en línea decide que quiere adoptar chatbots habilitados para LLM, como ChatGPT y Bard de Google, permitiendo a sus clientes solicitar tarifas aéreas y reservar boletos a través de indicaciones en lenguaje natural en un motor de búsqueda. Entonces, la compañía crea una instancia de LLM para cada uno, pero por lo que saben, el 2% de los resultados de ChatGPT muestran un destino que el cliente no solicitó, una tasa de error que podría ser aún mayor en Bard: es simplemente imposible. estar seguro.

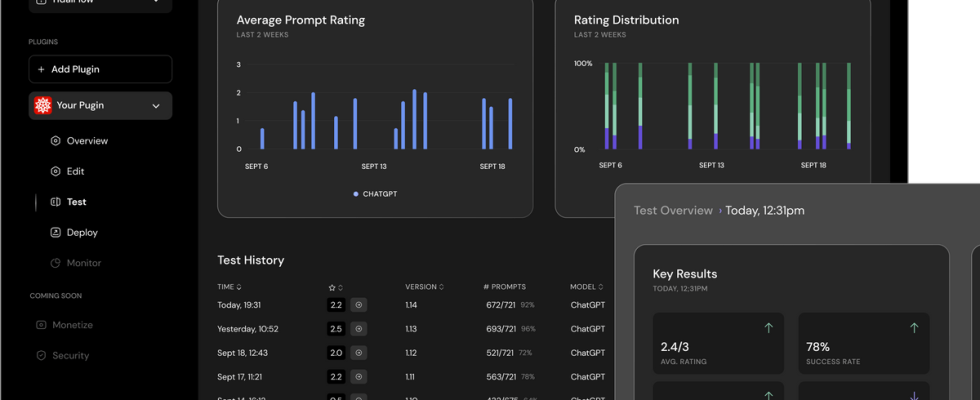

Ahora bien, si una empresa tiene una tolerancia a fallos inferior al 1%, es posible que se sienta más segura. no siguiendo la ruta de la IA generativa hasta que tengan una mayor claridad sobre cómo se está desempeñando realmente su instancia de LLM. Aquí es donde Tidalflow entra en escena, con módulos que ayudan a las empresas no solo a crear su instancia LLM, sino también a probarla, implementarla, monitorearla, protegerla y, eventualmente, monetizarla. También pueden ajustar la instancia LLM de su producto para cada ecosistema en un entorno de pruebas local simulado, hasta que lleguen a una solución que cumpla con algo que se adapte a su umbral de tolerancia a fallas.

«El gran problema es que, si inicias algo como ChatGPT, en realidad no sabes cómo interactúan los usuarios con él», dijo a TechCrunch el director ejecutivo de Tidalflow, Sebastian Jorna. “Esta falta de confianza en la confiabilidad de su software es un obstáculo importante para implementar herramientas de software en los ecosistemas LLM. El módulo de prueba y simulación de Tidalflow genera esa confianza”.

Tidalflow quizás pueda describirse mejor como una plataforma de gestión del ciclo de vida de las aplicaciones (ALM) a la que las empresas conectan su especificación/documentación OpenAPI. Y en el otro extremo, Tidalflow escupe una «instancia LLM probada en batalla» de ese producto, con el front-end ofreciendo monitoreo y observabilidad de cómo se desempeñará esa instancia LLM en la naturaleza.

«Con las pruebas de software normales, tienes un número específico de casos que analizas, y si funciona, bueno, el software funciona», dijo Jorna. “Ahora, debido a que estamos en este entorno estocástico, en realidad es necesario agregarle mucho volumen para obtener alguna significancia estadística. Y eso es básicamente lo que hacemos en nuestro módulo de prueba y simulación, donde simulamos como si el producto ya estuviera activo y cómo los usuarios potenciales podrían usarlo”.

Panel de control de flujo de mareas. Créditos de imagen: flujo de marea

En resumen, Tidalflow permite a las empresas analizar innumerables casos extremos que pueden o no romper su nueva y sofisticada inteligencia generativa de IA. Esto será particularmente importante para las empresas más grandes donde los riesgos de comprometer la confiabilidad del software son simplemente demasiado grandes.

«Los clientes empresariales más grandes simplemente no pueden arriesgarse a publicar algo sin la confianza de que funciona», añadió Jorna.

Fundación a la financiación

Coen Stevens (CTO), Sebastian Jorna (CEO) y Henry Wynaendts (CPO) de Tidalflow. Créditos de imagen: flujo de marea

Tidalflow cumple oficialmente tres meses y los fundadores Jorna (CEO) y Coen Stevens (CTO) se reunieron a través del programa de emprendedores residentes de Antler en Ámsterdam. «Una vez que comenzó el programa oficial en el verano, Tidalflow se convirtió en la empresa más rápida en la historia de Antler Holanda en obtener financiación», dijo Jorna.

Hoy, Tidalflow cuenta con un equipo de tres personas, incluidos sus dos cofundadores y director de producto (CPO), Henry Wynaendts. Pero con una nueva financiación de 1,7 millones de dólares, Jorna dijo que la empresa ahora está buscando activamente reclutar para varios roles de ingeniería de front-end y back-end mientras trabajan hacia un lanzamiento comercial completo.

Pero al menos, el rápido paso de la fundación a la financiación es indicativo de la actual fiebre del oro generativa de la IA. Con ChatGPT obteniendo una API y soporte para complementos de terceros, Google en camino de hacer lo mismo para el ecosistema Bard y Microsoft incorporando su asistente Copilot AI en Microsoft 365, las empresas y los desarrolladores tienen una gran oportunidad no solo de aprovechar la IA generativa para sus propios productos, pero llegan a una gran cantidad de usuarios en el proceso.

«Al igual que el iPhone marcó el comienzo de una nueva era para el software compatible con dispositivos móviles en 2007, ahora estamos en un punto de inflexión similar, es decir, en el que el software se vuelve compatible con LLM», señaló Jorna.

Tidalflow permanecerá en versión beta cerrada por ahora, con planes de lanzarse comercialmente al público a finales de 2023.