Los modelos de lenguajes grandes (LLM) consumen excepcionalmente muchos recursos de CPU y memoria, pero se dice que Apple está experimentando con el almacenamiento de esta tecnología en almacenamiento flash, lo que probablemente la hará fácilmente accesible en múltiples dispositivos. Sin embargo, el gigante tecnológico también desea que los LLM sean omnipresentes en su línea de iPhone y Mac y está explorando formas de hacerlo posible.

Almacenar LLM en la memoria flash ha sido difícil; Apple pretende solucionar este problema en máquinas con capacidad limitada

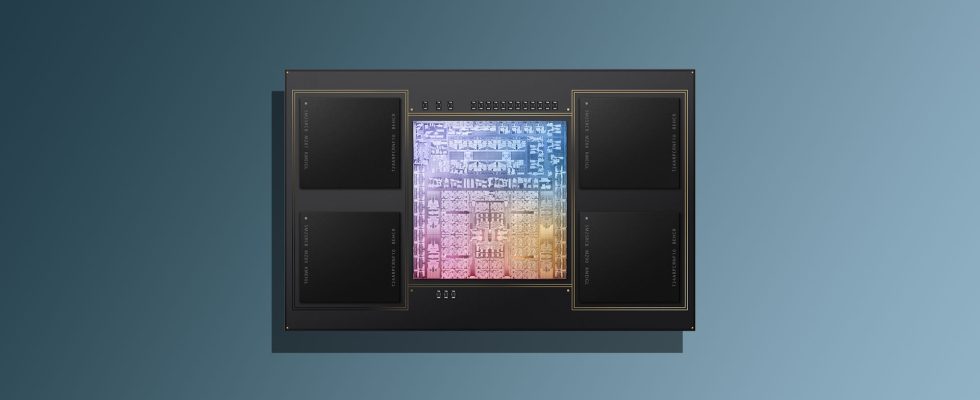

En condiciones típicas, los modelos de lenguajes grandes requieren aceleradores de IA y una alta capacidad de DRAM para almacenarse. Según lo informado por TechPowerUp, Apple está trabajando para llevar la misma tecnología, pero a dispositivos con capacidad de memoria limitada. En un artículo recientemente publicado, Apple publicó un artículo que tiene como objetivo llevar los LLM a dispositivos con capacidad de memoria limitada. Los iPhone también tienen memoria limitada, por lo que los investigadores de Apple han desarrollado una técnica que utiliza chips flash para almacenar los datos del modelo de IA.

Dado que la memoria flash está disponible en abundancia en los iPhone y computadoras Mac de Apple, existe una manera de evitar esta limitación con una técnica llamada ventanas. En este método, el modelo de IA reutiliza algunos de los datos que ya ha procesado, lo que reduce la necesidad de búsqueda continua de memoria y acelera todo el proceso. La segunda técnica es Agrupación de filas y columnas; Los datos se pueden agrupar de manera más eficiente, lo que permite que el modelo de IA lea datos de la memoria flash más rápido y acelere su capacidad de comprensión.

Ambas técnicas y otros métodos permitirán que los modelos de IA ejecuten hasta el doble del tamaño de la RAM disponible del iPhone, lo que resultará en un aumento de velocidad hasta 5 veces en procesadores estándar y hasta 25 veces más rápido en procesadores gráficos. Hay mucha evidencia que sugiere que Apple se toma en serio la IA, comenzando con su propio chatbot, que internamente se llama Apple GPT. También se rumorea que el iPhone 16 del próximo año contará con micrófonos mejorados, lo que será costoso para la empresa pero permitirá una entrada de voz mejorada, que será necesaria para permitir que Siri realice una multitud de tareas.

También se rumorea que alguna forma de IA generativa se incorporará a iOS 18 cuando llegue oficialmente el próximo año, por lo que, si bien Apple ha estado detrás de empresas como OpenAI, Google, Amazon y otros, esa brecha podría disminuir considerablemente en 2024. , llevar esta tecnología a iPhones, iPads y Mac con memoria limitada podría darles a estos dispositivos un punto de venta único, pero primero tendremos que ver cómo funcionan los LLM almacenados en memoria flash.