Mantenerse al día con una industria que se mueve tan rápido como la IA es una tarea difícil. Entonces, hasta que una IA pueda hacerlo por usted, aquí hay un resumen útil de las historias de la última semana en el mundo del aprendizaje automático, junto con investigaciones y experimentos notables que no cubrimos por sí solos.

Si aún no era obvio, el panorama competitivo en IA, particularmente el subcampo conocido como IA generativa, está al rojo vivo. Y se está poniendo más caliente. Esta semana, Dropbox lanzó su primer fondo de riesgo corporativo, Dropbox Ventures, que, según la compañía, se centrará en las nuevas empresas que crean productos impulsados por IA que «dan forma al futuro del trabajo». Para no quedarse atrás, AWS presentó un programa de 100 millones de dólares para financiar iniciativas de IA generativa encabezadas por sus socios y clientes.

Se está gastando mucho dinero en el espacio de la IA, sin duda. Salesforce Ventures, la división de capital de riesgo de Salesforce, planea invertir $ 500 millones en nuevas empresas que desarrollan tecnologías de inteligencia artificial generativa. Workday agregó recientemente $ 250 millones a su fondo de capital de riesgo existente específicamente para respaldar las nuevas empresas de inteligencia artificial y aprendizaje automático. Y Accenture y PwC han anunciado que planean invertir $ 3 mil millones y $ 1 mil millones, respectivamente, en IA.

Pero uno se pregunta si el dinero es la solución a los desafíos pendientes del campo de la IA.

En un panel esclarecedor durante una conferencia de Bloomberg en San Francisco esta semana, Meredith Whittaker, presidenta de la aplicación de mensajería segura Signal, argumentó que la tecnología que sustenta algunas de las aplicaciones de inteligencia artificial más populares de la actualidad se está volviendo peligrosamente opaca. Ella dio un ejemplo de alguien que entra a un banco y pide un préstamo.

A esa persona se le puede negar el préstamo y «no tener idea de que hay un sistema en [the] probablemente impulsado por alguna API de Microsoft que determinó, en función de las redes sociales extraídas, que no era solvente”, dijo Whittaker. “nunca voy a saber [because] no hay ningún mecanismo para que yo sepa esto”.

No es el capital ese es el problema. Más bien, es la jerarquía de poder actual, dice Whittaker.

“He estado en la mesa durante 15 años, 20 años. He estado en la mesa. Estar en la mesa sin electricidad no es nada”, continuó.

Por supuesto, lograr un cambio estructural es mucho más difícil que buscar dinero en efectivo, particularmente cuando el cambio estructural no necesariamente favorecerá a los poderes fácticos. Y Whittaker advierte lo que podría pasar si no hay suficiente resistencia.

A medida que se acelera el progreso en la IA, los impactos sociales también se aceleran, y continuaremos avanzando por un «camino lleno de publicidad hacia la IA», dijo, «donde ese poder se arraiga y se naturaliza bajo la apariencia de inteligencia y somos vigilados para el punto [of having] muy, muy poca agencia sobre nuestras vidas individuales y colectivas”.

Eso debería dar pausa a la industria. Ya sea en realidad voluntad es otro asunto Eso es probablemente algo de lo que oiremos hablar cuando suba al escenario en Disrupt en septiembre.

Aquí están los otros titulares de AI de nota de los últimos días:

- La IA de DeepMind controla los robots: DeepMind dice que ha desarrollado un modelo de IA, llamado RoboCat, que puede realizar una variedad de tareas en diferentes modelos de brazos robóticos. Eso por sí solo no es especialmente novedoso. Pero DeepMind afirma que el modelo es el primero en poder resolver y adaptarse a múltiples tareas y hacerlo utilizando diferentes robots del mundo real.

- Los robots aprenden de YouTube: Hablando de robots, el profesor asistente del Instituto de Robótica CMU, Deepak Pathak, presentó esta semana VRB (Vision-Robotics Bridge), un sistema de IA diseñado para entrenar sistemas robóticos al observar una grabación de un ser humano. El robot busca algunos datos clave, incluidos los puntos de contacto y la trayectoria, y luego intenta ejecutar la tarea.

- Otter se mete en el juego del chatbot: El servicio de transcripción automática Otter anunció esta semana un nuevo chatbot impulsado por IA que permitirá a los participantes hacer preguntas durante y después de una reunión y los ayudará a colaborar con sus compañeros de equipo.

- La UE pide una regulación de la IA: Los reguladores europeos se encuentran en una encrucijada sobre cómo se regulará la IA y, en última instancia, se utilizará comercial y no comercialmente en la región. Esta semana, el grupo de consumidores más grande de la UE, la Organización Europea de Consumidores (BEUC), intervino con su propia posición: Deje de arrastrar los pies y «inicie investigaciones urgentes sobre los riesgos de la IA generativa» ahora, dijo.

- Vimeo lanza funciones impulsadas por IA: Esta semana, Vimeo anunció un conjunto de herramientas impulsadas por IA diseñadas para ayudar a los usuarios a crear guiones, grabar imágenes usando un teleprompter incorporado y eliminar pausas largas y disfluencias no deseadas como «ahs» y «ums» de las grabaciones.

- Capital para voces sintéticas: ElevenLabs, la plataforma viral impulsada por IA para crear voces sintéticas, ha recaudado 19 millones de dólares en una nueva ronda de financiación. ElevenLabs cobró fuerza bastante rápido después de su lanzamiento a finales de enero. Pero la publicidad no siempre ha sido positiva, particularmente una vez que los malos actores comenzaron a explotar la plataforma para sus propios fines.

- Convertir audio en texto: Gladia, una startup francesa de IA, ha lanzado una plataforma que aprovecha el modelo de transcripción Whisper de OpenAI para, a través de una API, convertir cualquier audio en texto casi en tiempo real. Gladia promete que puede transcribir una hora de audio por $ 0,61, y el proceso de transcripción demora aproximadamente 60 segundos.

- Harness adopta la IA generativa: Harness, una startup que crea un conjunto de herramientas para ayudar a los desarrolladores a operar de manera más eficiente, esta semana inyectó a su plataforma un poco de IA. Ahora, Harness puede resolver automáticamente fallas de construcción e implementación, encontrar y corregir vulnerabilidades de seguridad y hacer sugerencias para controlar los costos de la nube.

Otros aprendizajes automáticos

Esta semana fue CVPR en Vancouver, Canadá, y desearía haber ido porque las charlas y los documentos parecen muy interesantes. Si solo puede ver uno, consulte el discurso de apertura de Yejin Choi sobre las posibilidades, imposibilidades y paradojas de la IA.

Créditos de imagen: CVPR/YouTube

El profesor de la UW y beneficiario de la beca MacArthur Genius primero abordó algunas limitaciones inesperadas de los modelos más capaces de la actualidad. En particular, GPT-4 es realmente malo en la multiplicación. No logra encontrar correctamente el producto de dos números de tres dígitos a una velocidad sorprendente, aunque con un poco de persuasión puede hacerlo bien el 95 % de las veces. ¿Por qué importa que un modelo de lenguaje no pueda hacer matemáticas? Porque todo el mercado de IA en este momento se basa en la idea de que los modelos de lenguaje se generalizan bien para muchas tareas interesantes, incluidas cosas como hacer impuestos o contabilidad. El punto de Choi fue que deberíamos buscar las limitaciones de la IA y trabajar hacia adentro, no al revés, ya que nos dice más sobre sus capacidades.

Las otras partes de su charla fueron igualmente interesantes y estimulantes. Puedes verlo completo aquí.

Rod Brooks, presentado como un «asesino de la exageración», brindó una historia interesante de algunos de los conceptos básicos del aprendizaje automático, ¡conceptos que solo parecen nuevos porque la mayoría de las personas que los aplican no estaban presentes cuando se inventaron! Retrocediendo a través de las décadas, toca a McCulloch, Minsky, incluso Hebb, y muestra cómo las ideas se mantuvieron relevantes mucho más allá de su tiempo. Es un recordatorio útil de que el aprendizaje automático es un campo que se encuentra sobre los hombros de gigantes que se remontan a la era de la posguerra.

Se enviaron y presentaron muchos, muchos artículos en el CVPR, y es reductivo mirar solo a los ganadores de los premios, pero esto es un resumen de noticias, no una revisión exhaustiva de la literatura. Esto es lo que los jueces de la conferencia pensaron que era lo más interesante:

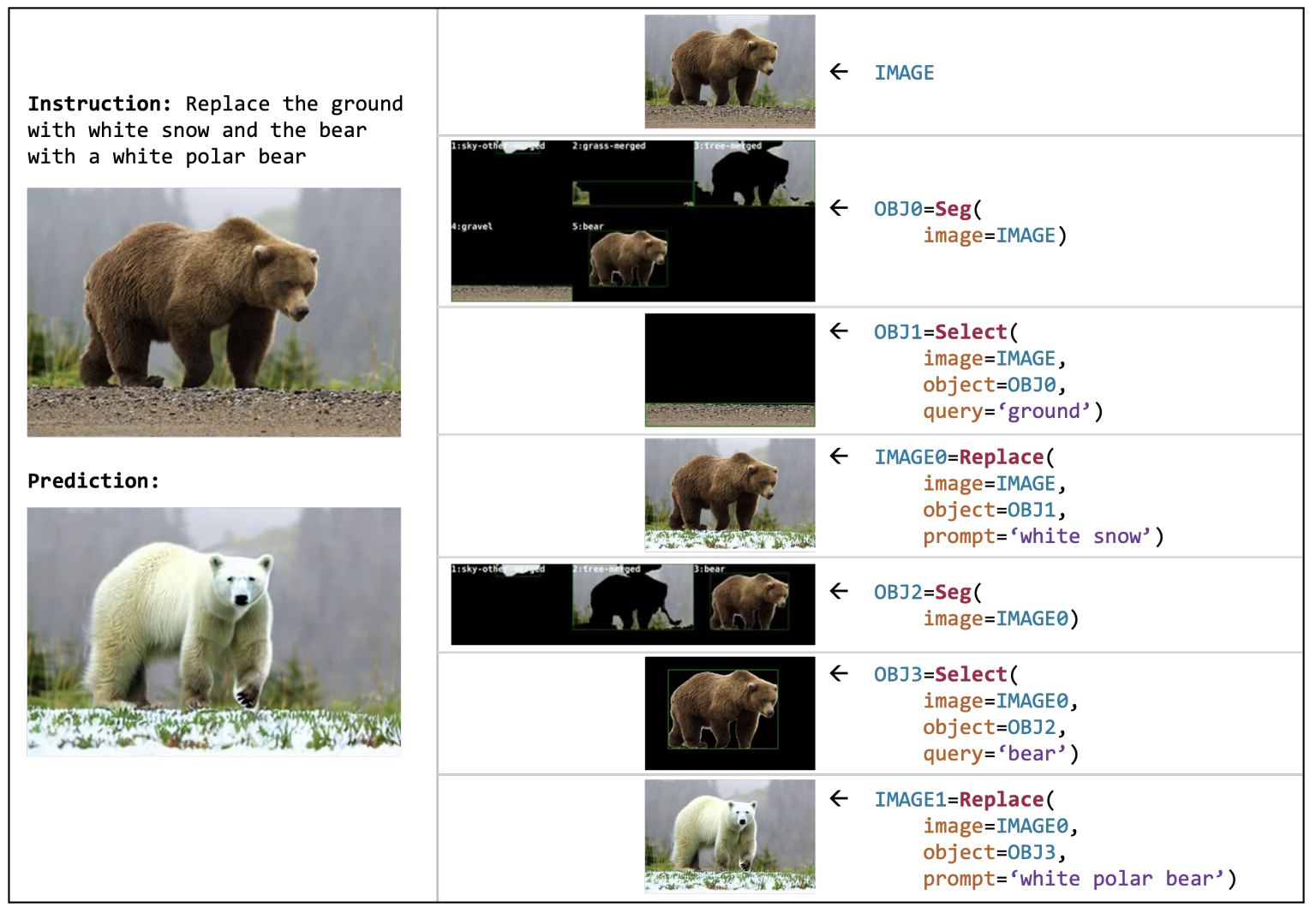

Créditos de imagen: AI2

VISPROG, de los investigadores de AI2, es una especie de metamodelo que realiza tareas complejas de manipulación visual utilizando una caja de herramientas de código multipropósito. Digamos que tiene una imagen de un oso grizzly en un poco de hierba (como se muestra en la imagen), puede decirle que simplemente «reemplace el oso con un oso polar en la nieve» y comienza a funcionar. Identifica las partes de la imagen, las separa visualmente, busca y encuentra o genera un reemplazo adecuado, y vuelve a unir todo de manera inteligente, sin necesidad de más indicaciones por parte del usuario. La interfaz de «mejora» de Blade Runner está empezando a parecer francamente peatonal. Y esa es solo una de sus muchas capacidades.

La “conducción autónoma orientada a la planificación”, de un grupo de investigación multiinstitucional chino, intenta unificar las diversas piezas del enfoque bastante fragmentario que hemos adoptado para los automóviles autónomos. Por lo general, existe una especie de proceso gradual de «percepción, predicción y planificación», cada uno de los cuales puede tener una serie de subtareas (como segmentar personas, identificar obstáculos, etc.). Su modelo intenta poner todo esto en un solo modelo, algo así como los modelos multimodales que vemos que pueden usar texto, audio o imágenes como entrada y salida. De manera similar, este modelo simplifica de alguna manera las complejas interdependencias de una pila de conducción autónoma moderna.

DynIBaR muestra un método robusto y de alta calidad para interactuar con video utilizando «campos de radiación neuronal dinámicos» o NeRF. Una comprensión profunda de los objetos en el video permite cosas como la estabilización, los movimientos del carro y otras cosas que generalmente no espera que sean posibles una vez que el video ya se ha grabado. De nuevo… «mejorar». Este es definitivamente el tipo de cosas para las que Apple te contrata y luego se lleva el crédito en la próxima WWDC.

Puede que recuerde DreamBooth de un poco antes de este año cuando la página del proyecto se puso en marcha. Es el mejor sistema hasta ahora para, no hay forma de decirlo, hacer deepfakes. Por supuesto que es valioso y poderoso hacer este tipo de operaciones de imagen, sin mencionar la diversión, e investigadores como los de Google están trabajando para que sea más fluido y realista. Consecuencias… más tarde, tal vez.

El premio al mejor trabajo de estudiante se otorga a un método para comparar y combinar mallas o nubes de puntos 3D; francamente, es demasiado técnico para mí tratar de explicarlo, pero esta es una capacidad importante para la percepción del mundo real y las mejoras son bienvenidas. Consulte el documento aquí para obtener ejemplos y más información.

Solo dos pepitas más: Intel mostró este interesante modelo, LDM3D, para generar imágenes 3D 360 como entornos virtuales. Entonces, cuando estás en el metaverso y dices «pónganos en una ruina cubierta de maleza en la jungla», simplemente crea uno nuevo a pedido.

Y Meta lanzó una herramienta de síntesis de voz llamada Voicebox que es muy buena para extraer características de las voces y replicarlas, incluso cuando la entrada no es limpia. Por lo general, para la replicación de voz necesita una buena cantidad y variedad de grabaciones de voz limpias, pero Voicebox lo hace mejor que muchos otros, con menos datos (piense en 2 segundos). Afortunadamente, mantienen a este genio en la botella por ahora. Para aquellos que piensan que podrían necesitar que les clonen la voz, consulten Acapela.