Hay innumerables razones por las que los robots domésticos han tenido poco éxito después de Roomba. El precio, la practicidad, el factor de forma y el mapeo han contribuido a un fracaso tras otro. Incluso cuando se aborden algunos o todos ellos, queda la cuestión de qué sucede cuando un sistema comete un error inevitable.

Este también ha sido un punto de fricción a nivel industrial, pero las grandes empresas tienen los recursos para abordar los problemas a medida que surgen. Sin embargo, no podemos esperar que los consumidores aprendan a programar o contratar a alguien que pueda ayudar cada vez que surja un problema. Afortunadamente, este es un gran caso de uso para modelos de lenguajes grandes (LLM) en el espacio de la robótica, como lo ejemplifica una nueva investigación del MIT.

Un estudio que se presentará en la Conferencia Internacional sobre Representaciones del Aprendizaje (ICLR) en mayo pretende aportar un poco de “sentido común” al proceso de corrección de errores.

«Resulta que los robots son excelentes imitadores», explica la escuela. «Pero a menos que los ingenieros también los programen para adaptarse a cada posible golpe y empujón, los robots no necesariamente saben cómo manejar estas situaciones, a menos que comiencen su tarea desde arriba».

Tradicionalmente, cuando un robot encuentra problemas, agota sus opciones preprogramadas antes de requerir intervención humana. Este es un desafío particular en un entorno no estructurado como un hogar, donde cualquier cantidad de cambios en el status quo puede afectar negativamente la capacidad de funcionamiento de un robot.

Los investigadores detrás del estudio señalan que si bien el aprendizaje por imitación (aprender a realizar una tarea mediante la observación) es popular en el mundo de la robótica doméstica, a menudo no puede explicar las innumerables pequeñas variaciones ambientales que pueden interferir con el funcionamiento normal, por lo que requieren un sistema. para reiniciar desde el punto de partida. La nueva investigación aborda esto, en parte, dividiendo las manifestaciones en subconjuntos más pequeños, en lugar de tratarlas como parte de una acción continua.

Aquí es donde los LLM entran en escena, eliminando la necesidad de que el programador etiquete y asigne las numerosas subacciones manualmente.

“Los LLM tienen una manera de indicarle cómo realizar cada paso de una tarea, en lenguaje natural. La demostración continua de un ser humano es la encarnación de esos pasos, en el espacio físico”, dice el estudiante de posgrado Tsun-Hsuan Wang. «Y queríamos conectar los dos, de modo que un robot supiera automáticamente en qué etapa se encuentra una tarea y pudiera replanificar y recuperarse por sí solo».

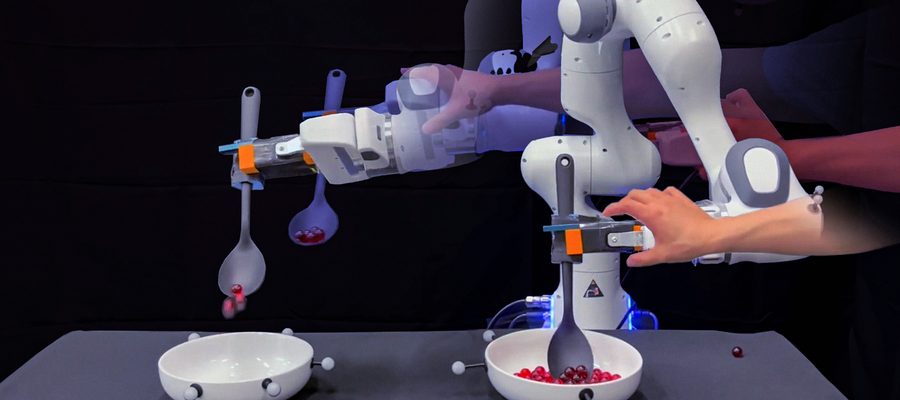

La demostración particular presentada en el estudio implica entrenar a un robot para que recoja canicas y las vierta en un recipiente vacío. Es una tarea simple y repetible para los humanos, pero para los robots es una combinación de varias tareas pequeñas. Los LLM son capaces de enumerar y etiquetar estas subtareas. En las demostraciones, los investigadores sabotearon la actividad en pequeñas formas, como desviar al robot de su curso y sacar canicas de su cuchara. El sistema respondió autocorrigiendo las pequeñas tareas, en lugar de empezar desde cero.

«Con nuestro método, cuando el robot comete errores, no necesitamos pedirle a los humanos que programen ni hacer demostraciones adicionales de cómo recuperarse de fallas», añade Wang.

Es un método convincente para ayudar a evitar perder completamente la cabeza.