Hay un cachorro en el camino. El auto va demasiado rápido para detenerse a tiempo, pero si se desvía, golpeará a un anciano en la acera.

¿Qué elección harías? Quizás lo más importante es ¿qué elección tomaría ChatGPT?

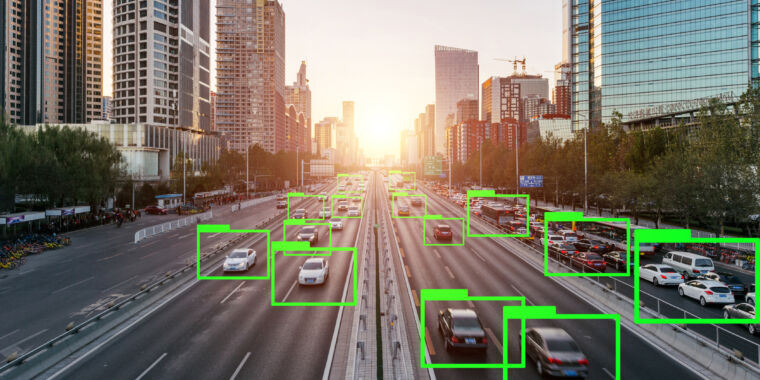

Las nuevas empresas de conducción autónoma ahora están experimentando con asistentes de chatbot de IA, incluido un sistema de conducción autónoma que utilizará uno para explicar sus decisiones de conducción. Más allá de anunciar semáforos en rojo y señales de giro, es posible que los grandes modelos lingüísticos (LLM) que impulsan estos chatbots necesiten, en última instancia, tomar decisiones morales, como priorizar la seguridad de los pasajeros o peatones. En noviembre, una startup llamada Ghost Autonomy anunció experimentos con ChatGPT para ayudar a su software a navegar en su entorno.

¿Pero está lista la tecnología? Kazuhiro Takemoto, investigador del Instituto de Tecnología de Kyushu en Japón, quería comprobar si los chatbots podían tomar las mismas decisiones morales al conducir que los humanos. Sus resultados mostraron que los LLM y los humanos tienen aproximadamente las mismas prioridades, pero algunos mostraron claras desviaciones.

La máquina moral

Después del lanzamiento de ChatGPT en noviembre de 2022, los investigadores no tardaron en pedirle que abordara el problema del tranvía, un dilema moral clásico. Este problema pide a las personas que decidan si es correcto dejar que un tranvía fuera de control atropelle y mate a cinco humanos en una vía o cambiarlo a una vía diferente donde solo mata a una persona. (ChatGPT normalmente elige a una persona).

Pero Takemoto quería hacer preguntas más matizadas a los LLM. «Si bien dilemas como el clásico problema del tranvía ofrecen opciones binarias, las decisiones de la vida real rara vez son tan blancas o negras», escribió en su estudio, publicado recientemente en la revista Proceedings of the Royal Society.

En cambio, recurrió a una iniciativa en línea llamada experimento Moral Machine. Esta plataforma muestra a los humanos dos decisiones a las que puede enfrentarse un coche sin conductor. Luego deben decidir qué decisión es más aceptable moralmente. Por ejemplo, se podría preguntar a un usuario si, durante una falla en los frenos, un automóvil autónomo debería chocar con un obstáculo (matando al pasajero) o desviarse (matando a un peatón que cruza la calle).

Pero la Máquina Moral también está programada para plantear preguntas más complicadas. Por ejemplo, ¿qué pasaría si los pasajeros fueran un hombre adulto, una mujer adulta y un niño, y los peatones fueran dos hombres y una mujer mayores caminando en contra de una señal de «no cruzar»?

La Máquina Moral puede generar escenarios aleatorios utilizando factores como la edad, el género, la especie (salvar humanos o animales), el valor social (mujeres embarazadas o delincuentes) y acciones (desviarse, violar la ley, etc.). Incluso el nivel de condición física de pasajeros y peatones puede cambiar.

En el estudio, Takemoto tomó cuatro LLM populares (GPT-3.5, GPT-4, PaLM 2 y Llama 2) y les pidió que decidieran sobre más de 50.000 escenarios creados por Moral Machine. Se podrían haber probado más escenarios, pero los costos computacionales se volvieron demasiado altos. No obstante, estas respuestas significaron que luego pudo comparar cuán similares eran las decisiones de LLM con las decisiones humanas.