Inflection AI, una nueva empresa fundada por el exdirector de Deep Mind y respaldada por Microsoft y Nvidia, recaudó la semana pasada 1300 millones de dólares de pesos pesados de la industria en efectivo y crédito en la nube. Parece que la compañía usará el dinero para construir un grupo de supercomputadoras alimentado por hasta 22,000 GPU de cómputo H100 de Nvidia, que tendrán un rendimiento de potencia de cómputo teórico máximo comparable al de la supercomputadora Frontier.

«Estaremos construyendo un grupo de alrededor de 22,000 H100», dijo Mustafa Suleyman, fundador de DeepMind y cofundador de Inflection AI, informa Reuters. «Esto es aproximadamente tres veces más cómputo que lo que se usó para entrenar todo GPT-4. La velocidad y la escala son lo que realmente nos permitirá construir un producto diferenciado».

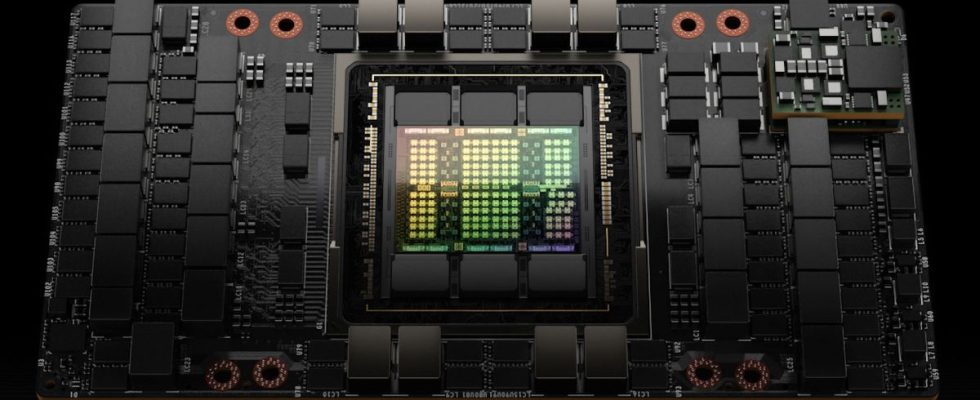

Un clúster alimentado por 22 000 GPU de cómputo Nvidia H100 es teóricamente capaz de 1,474 exaflops de rendimiento FP64, eso es usando los núcleos Tensor. Con el código general FP64 ejecutándose en los núcleos CUDA, el rendimiento máximo es solo la mitad de alto: 0,737 FP64 exaflops. Mientras tanto, la supercomputadora más rápida del mundo, Frontier, tiene un rendimiento de cómputo máximo de 1,813 FP64 exaflops (el doble a 3,626 exaflops para operaciones matriciales). Eso coloca a la nueva computadora planificada en el segundo lugar por ahora, aunque puede caer al cuarto después de que El Capitán y Aurora estén completamente en línea.

Si bien el rendimiento del FP64 es importante para muchas cargas de trabajo científicas, es probable que este sistema sea mucho más rápido para las tareas orientadas a la IA. El rendimiento máximo de FP16/BF16 es de 43,5 exaflops y el doble a 87,1 exaflops para el rendimiento de FP8. La supercomputadora Frontier con tecnología de 37 888 de Instinct MI250X de AMD tiene un rendimiento máximo de BF16/FP16 de 14,5 exaflops.

Se desconoce el costo del clúster, pero teniendo en cuenta que las GPU de cómputo H100 de Nvidia se venden al por menor por más de $ 30,000 por unidad, esperamos que las GPU para el clúster cuesten cientos de millones de dólares. Agregue todos los servidores en rack y otro hardware y eso representaría la mayor parte de los $ 1.3 mil millones en financiamiento.

Inflection AI está actualmente valorado en alrededor de $ 4 mil millones, aproximadamente un año después de su fundación. Su único producto actual es un chatbot de inteligencia artificial generacional llamado Pi, abreviatura de inteligencia personal. Pi está diseñado para servir como un asistente personal impulsado por IA con tecnología de IA generativa similar a ChatGPT que respaldará la planificación, la programación y la recopilación de información. Esto permite que Pi se comunique con los usuarios a través del diálogo, lo que hace posible que las personas hagan consultas y ofrezcan comentarios. Entre otras cosas, Inflection AI ha definido objetivos de experiencia de usuario específicos para Pi, como ofrecer apoyo emocional.

En la actualidad, Inflection AI opera un clúster basado en 3584 GPU de cómputo Nvidia H100 en la nube de Microsoft Azure. El clúster de supercomputación propuesto ofrecería aproximadamente seis veces el rendimiento de la solución actual basada en la nube.